Archive for the ‘analytics’ Category

Datenschutzregelungen sind zu kompliziert – selbst für die Netzgemeinde

Auf der Suche nach beispielhaften Datenschutzerklärungen könnte man auf die Idee kommen, bei Leuten nachzuschauen, die sich damit auskennen. Man schaut ja auch in den HTML-Code einer Seite, die einem gefällt (ich mache das zumindest so). Was liegt also näher, bei der digitalen gesellschaft, beim D64 oder der re:publica nach einer gesetzeskonformen Datenschutzerklärung zu suchen?

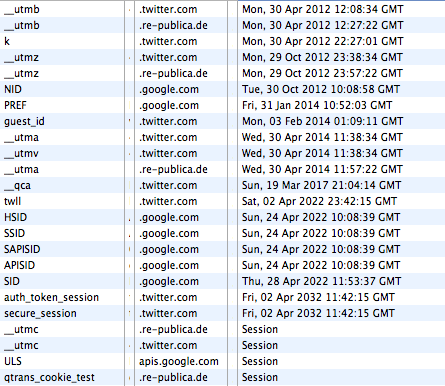

Die Site der re:publica geht recht freigiebig mit den Daten der Nutzer um. Twitter und Google setzen gleich mal 10-Jahres-Cookies. (Quelle: http://re-publica.de/12/impressum/)

Was eine “gesetzeskonforme Datenschutzerklärung” grundsätzlich bieten müsste, erklärt zum Beispiel e-recht24.de. Und tatsächlich scheint die Datenschutzerklärung von D64 eine sehr gute Einsicht zu geben, welche Daten, von welchem Anbieter zu welchem Zweck erhoben werden. Die PlugIns von twitter und facebook werden aufgezählt und selbst Askimet (eine WordPress-Plugin zur Spam-Erkennung) wird erwähnt. Vorbildlich. Wäre da nicht auf der Homepage ein Video von vimeo eingebunden. Dieses PlugIn wiederum verwendet offensichtlich Google Analytics wodurch interessanterweise die letzte Video-Suche auf Google via D64 zu vimeo gelangt und dort wieder mit Google verknüpft wird. Von solchen Datenflüssen und dem Zweck der Speicherung erfahre ich als User nicht und kann also weder still zustimmen noch Einspruch erheben.

Bei der Digitalen Gesellschaft gibt es zwar ein reisserisches Statement über das Engagement des Vereins für den Schutz der privaten Daten, selbst äussert man sich aber eher zurückhaltend. Oder anders: es gibt keine explizite Datenschutzerklärung. Selbst im Impressum findet sich eine solche nicht. Als Tracker kommt Piwik zum Einsatz. Von aussen ist nicht einsehbar, ob das System so konfiguriert ist, dass die IP-Nummern anonymisiert werden. Zusätzlich setzt der Server noch eine PHP-Session-ID und diverse Google-Analytics-Cookies über das twitter-PlugIn. Darunter auch die Information, dass dieser Browser irgendwann mal auf favstar.fm war. Ein Cookie nennt sich “__qca” und kommt von einer Firma namens Quantcast, eindeutig von der dunklen Seite der Macht. Volle fünf Jahre soll dieser Cookie Bestand haben.

Auch die Netzpolitiker der CDU hinken jedem popeligen Netzshop in Sachen Datenschutzerklärung hinterher. Sie haben einfach keine. Allerdings sind sie in Bezug auf Social-PlugIns wenigstens weiter als die Digitale Gesellschaft. Denn sie verwenden wenigstens die Opt-[Korrektur]In[/Korrektur]-Version. Allerdings ist bei einer oberflächlichen Recherche nicht zu ermitteln, warum ein Cookie gesetzt wird, dass zum Beispiel den ursprünglichen Referrer für mindestens ein halbes Jahr an den Server schickt.

Vielleicht hat ja die re:publica eine vernünftige Datenschutzerklärung? Immerhin steht sie dieses Jahr unter dem Motto ACT!ON und es geht unter anderem um die Gefahren für Aktivisten durch Überwachungssoftware. Im Impressum findet sich nichts und eine explizite Datenschutzerklärung findet sich gar nicht. Aber warum auch, immerhin setzen die Veranstalter auf “den gesunden Menschenverstand”. Meint bestimmt, dass man vor dem Aufruf der Seite erstmal nachschaut, welche Daten erhoben und wie diese verwendet werden. Man könnte sich ja vielleicht den Vortrag “Die Gesetze der Daten” anhören. Denn “Der Datenschutz wird uns nicht helfen können” ist doch eine einleuchtende Legitimation für die fehlende Sensibilität der Speerspitze der Netzgemeinde in Sachen Datenschutz für ihre eigenen User.

Die Funktion von Cookies aus Nutzer- und aus Betreibersicht

tl;dr. Unterscheidet man den Nutzen von Cookies nach ihrer Funktion für User und der Funktion für Anbieter wird deutlich, dass Cookies der Lebenssaft der digitalen Branche sind. Für die User bieten sie aber nur marginale Vorteile. Die Branche wird nicht aufhören immer mehr Daten zu sammeln, bis eine lückenlose Vorratsdatenspeicherung über jeden Nutzer existiert.

Die Firma nugg.ad (Tochter der Deutschen Post DHL) ist einer der größten deutschen Trageting-Dienstleister und lebt davon, dass auf einer Seite Cookies von einer anderen Seite gesetzt und gelesen werden können. Ist diese Funktion ausgeschaltet kann nugg.ad kein Profil erstellen.

Http ist an sich zustandslos. Das meint, dass der Aufrufende (“gib mir folgende Datei”) vom Vorhaltenden (“hier hast du die Datei”) nicht erkannt werden kann. Ohne weiteres weiß er nicht, wer da grade dieses Bild will und in welchem Kontext er sich grade befindet. Und damit fängt das Dilemma an.

Prinzipiell gibt es unterschiedliche Interessen für die (Wieder)Erkennung von Nutzern. Im Folgenden werden zuerst die Interessen der Nutzer dargestellt und danach die der Anbieter. Aus der Gegenüberstellung wird deutlich, dass Cookies im Interesse, ja sogar die Basis vieler Business-Modelle der (meisten) Anbieter sind. Für die Nutzer sind sie jedoch in den meisten Fällen ein lässliches Ärgernis und oft auch die falsche Technik.

Die Nutzerinteressen

Aus Nutzersicht ist eine Request-übergreifende (“der User folgt einem internen Link”) oder eine Session-übergreifende (“der User kommt nochmals auf die Site”) Zuordnung zu unterscheiden. Die Wiedererkennung bietet erstens eine komfortable Anmeldung oder/und die Personalisierung von Inhalten oder Formaten.

Die automatische Anmeldung ist ohne Frage eine hilfreiche Funktion. Es gibt allerdings dafür http-Authentifizierung. Ein bestimmter Bereich verlangt eine Authentifizierung und ohne ein gültiges Login und Passwort sieht man nichts. Alle Browser verfügen über einen eingebauten Mechanismus, sich auf Wunsch diese Anmeldungen zu merken. Und über https gibt es auch die maximal derzeit verfügbare Sicherheit*. Cookies sind für diese Funktion absolut überflüssig.

Personalisierung bedeutet, dass der Nutzer bewusst oder unbewusst das Verhalten, respektive das Aussehen einer Seite oder einer Site verändert.

Beginnen wir mit dem bewussten Verhalten. Sitebetreiber finden es manchmal eine gute Idee: der Nutzer habe doch bestimmt seine eigenen Präferenzen und möchte sich die Seite einrichten nach seinem Gusto. Deutlich zu sehen bei der DRadio-Wissen-Seite oder bei der letzten Version von Xing. Man kann Inhaltsboxen hin und her schieben und sich damit die “Startseite” anpassen. Diese Einstellung wäre natürlich sinnlos, wenn man beim nächsten Aufruf alles wiederholen müsste. (Nun finden lustigerweise wenig ausgewiesene Experten Personalisierung toll. Prominentes Beispiel war hier Bertelsmann mit Bol. Die hatten in New York am Time Square mal 50 Datenbankenexperten sitzen, die sich mit dem Speichern von User-Preferenzen beschäftigen sollten. Bol hat es bekanntermaßen nicht weit geschafft.)

Aber auch das unbewusste Verhalten eines Nutzers kann Einfluss auf das Aussehen und den Inhalt einer Seite haben. Allein durch die aufeinanderfolgenden Klicks oder durch Aktionen in der Vergangenheit könnte ein Nutzer vermitteln, was er eigentlich sucht und was man ihm daher anbieten soll. Dieses Verfahren wird Behavioral Targeting genannt. Prominentestes Beispiel ist Amazon mit der Liste ähnlicher Produkte. Diese Liste wird in Abhängigkeit von meinem bisherigen Verhalten momentan oder meiner Kaufhistorie variiert. Ein großer Teil von Amazons Erfolg geht auf diese Funktion zurück, die man sich damals bei der Firma Net Perceptions gekauft hat.

Innerhalb einer Session würde sowohl die Anpassung an das bewusste als auch an das unbewusste Verhalten mit Hilfe von Session-IDs funktionieren. Diese werden als Parameter über die URL von einer Seite zur nächsten übergeben**. Session-übergreifend funktioniert dieses Verfahren nicht, da nicht gewährleistet werden kann, dass die URL nach wie vor von dem ursprünglichen Browser aufgerufen wurde.

Die Personalisierung – egal ob auf der Basis von bewusstem oder unbewusstem Verhalten – ist jedoch generell problematisch. Heute nutzen die User Sites in verschiedenen Situationen. Auf der Arbeit mit dem Firmen-PC, auf dem Weg nach Hause mit dem Handy, zu Hause mit dem Tablet u.s.w. Eine Personalisierung könnte dann also nur funktionieren, wenn die Cookies mitgenommen würden. Das werden sie momentan*** nicht. Ausserdem sind die Geräte jeweils so unterschiedlich, dass die Webseiten sowieso verschieden aussehen.

Die Anbieterinteressen

Vor der Erfindung der Cookies stand die Frage von Henry Ford, welche Hälfte der Marketingausgaben denn wohl umsonst ist. Denn dass nicht jede Kommunikation bei den Empfängern auf fruchtbaren Boden fällt ist klar. Der Tampon-Spot im StarTrek-Werbeblock könnte vergebene Liebesmüh sein. Das Banner für das iX-Abo auf gofeminin scheint deplatziert.

Henry Ford würde heute feststellen, dass es doch am besten wäre, die Kommunikation für jeden einzelnen Empfänger anzupassen. Denn sicher gibt es für jeden einen bestimmten Schlüsselreiz, der ihn dazu bringt, sofort den Scheck zu unterschreiben. Was wie ein Horroszenario klingt ist nur das fertige Bild, wenn man heutige Puzzlesteine zusammensetzt.

Mit Hilfe von Cookies kann erkannt werden:

- ob ein Nutzer bereits auf der aktuellen Seite war,

- und wenn ja, was er sich angesehen hat,

- dort bereits etwas gekauft hat und wenn ja,

- was er dort gekauft hat,

- ob er irgendeine Werbung dieser Seite gesehen hat und wenn ja,

- welche Werbung dieser Site er gesehen hat und

- ob er diese geklickt hat,

- ob er (auf der Seite auf der diese Werbung ist) bisher überhaupt mal war,

- und wenn ja, welche Werbung er dort schon mal gesehen und

- möglicherweise geklickt hat,

- welche Themen er sich auf verschiedenen Seiten ansieht.

Etliche Szenarien sind nur möglich, wenn verschiedene Teilnehmer Daten austauschen. Dies geschieht schon länger. Deutlich wird, dass immer öfter Konkurrenten über ein Intermediate zusammenarbeiten. Der Vorteil der verbesserten Daten ist tatsächlich höher zu bewerten als die Tatsache, dass ein Wettbewerber Informationen erhält.

Dabei spielt es übrigens keine Rolle, ob die Daten personalisierbar sind. Im Gegenteil: personenbezogene Daten neigen zu Korrosion wenn Nutzer ihre Wohn- oder Mailadressen ändern, heiraten oder das Konto wechseln.

Cookies bieten damit ganz abstrakt die Möglichkeit einer vollständigen Vorratsdatenspeicherung aller Interaktionen eines Nutzers im Web. Und mit dieser Historie lassen sich komplette Persönlichkeitsprofile bilden, Verhaltensmuster in Cluster zusammenfassen. Basierend darauf können Kommunikationsmaßnahmen und -inhalte so gesteuert werden, dass die Response-Rate optimal ist. Also die Wirkung des Marketings nicht weiter verbessert werden kann. Dabei umfassen Kommunikationsmaßnahmen nicht nur Banner und TV-Spots.

Inhalt und Stil eines Zeitungsartikels kann genauso customized werden wie Produktname und vermeintlicher Hersteller. Es könnte ja sein, dass eine kleine Gruppe von Usern durchaus Nivea kaufen würde, wenn man sie nur in eine Steampunk-Packung füllt und sie nach Prinzessin Leia benennt. Der Makerbot im Netto um die Ecke macht es möglich.

Sicher eine lustige Vorstellung. Wenn es jedoch um Krankenversicherung, Job-Angebote, politische Meinungsäusserung und Reisefreiheit geht und damit letztlich um eine durchlässige Gesellschaft, dürfte vielen das Lachen im Halse steckenbleiben.

Und es bleibt festzustellen, dass existierende Daten immer Begehrlichkeiten wecken.

—

Über mich: In der c’t 6/96 erschien mein letzter Artikel für die Zeitschrift mit dem Titel “Faules Backwerk – Auf dem Weg zum gläsernen Web-Surfer” http://www.heise.de/ct/artikel/Faules-Backwerk-284550.html . Seitdem arbeite ich mehr oder weniger permanent als Experte für Web-Analyse. Meistens mit Tools von Drittanbietern, oft aber auch mit selbst entwickelter oder mindestens selbst entworfener Software. Jenseits von Logfile-Analyse gibt es heute keine relevante Lösung, die ohne Cookies auskommt. Eine der wesentlichen Merkmale der Branche ist nach meiner Meinung ein Wettrüsten um die Datenqualität und -granularität. Die Interessen der Nutzer vertritt in diesem Wettkampf niemand.

—

*) Zumindest mehr als derzeit mit Cookies.

**) Session-IDs in der URL haben insbesondere wg. Suchmaschinen und Bookmarks oder URL-Weitergabe einen schlechten Ruf. Das sind aber Probleme die längt gelöst sind.

***) Alle Browserhersteller arbeiten daran, die Cookies über zentrale Services zu synchronisieren.

EU-Datenschutzverordnung: Sollbruchstelle Jugendschutz

Die Initiatve der EU-Kommissarin Vivian Reding mit einer Verordnung zum Datenschutz eine europaweite Grundlage zu schaffen liest sich in weiten Teilen wie die Wort gewordenen Träume aller Datenschützer. Opt-In ist für die meisten Datenerhebungen Standard. Der Export der Daten und damit die Plattform-Unabhängigkeit ist vorgeschrieben. Und schliesslich müssen Systeme so gestaltet sein, dass alle personenbezogenen Daten unwiederbringlich gelöscht werden können müssen.

Allerdings findet sich an mehreren Stellen eine Regel, die das Zeug zum Dealbraker hat. Für fast alle Punkte gibt, dass Funktionen Kinder ausschliessen müssen. Mit Kindern sind alle Personen unter 18 Jahren gemeint. Unter Umständen sind die Erhebung und Verarbeitung noch gestattet, wenn das Einverständnis der Eltern vorliegt.

Damit kann eine komplette Branche nur noch dann arbeiten, wenn Clients eine minimale Information über das Alter des Nutzers an den Service sendet. Denn andernfalls muss der Betreiber damit rechnen, dass es sich möglicherweise um ein Kind handelt, dessen Daten er unter keinen Umständen erfassen und verarbeiten darf.

Solange diese Altersübermittlung nicht existiert dürfen eigentlich keine Daten mehr erhoben werden oder zumindest nicht verwertet werden bis eindeutig klar ist (z.B. durch eine Anmeldung mit Altersindiz), dass es sich nicht um ein Kind handelt. Das dürfte somit das vorläufige Ende von Bannerwerbung und Targeting sein, wie wir es kennen.

Begründet wird der besondere Schutz übrigens mit der Naivität der Kinder. Wobei ich manchmal den Eindruck habe, dass da die Politiker von sich ausgehen und annehmen, dass die Kinder noch weniger von der Technik verstehen als sie selbst. Was für ein Fehlschluss.

Cached Canvas-Image als Cookie-Ersatz

Im Rahmen einer Recherche habe ich mich mal eingehender mit der Funktionsweise und Browser-Kompatibilität von Cookie-Replacements beschäftigt. Als einzig sicheres, performantes und valides Verfahren stellt sich Cached-Canvas-Image dar. Hier kurz die Funktionsweise:

Beim erstmaligen Besuch einer Site wird in ein Canvas-Element ein Bild mit einem Bitmuster geladen. Dieses Bild wird vom Server on the fly generiert und mit einem Cache-Stempel weit in der Zukunft an den Browser gesendet.

Ein Bitmuster mit der ID "aeaeaec9c9c94f4f4fc3c3c3ffffffcccccc1d1d1d919191ffffffaaaaaa"

Beim späteren Besuch lädt der Browser das Bitmuster-Bild aus dem Cache. Danach werden mittels JavaScript die Farbwerte für die Pixel des Bildes ermittelt und daraus zusammen mit einer eindeutigen ID, die der Server in die Seite geschrieben hat, an den Server gesendet, z.B. per weiteren Image-Load. Auf dem Server werden dann die eindeutige ID mit dem Profil der ID in dem Bitmuster-Bild verknüpft.

Eine Testimplementierung ergab, dass trotz der Verwendung von Canvas der ganze Prozess auf einem aktuellen Rechner nicht mehr als 1/10 Sekunde dauert und damit keine Hürde für den weitflächigen Einsatz darstellt. Interessant ist, dass dieses Verfahren auch Site-übergreifend funktioniert und damit die Beschränkung von Cookies bzgl. Domains aushebelt.

Eine Abwandlung dieses Verfahren würde auch ohne Canvas funktionieren müsste dann aber eine erhebliche Anzahl von Requests auf ungecachte Images durchführen.

In unseren Tests zeigen die Browser Safari, Chrome und Firefox alle unisono das gleiche Verhalten: die ID wird korrekt aus dem Bitmuster ermittelt und somit der Browser ohne Cookie identifizierbar.

Anti-Tracking-Tools wie Ghostery können ein solches Vorgehen auf einer Web-Seite nicht erkennen und damit auch nicht unterbinden. Es hilft einzig das regelmäßige Löschen des Browser-Caches oder das Abschalten von JavaScript.

Daten-Fee oder Datenvieh: Offene Fragen

Während meines Vortrags “Daten-Fee oder Datenvieh” und direkt danach vor Ort und online sind etliche Fragen gestellt worden, die ich hier zusammenfassen und beantworten möchte.

Welchen Wert haben die Daten die durch facebook, Google und andere “Social Plugins” erhoben werden?

Befindet sich auf einer Seite ein aktives Social Plugin, werden Daten über den Aufruf der Seite an die jeweiligen Anbieter (facebook, G+, twitter etc.) gesendet. Dabei spielt prinzipiell erst mal keine Rolle, ob der User (mit diesem Browser) aktuell bei dem jeweiligen Dienst angemeldet ist oder ob er dort überhaupt einen Account besitzt.

Da es sich bei den Anbietern um Black Boxes handelt, ist unklar, welche Verknüpfung direkt oder später zwischen diesen anonymen oder personalisierten Trackingdaten stattfindet. Aus Sicht der Qualität des Services von G+ und facebook ist eine solche Verknüpfung natürlich sinnvoll. Bleibt aber dennoch Spekulation.

Es gilt aber wie bei Targeting und Retargeting die Aussage, dass die Daten mit jedem weiteren Datum wertvoller werden. Und es ist keine Prophetie, wenn man sagt, dass diese Daten früher oder später verkauft werden. Entweder an verschiedene Kunden oder als Asset bei einer Übernahme.

Warum sollten denn die IP-Adressen aus den Logs entfernt werden wenn sie nicht (mehr) für die Auswertung herangezogen werden? (@alvar_f)

Natürlich zunächst mal, weil es geltendes Recht ist. Vor dem Hintergrund eines Zuviels an Gesetzen könnte man vielleicht darüber diskutieren, ob dieses nicht auf die Streichliste gehört. Allerdings deckt es ja auch andere und zukünftige Situationen ab. Denn mit der Verbreitung von IPv6 (MAC-Adresse) und einer zunehmenden Diversifizierung des Browsermarktes (“Fingerprinting”) wird dieser Punkt wieder extrem relevant.

Aber bevor man über ein “Zuviel” von Gesetzen diskutiert sollte man vielleicht mal über Datensparsamkeit nachdenken und die Web-Server-Logs ein wenig ausdünnen.

Führt Opt-In nicht zu einem Wust an Kleingedrucktem, das sowieso niemand durchliest?

Unter dem Titel “Datenschutztheater: Die informierte Zustimmung” hat Kristian Köhntopp im Kern folgende Aussage gemacht: die bisherigen Verfahren, die den Schutz der privaten Daten leisten sollen sind eigentlich reine Datenverwaltungsvorschriften. Es würde nicht um den Schutz der Daten gehen sondern darum, den Erheber der Daten vor Ansprüchen seitens der User zu schützen.

Tatsächlich würde ich ihm ohne Einschränkungen zustimmen. Bisherige Einverständniserklärungen sind ungeeignet den User über die Verwendung (Erhebung und Ziel der Verarbeitung) zu informieren.

Die Forderung muss also daher sein, den Sinn und Zweck der Erhebung in einfacher Sprache zu vermitteln. Wenn das nicht gelingt dürfen die Daten eben nicht erhoben werden.

Opt-In würde die Betreiber automatisch zu Datensparsamkeit zwingen. Denn es ist wesentlich schwerer, den Nutzer zu einem Einverständnis vor der Anmeldung zu überreden als ihm implizites Einverständnis unterzjubeln. Und ich bleibe bei meiner Aussage, dass – abgesehen von Profilern – die meisten Betreiber wesentlich mehr Daten erheben als sie später sinnvoll auswerten (können).

Das Thema Zertifikate und Siegel hat vdsetal weiter recherchiert und kommt zu sehr interessanten Aussagen.

Vortrag auf dem #28C3 – Daten-Fee oder Datenvieh

Auf dem 28C3 werde ich unter dem Titel Daten-Fee oder Datenvieh einen Vortrag halten. Im Kern geht es darum, wie, wer, woran und wieviel Geld mit den Nutzungs- und Nutzerdaten im Web verdient. Ich schlüssele den Umsatz der Online-Werbebranche von derzeit mehr als 6 Mrd. € auf und zeige, welche technischen Mittel die Branche verwendet, um die User über den tatsächlichen Datenfluss im Unklaren lässt.

[Update] Der Vortrag ist sehr gut gelaufen. Der Saal 3 war voll und das Publikum sehr interessiert und hat im Anschluss gute Fragen gestellt. Auch wenn ich nicht alle zu meiner eigenen Zufriedenheit beantworten konnte – trotz Überzug – war das Feedback nach dem Talk vor Ort und auf twitter sehr gut. Hat mich auf jeden Fall ermuntert, weiter aufklärend zu agieren.

Auf Youtube gibt es den Vortrag (noch als prerelease, Update kommt dann) hier.

Über twitter wurde ich noch auf diesen Artikel bei vdsetal zu Do-Not-Track aufmerksam gemacht.

Das Interview des Deutschlandfunk mit mir findet man in voller Länge hier (mp3) auf der 28c3-Seite.

Korrektur: Ich hatte in meinem Vortrag gesagt, dass Webtrekk eine Tochter von Axel Springer sei. Das ist nicht der Fall. (Danke für den Hinweis!)

[/Update]

Google Analytics ignoriert Do-Not-Track

[Update] 7.11.2012: Googles Browser Chrome unterstützt seit der Version 23 Do Not Track. Das bedeutet allerdings nicht, dass Google Analytics selbiges tut. Nach wie vor gibt es bei Google Analytics keine Möglichkeit für einen Site-Betreiber, die Wünsche der Nutzer nach Privatsphäre zu akzeptieren. [/Update]

Google Analytics zählt weiter fleissig Browser, die den Do-Not-Track-Header senden.

“‘Wissen Sie, ich hab’s Ihnen ja gesagt’ trifft es nicht so ganz.” ist eines meiner Lieblingsfilmzitate. Und so verwende ich es gerne und oft. Jetzt gibt’s wieder die Möglichkeit dazu:

Google Analytics ist das mit Abstand verbreitetste Tracking-Tool im Netz. Und obwohl Google der Do-Not-Track-Initiative eine eigene entgegengestellt hat, sollte man erwarten, dass Google den Wunsch der User respektiert. User, die in ihrem Browser die Option eingeschaltet haben (z.B. in Firefox oder in Safari mit Hilfe der Developer-Tools) wägen sich unbeobachtet, sind es aber nicht.

Bei eingeschalteter Option sendet der Browser bei jedem Request einen Header mit dem Namen ‘dnt’ und dem Wert ’1′. Eigentlich dürfte ein Tracking-Tool oder ein Ad-Server dann die Session-Daten nicht speichern. Damit dürften sie in den Statistiken von zum Beispiel Google Analytics nicht auftauchen. Allerdings erscheinen sie dennoch.

Besonders interessant dabei ist, dass in der Hilfe zu Google Analytics das Do-Not-Track-Verfahren als eine Möglichkeit für Site-Betreiber genannt wird, die eigenen Besuche auszusparen.

Google schweigt derzeit noch dazu, wann sie planen das Feature vernünftig zu unterstützen. Und es hilft sicher nicht, die Partner vorzuschicken und den Usern Sand in die Augen zu streuen in dem man behauptet, bei Do-Not-Track ginge es doch gar nicht um die Daten für Web-Analytics.

Neoliberale Post-Privacy-Argumentation

Ein Ruck geht durch Deutschland. Transparenz macht sich breit unter den Bloggern. Allerorten erscheinen Posts in denen eine Liste von externen Domains stehen. Diese sind durch Video, Werbung, Mashup oder Tracking in die Sites eingebunden und erhalten somit Kenntnis vom User und dessen Interaktion auf dem Blog. Nach wie vor für viele Nutzer eine wenig bis gar nicht bekannte Tatsache.

Insofern eine löbliche Offenbarung und gute Maßnahme zur Förderung des Medienverständnisses. Wenn es denn so gemeint wäre. Aber es geht den Autoren um etwas anderes:

Die Übermittlung der Daten an fremde Server ist kein Bug sondern ein Feature!

Die Argumentation läuft unisono folgendermaßen: Das Wesen des Webs ist die Verknüpfung von verschiedenen Services. Dazu werden in einer Seite die Angebote unterschiedlichster Anbieter eingebunden. Die dabei fließenden Informationen über die Interaktionen des Nutzers sind manchmal ein lässlicher Nebeneffekt und ansonsten ein wertschöffender Mechanismus.

Soweit kann ich der Argumentation ohne Einschränkungen folgen.

Der nächste Schritt jedoch führt im letzten Schritt zu einer neoliberalen Argumentation. Wirres.net schreibt:

die überschreitung der strengen deutschen datenschutzrichtlinien ist das wesensmerkmal des netzes

Oder deutlicher: Der Markt hat seine Regeln und ihr (Datenschützer) lasst bitte die Finger davon. (Die Frage, ob Amazon oder facebook, Google die größeren Datenkraken sind ist dabei übrigens vollkommen belanglos.)

Ich spare mir alle Vergleiche à la Dopingkontrollen, Verkehrsregeln oder Strafgesetz. Fakt ist, dass es momentan keinen funktionierenden Mechanismus für den User gibt, zu erfahren, welche Informationen über seine Interaktionen wohin fliessen und diesen Fluss zu kontrollieren.

Die Forderungen der Datenschützer aus Schleswig-Holstein mögen vielen als utopisch erscheinen und wirken auf viele, einem vollkommenen Unverständnis des Web entsprungen zu sein. Für mich sind sie aber der derzeit einzig wirksame Hebel, die Anbieter zu einem Umdenken zu bewegen. Diese werden in Zukunft ihre IT-Systeme so gestalten müssen, dass User einen echten Mehrwert dafür erhalten, dass sie ihre Interaktionsdaten freiwillig zur Verfügung stellen.

Derzeit sind die Nutzer Marktteilnehmer in einem Markt, den sie nicht kennen. Sie bezahlen mit einer Währung ohne die Ware zu kennen, die sie verkaufen und deren Wert sie sich nicht bewusst sind. (Näheres dazu in meinem Vortrag “Datenvieh oder Daten-Fee” auf dem 28C3 zwischen Weihnachten und Silvester in Berlin.)

Auch die Debatte um die aktuelle Gesetzeslage, die im Prinzip jeden Datenverkehr als per se verboten und nur im Ausnahmefall erlaubt betrachtet, bedient die gleiche Argumentation. Der Austausch von Daten sollte laut Prof. Jochen Schneider zuerst einmal immer erlaubt sein. Das bestehende Gesetz ist demgegenüber erstaunlicherweise nahezu deckungsgleich mit einem der wichtigsten Grundsätze des CCC: der Datenvermeidung. Da der vollkommene Verzicht jedoch tatsächlich unsinnig ist, da dann ein wesentlicher Teil der digitalen Wirtschaft eingestellt werden müsste, kommt nach meiner Meinung nur ein Copy-Bit in Frage.

Yet another broadcasting channel: Google Plus

Alle Charts über den guten Start von Google Plus sagen eigentlich nur, dass viele Leute wissen möchten, wie das soziale Netzwerk von Google aussieht. Die Frage, die die veröffentlichten Zahlen (zum Beispiel von Comscore: mehr als 20 Mio User) nicht beantworten können, lautet: funktioniert die Mechanik von Google Plus? Es spricht nach meiner Meinung einiges dafür, dass sich Google verrechnet hat.

Die Spannweite der Meinungen zu Google Plus zeigen zwei Posts von zwei Heavy-Usern. +Kristian Köhntopp schreibt:

@isotopp(stillgelegt) auf Twitter hatte 2264 Follower. Das hat recht lange gedauert.

Die Plusteria gibt es erst ein paar Wochen, und da sind nun schon 3100 Follower hinter mir her.

Ich glaube wirklich, daß Twitter bald einpacken kann.

+Nicole Simon geht jedoch wieder zurück zu facebook und twitter:

The reason I am going back to Facebook and Twitter to ‘read’ updates?

Because they don’t scroll down the moment somebody new posts something. This instant update might work if you have like 5 friends in your circles.

Warum funktioniert die Mechanik nicht?

Kern der Mechanik ist die Circle-Lehre also der Mix aus twitter-Follower-Logik und facebook-Gruppen. Nicht mehr Teil der Mechanik, aber natürlich wesentlich für den Erfolg, sind die Funktionen des Interfaces. (Damit und mit der Klarnamenfrage hatte ich mich aber schon beschäftigt.)

Grundsätzlich wird die Circle-Lehre als zu kompliziert für die DAUs bezeichnet. Mails mit Betreffzeilen wie “Kannst Du meine Nachricht sehen?” gab’s von vielen meiner Eingeladenen. Vor dem Hintergrund der Datenlecks in den letzten Monaten und der Diskussionen über Personaler, die sich gerne Partyfotos ansehen ist verständlich, dass die Nutzer anfangs eher vorsichtig posten und den Kreis der Leser eher zu klein halten.

So ist es kein Wunder, dass sich +mspr0 – seines Zeichens Speerspitze der Postprivacy-Bewegung – als digitaler Robin Hood betätigt und Posts aus den Circeln befreit. Dass dies prinzipiell geht (obwohl man eine Warnung bekommt, man möge vorsichtig sein) stellt nach meiner Meinung einen Designfehler dar. Ganz abgesehen von dem absolut nervenden Umstand, der sich dadurch ewig wiederholenden animierten Gifs.

Im Prinzip handelt es sich bei Google Plus um eine dissipative Struktur. Ein Element einer Struktur wird angeregt/informiert, reagiert daraufhin und regt an/informiert andere Elemente. Das ursprüngliche Element erhält ein Feedback und konstruiert danach ein Abbild seiner Umgebung. Der beste Einstieg in das Thema dissipativer Systeme ist nach wie vor von Erich Jantsch mit dem recht bombastischen Titel “Die Selbstorganisation des Universums. Vom Urknall zum menschlichen Geist“.

Bei Google Plus funktioniert dieser “Mechanismus” nur sehr bedingt. Postet ein Nutzer eine Nachricht an einen bestimmten Kreis von Leuten, denen er folgt erhält er in den meisten Fällen kein Feedback darüber, wer von diesen Usern die Nachricht sehen kann (Kontrollverlust …). Selbst bei Nutzern, die ihm auch folgen, ist nicht gewährleistet, dass diese auch den kompletten Stream lesen oder den jeweiligen Circle-Stream. (Daran ändert auch das heutige Update nichts.)

Ein weiterer Effekt der inneren Mechanik ist für den notwendigen Schneeballeffekt wahrscheinlich noch katastrophaler. Da viele User nur in ihren Kreisen posten, erscheint auf ihrer Profilseite keine einzige Nachricht, wenn ich nicht in einem ihrer Circle bin. Warum aber sollte ich jemandem folgen, der nichts veröffentlicht. Besonders in der Anfangsphase stellt sich dies als echter Showstopper dar.

Geht man von einer 90/10-artigen Regel für die Verteilung von Voyeuren und Exhibitionisten auch bei Google Plus aus, führt dieser Mechanismus jedoch zu einem unidirektionalen Sender-Empfänger-Verhalten. Wenige Nutzer betätigen sich als Broadcaster und teilen permanent die Inhalte, die andere Broadcaster eingestellt haben. Die Eigenschaft des Webinterfaces, alte Nachrichten immer wieder hervorzukramen nur weil noch jemand seinen Senf dazu gegeben hat, verstärkt den Effekt noch. Und so überrascht es nicht, wenn meine Timeline mit 100+ Posts im Schnitt von maximal 10 Leuten gefüllt wird. Und ausnahmslos alle aus den G+-Charts in meinem Stream posten public. Demgegenüber sind die Nachrichten aus meinem weiteren sozialen Umfeld (welches man nicht als analog bezeichnen könnte) nur eingeschränkt zu lesen.

That sounds exactly like the thinking of a machine to me.

Von einem sozialen Netzwerk ist Google Plus damit weiter entfernt als fb und twitter. Besonders vor dem Hintergrund des momentanen Gamification-Hypes frage ich mich, warum dieser Effekt in den internen Tests nicht aufgefallen ist. Vermutlich erhofften sich die Mitarbeiter Vorteile in ihrem Arbeitskontext und waren daher fleissigere Nutzer als sie es ansonsten gewesen wären. In der aktuellen Form bietet Google Plus nur Belohnungen für die Exhibitionisten. Und wenn die Voyeure wegbleiben, dann gibt es auch keine Belohnung mehr für die Exhibitionisten.

Webdesign ohne Rücksicht auf die Nutzer

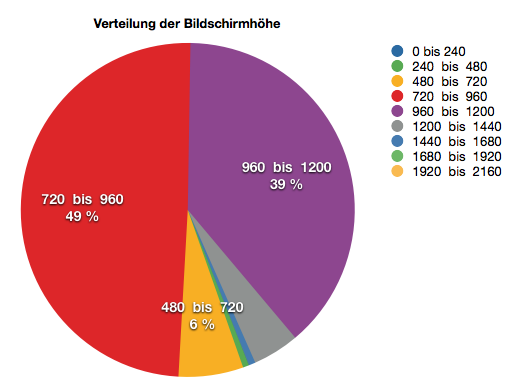

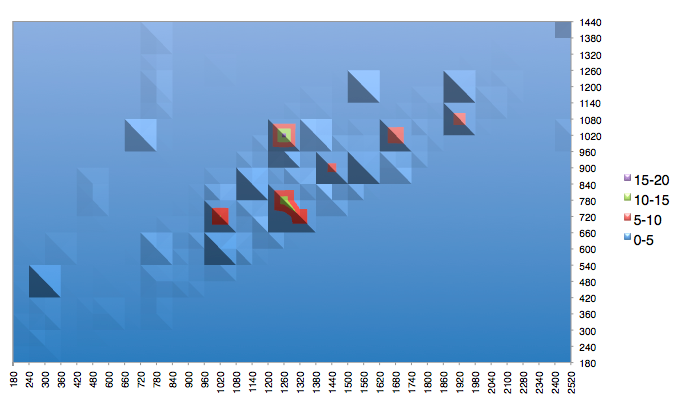

Eine immer wiederkehrende Frage in Relaunchprojekten lautet: Gibt es denn Zahlen über die Verbreitung der Bildschirmauflösungen? Einfache Geister fragen auch gerne: Sind 21-Zoll-Monitore heute Standard? Im Kern geht es darum, festzulegen, für welche Auflösung die Site in Zukunft optimiert werden soll.

Besonders der Relaunch von golem.de durch die information architects hat mich veranlasst, die Frage mal an Hand einer großen General-News-Site mit mehreren Millionen Visits pro Monat zu beantworten. Die Zahlen bei golem könnten davon abweichen, da es sich um ein technophiles Publikum handelt. (Allerdings wage ich die Aussage, dass diese noch eher zu mobilen Geräten greifen, als die Nutzer bei der News-Site) Denn tatsächlich fällt mir bei golem auf, dass ich als Leser beim Aufruf der Startseite nur noch sehr, sehr wenig Inhalt sehe.

Bildschirmauflösungen mit einer Höhe größer als 1200 Pixel sind mit 5% als Exoten zu bezeichen.

Und tatsächlich spiegelt sich in der Auswertung der Trend zu Notebooks, Netbooks und mobilen Geräten wieder. Fast 95% aller User hat einen Bildschirm mit einer Auflösungshöhe von 1200 oder weniger Pixeln. Knapp die Hälfte aller Rechner kommt mit einer Höhe von unter 960 Pixeln auf die Site. Darunter fallen zum Beispiel die neuen MacBook Air mit 1366 x 768 Pixeln.

Auf meinem Rechner sieht golem bei Standardeinstellungen zum Beispiel so aus: die aktuellen Inhalte muss man sich erst erscrollen.

Sehr interessant ist auch die Tatsache, dass sich Rechner mit einem Verhältnis von 16:9 deutlich durchsetzen: ein Viertel der User mit einer Höhe zwischen 720 und 960 Pixeln hat eine Bildschirmbreite von 1440 bis 1680 Pixeln. Der Vollständigkeit halber hier noch die Breite in Bezug zur Höhe:

Die prozentuale Verteilung der gerundeten Breite (X-Achse) zur Höhe (Y-Achse) der Bildschirmauflösung.

Obwohl mir das aufgeräumte Layout der Arbeiten von information architects normalerweise gefällt halte ich den Trend zu “aufgeräumtem” Layout für eine Entwicklung, die an den technischen Gegebenheiten der meisten User vorbeigeht.