Archive for the ‘netzpolitik’ Category

Warum eigentlich IPv6?

tl;dr: IPv6 ist gut für Leute, die sich auskennen. Für den DAU ist es ein Albtraum. Und eigentlich kann man mit bestehender Technik beliebig viele Geräte ans Netz bekommen.

IPv4 ist dem Untergang geweiht und IPv6 steht vor der Tür, ach gewissermaßen schon im Flur. Denn die Adressen gehen zu Ende. Mit 4 Milliarden IP-Nummern ist bald das Ende der Fahnenstange erreicht. Wirklich?

Meine Versuche – Airport Express über FritzBox an Alice – IPv6 einzurichten waren bisher erfolglos und auch meine Server bei Strato zickten so rum, dass ich ihnen IPv6 wieder wegnehmen musste.

Aber die Probleme bei der Migration sind sicher nicht nur in der nichttrivialen Einrichtung zu suchen. Tatsächlich gibt es beispielsweise erhebliche Irritationen in Bezug auf den Datenschutz. Anfangs haben unter anderem Apple-Geräte ihre eindeutigen MAC-Adresse in die IP-Adresse eingebaut und waren damit immer wiedererkennbar. Aber selbst nach der Aktivierung der “Privacy Extensions” sind Rechner für eine bestimmte Zeit identifizierbar und ein Dritter mit Zugang auf Logfiles verschiedener Services (z.B. ein Targeter) kann Beziehungen zwischen der Nutzung mehrerer Dienste herstellen.

Auf der operativen Ebene gibt es momentan Bestrebungen, die Adressvergabe bei IPv6 grundlegend zu ändern. Statt, wie bisher, die Adressen frei (also ohne Ansehen der Person) zu vergeben sollen sie zukünftig zu einer Handelsware werden. Der Markt soll die Verteilung regeln. Es ist absehbar, dass Adresshändler große Blöcke horten und wie bei jedem limitierten Gut werden die Preise langsam aber sicher steigen.

Eine Frage stellt sich jedoch unabhängig von der offensichtlich problematischen Migration: Warum eigentlich IPv6?

Aus Sicht eines technophilen Menschen bietet v6 den tollen Vorteil der statischen IP-Adresse. Jedes Gerät zu Hause ist zukünftig erreichbar. Bisher machte einem die tägliche Neuvergabe der Adresse durch den Provider einen Strich durch die Rechnung. Man brauchte einen Service wie dyndns der einen Hostnamen auf die aktuelle IP-Adresse im DNS einträgt. Und dieses Setup hat noch den Nachteil, dass man hinter einem NAT-Router ist. Dieser erlaubt nur ein Gerät in der DMZ. Hat man mehrere Geräte, die über den gleichen Service laufen sollen wird die Konfiguration schon extrem aufwendig. Für viele anderen Dienste als httpd (Webserver) ist eine Konfiguration auf Basis von Hostnamen nicht möglich.

Mit der Aktivierung der Privacy Extensions für IPv6 entfällt jedoch der Vorteil der eindeutigen Adresse. Man benötigt wieder einen dynamischen DNS. Auf dem Gerät muss also ein Dienst laufen, der dem DNS-Server Bescheid sagt, dass sich seine Adresse geändert hat. Der einzige Vorteil, der dann noch bleibt ist die Tatsache, dass im heimischen Netzwerk alle Geräte auch alle Protokolle parallel anbieten können und von aussen erreichbar sind.

Mit der bestehenden Technik können im Prinzip 4 Milliarden Server und Heim-/Office-Netze bedient werden. Effektiv sind es vielleicht nur 1 Milliarde weil große Firmen große Blöcke haben, die sie nicht nutzen. Viele Server bieten mehrere Web-Seiten unter der gleichen IP-Adresse an und lösen nach Namen auf. Und viele Telcos betreiben Handys ebenfalls hinter NATs. Warum auch nicht? Fast alles läuft über http und selbst Skype bohrt sich durch Port 80 nach aussen.

Wer ausser technophilen Leuten möchte also alle Geräte zu Hause oder im Büro nach aussen sichtbar haben? Ist nicht NAT tatsächlich eine der besten Schutzeinrichtungen vor klassischen Viren und Trojanern, die sich über Lücken in Betriebssystemen verbreiten und nicht auf die Mithilfe der Nutzer angewiesen sind. Wollen die Nerds allen Ernstes wieder regelmäßig bei Freunden und Familie schlechte Router und OS konfigurieren und updaten?

[Update] Tim Pritlove hat in seinem aktuellen CRE-Podcast #197 das Thema IPv6 aufgegriffen und dort gibt es etliche Informationen insbesondere zu den technischen Grundlagen. [Update]

Sind wir nicht alle ein bisschen Blogger?

Was für eine tolle Podacst-Folge von Alternativlos! Fefe und Frank Rieger bei Herrn Döpfner. Wahrscheinlich mit Blick über Berlin in den höchsten Etagen des Springerhochhauses in der Rudi-Dutschke Strasse Ecke Axel-Springer-Strasse. Und: Herr Dr. Döpfner ist ein Verleger oder vielleicht ein Super-Blogger oder doch eigentlich auch nur ein Blogger.

Und Herr Döpfner ist ganz offen. So offen, dass sehr deutlich wird, dass das Leistungsschutzrecht eine deutliche Warnung an Google ist. Alle Blogger können sich entspannt zurücklehnen und müssen nichts befürchten. Springer liebt alle Blogger. Sicher würde kein Blogger fürchten, von Springer belangt zu werden. Wahrscheinlich auch von keinem anderen Verlag.

Leistungsschutzrecht ist also doch nur ein Papiertiger

Als Leuchtturmbeispiel wird Flipboard genannt, das sich als Aggregatoren mit den Verwertern über eine Abgeltung geeinigt hat. Und nachdem Döpfner lange Zeit in dem spannenden Gespräch den Namen Googles zu nennen vermied wird dann doch deutlich, was Springer antreibt und welchen Zweck der Gesetzentwurf zum Leistungsschutzrecht hat. Es soll Google an den Verhandlungstisch bringen. Denn ansonsten würde ja früher oder später der große Regulator kommen. Und das könne niemand wollen. Selbst Springer nicht.

Das Leistungsschutzrecht als Gestzesentwurf in seiner jetzigen Form ist ein schlecht formuliertes Gesetz, dessen einziger Zweck gar nicht die Verabschiedung ist, sondern eine Drohkulisse aufbauen soll. Unter dem Motto:

Hallo Herr Google, wenn Du nicht mit uns verhandelst, werden wir dieses Gesetz durchdrücken. Und dann verlierst Du einen deiner wichtigsten Märkte.

(Leider finde ich den Link zum Etherpad mit dem Transskript nicht mehr. Da es unter https (mit einem abgelaufenen Zertifikat) lief, gibts das nicht in meinem Browsercache und offensichtlich wurde wieder vandaliert und Rieger hat den Link wieder weggenommen. Mehh …)

Leistungsschutzrecht: eine Branche schafft sich ab

tl;dr Die Verlage – allen voran die axel springer ag – möchte das Web wieder zu einem Sender-Empfänger-Modell zurückführen. Mit Leistungsschutzrecht und Paywalls sollen ihre Inhalte vor dem unbezahlten diffundieren geschützt werden. Letztlich bauen sie damit nur das Fundament für eine Transformation der Medienbranche. Weg vom Verlag, hin zu EΠC 20151.

Das Thema Leistungsschutzrecht wurde grade in dem immer wieder hörenswerten Podcast aus der metaebene Logbuch: Netzpolitik von Philipp Otto (von iRights.info) dargestellt. Der Entwurf wirft derzeit mehr Fragen auf als einem einfallen können:

- Welchen Umfang dürfen Zitate in Zukunft haben? 10 Worte? 3 Worte?

- Fallen Links darunter?

- Fallen Link-Texte darunter? (sog. sprechende URLs)

- Was ist mit URL-Shortenern?

- Fällt eine Beschreibung der notwendigen Suchbegriffe darunter?

- Wie verträgt sich dieses Gesetz mit dem Zitatrecht?

- Was ist mit Übersetzungen?

- Was ist mit wissenschaftlichen Arbeiten?

- Aber vor allem: Was meint ‘gewerblich’?

Nimmt man beispielsweise qrios.de, dann ist die Frage sehr schwer zu beantworten. Die Autoren arbeiten in exakt dem Themenbereich, um den sich alle Artikel drehen. Die Artikel sind schon deswegen als gewerblich zu bezeichnen weil sie der Sammlung dienen. Jeder Artikel dient der eigenen Meinungsbildung, der Archivierung und sogar dem öffentlichen Diskurs.

Ginge man mit dieser Begründung zum Finanzamt und würde z.B. die Serverkosten, die Schreibgeräte, die Mobilfunkverträge und den heimischen Küchentisch als relevant für diese Tätigkeit abschreiben wollen müsste man mit höhnischem Gelächter rechnen. Selbst, wenn man einen flattr-Button auf der Seite hätte und dort monatlich 50€ einnehmen (und damit die Serverkosten begleichen können), stieße man auf Unverständnis.

Man kann sicher auf den ersten Fall gespannt sein in dem das Hamburger Landgericht einem Geflügelfürsten bestätigt, dass der Koch-Blog ichrühreeier.de einen Erwerbszweck verfolgt, da der Blogger einen Mehrwert aus zugesannten Rezeptbüchern hat, die er üblicherweise rezensiert. Was macht das Finanzamt dann?

Soll das Web wieder ein Walled Garden werden?

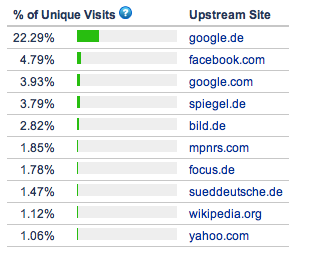

Vor allen praktischen Aspekten eines schlecht ausgearbeiteten Entwurfs muss man sich jedoch fragen, wie die Verlage auf diese bekloppte Idee kommen? Selbst wenn es nur auf Google abzielt (und nicht auch noch auf facebook und twitter) und Google sich breitschlagen lassen sollte, für die News-Schnipsel zu zahlen dürften die Einnahmen der Publisher erheblich sinken. Google dürfte zukünftig dafür sorgen, dass weniger Nutzer zu Axel Springer gehen.

Und nicht nur Google selbst dürfte durch Änderung seines Ranking-Mechanismus aktiv dafür sorgen. Die Nutzer selbst werden dafür sorgen, dass der Pagerank von zum Beispiel welt.de (PR: 8 ) oder bild.de (PR: 7) sinkt. Wer sollte dann noch auf Artikel dort verlinken, wenn er dafür abgemahnt werden kann?

Laut Alexa sind mehr als 30% der Welt.de-Nutzer zuvor auf einer Suchmaschine oder facebook. Selbst bei vorsichtiger Schätzung dürften von den 42.198.106 Besuchern im Mai 2012 mindestens 8 Mio über Suchanfragen oder soziale Links auf die Seite kommen. Die würden schon mittelfristig wegfallen. Der langfristige Effekt dürfte sich noch viel stärker auswirken.

Vor dem Hintergrund der aktuellen Meldungen, dass mehr und mehr Verlagshäuser eine Paywall einrichten wollen (Madsack, FAZ, NZZ) könnte man meinen, dass das Web auf den Stand von BTX und Compuserve zurück gebracht werden soll. Inhalte sollen nur von einem begrenzten Kreis kommen und die Nutzer sollen Konsumenten bleiben.

Konsequenterweise wird der sehr schöne Artikel von Constanze Kurz in der FAZ über eine Zukunftsversion mit Leistungsschutzrecht nicht verlinkt. Man möge einfach bei Google nach “constanze kurz faz” googeln.

1) Der Film EPIC 2015 ist eine Zukunftsversion aus dem letzten Jahrhundert. Unter anderem darin Verleger, die gegen Google wg. der Verwendung von Snippets klagen. Am Ende liefern die Nutzer selbst die Inhalte und werden direkt vergütet.

Do-Not-Track-Hick-Hack um IE10

Nach der Ankündigung von Microsoft seinen Internet Explorer 10 mit gesetztem Do-Not-Track-Schalter auszuliefern hatte Firefox ja schon erhebliche Erklärungsprobleme. Für die meisten Nutzer ist nicht einsehbar, warum der einzige freie Browser sich dem Diktat von Werbefirmen beugt. Bei den Summen, die von Google an die Mozilla-Foundation fliessen ist das allerdings nicht verwunderlich.

Inzwischen wird von den interessierten Kreisen massiver Druck auf Microsoft ausgeübt. Die zuletzt geladene und scharf gemachte Waffe sieht so aus:

Niemand muss sich an die DNT-Information eines IE10 halten, da sich dieser Browser nicht standardkonform verhält.

Derzeit gibt es zwar noch keinen verabschiedeten Standard sondern nur einen gemeinsam verabschiedeten Vorschlag. Dieser sieht jedoch vor, dass der Nutzer seinem expliziten Willen Ausdruck verliehen haben muss, wenn der Browser DNT=1 sendet also jedem Server mitteilt, dass er nicht getrackt werden will.

Es wird also implizit davon ausgegangen, dass User prinzipiell getrackt werden möchten und nur wenige (weniger als die Hälfte) sich dagegen entscheiden. Es handelt sich also um ein OptOut.

Dieses Vorgehen wurde gestern bei einer Telefonkonferenz nochmal abgestimmt. Das Ergebnis kann man sich hier ansehen. Offensichtlich wurde Browserherstellern, die von der Linie abweichen während des Termins sogar mit einer Untersuchung durch die FTC gedroht.

Nach meiner Meinung haben sich die an dem Gremium beteiligten Datenschutzorganisationen (darunter der eff) über den Tisch ziehen lassen (“extraordinarily painful cuts for privacy-leaning stakeholders”). Ich bin gespannt, wie sich z.B. die Electronic Frontier Foundation zu dem aktuellen Stand äussern (noch ist dazu nichts auf dem Blog). Denn es dürfte doch jedem klar sein, dass die Werbebranche von dem maximal dummen Nutzer ausgeht der zu blöd ist, die Einstellungen zu öffnen und das Häkchen zu setzen.

Firefox, der Mielke unter den Browsern: Ich liebe Euch doch alle!

Man kann von Do-Not-Track halten was man mag. Aber das vorläufig letzte Argument von Mozilla dagegen, erinnert sehr stark an Erich Mielkes

Ich liebe Euch doch alle

Denn das Argument lautet: der User darf nicht mit Fragen belastet werden, die ihn überfordern und da es gängige Praxis ist, den Nutzer zu tracken ist die Default-Einstellung für Do-Not-Track=off.

Man kann nur hoffen, dass sich die entscheidenden Leute bei der Mozilla-Foundation damit endgültig disqualifiziert haben. Denn sie sagen nicht mehr und nicht weniger als dass ihre Nutzer dumm sind und lieber ungestört surfen möchten als von nervigen Abfragen gestört zu werden.

Dabei ist Firefox erstens genau der Browser, der permanent durch störende, vollkommen belanglose Dialoge auffällt, die man eben nicht verhindern kann und zweitens ist es genau der Browser, der dafür bekannt ist, dass er wichtige Einstellungen an vollkommen abstrusen Orten versteckt.

Welche Probleme die Mozilla Foundation mit dem Thema Privacy hat wird schnell deutlich, wenn man sich den Mozilla Privacy Blog ansieht. Von den letzten zehn Artikeln seit Ende letzten Jahres handeln acht direkt von DNT. Viele sogar davon, dass die ursprünglich von Mozilla selbst kommende Idee eine immer breitere Anhängerschaft finden. Und trotz unauffindlicher Einstellung haben 7% der Nutzer die Option eingeschaltet. Tatsächlich dürften ja gerade die verfügbaren Privacy-Erweiterungen für den Browser ein wesentliches Argument für dessen Beliebtheit sein.

Um so mehr verwundert es, dass der IE 10 den Firefox jetzt rechts überholen kann. Denn Microsoft hat heute bekannt gegeben, dass der Browser zukünftig die Option per default gesetzt hat.

Und Mozilla? Der Vorreiter für Privatsphäre redet sich mit Usability raus. Denn – man halte sich fest:

ultimately it’s not the browser being tracked, it’s the user

Dem hätte doch immerhin selbst Microsoft in der W3C Tracking Protection Group zugestimmt. Eine Vorwegnahme der Wünsche durch eine Default-Einstellung würde der Idee widersprechen, dass nicht dem “not the preference of some institutional or network-imposed mechanism” Ausdruck verliehen würde. Man müsste quasi von einem Eingriff in die Netzneutralität sprechen.

Damit wären wir genau wieder bei dem mutmaßlichen Interesse eines durchschnittlich informierten Nutzers, den der D64 in seiner Charta aus dem Hut zaubert. Was meinen die alle? Den DAU?

Ein für alle Mal:

DER DURCHSCHNITTLICH INFORMIERTE BENUTZER HAT KEINEN BLASSEN SCHIMMER, WELCHE DATEN ÜBER SEIN VERHALTEN VON WEM GESAMMELT WERDEN. UND WENN MAN ES IHM SAGT, FRAGT ER SOFORT, WO DER BUTTON IST, DAS ZU VERHINDERN!!11EINSELF

ps: Google (die Firma mit dem einzigen verbreiteten Browser gänzlich ohne Do-Not-Track-Option) steuert übrigens 85% der Einnahmen der Mozilla-Foundation bei.

20 Euro für die #klehranlage

Das als Pressekammer bezeichnete Landgericht 24 in Hamburg fungiert inzwischen als das genaue Gegenteil. Sie legt an Aussagen von Zeitungen, Journalisten und Bloggern teils höhere Ansprüche als ein Richter in Bezug auf prozessrelevante Materialien. Man könnte in einem Prozess andernorts durchaus einen Beitrag aus der ARD abspielen, um eine Masche eines Betrügers zu belegen (und würde damit Erfolg haben). Und zur gleichen Zeit, würde der ARD in Hamburg der Beitrag unter dem Hintern weggeklagt werden.

Viele Entscheidungen dieses Gerichtes wurden inzwischen von höheren Instanzen kassiert. Jetzt geht es um einen weiteren Fall und 20,00 € werden sofort von mir überwiesen.

Datenschutzregelungen sind zu kompliziert – selbst für den Innenminister

Nachdem ich ja neulich schon festgestellt hatte, dass die geltenden Datenschutzbestimmungen für die engagierte Netzgemeinde zu kompliziert sind zeigt sich grade, dass auch der Innenminister die einfachsten Regeln nicht versteht. Das Innenministerium hat heute den Preis im Ideenwettbewerb “Vergessen im Internet” verliehen. Auf der Seite wird lobenswerterweise Piwik verwendet. Entgegen den deutschen Datenschutzbestimmungen wird jedoch ein Cookie mit einer Gütigkeitsdauer von 2 Jahren gesetzt. Und dies entgegen den Ausführungen in der Datenschutzerklärung. Denn eine Personalisierung ohne Registrierung findet nicht statt und bräuchte daher keine Cookies. Wie eine korrekte Datenschutzerklärung bei der Verwendung von Piwik aussieht? Hier.

Gänzlich verwirrend wird es, wenn davon die Rede ist, dass

die gespeicherten IP-Adressen nicht weitergegeben (auch nicht an den Auftraggeber)

werden. Wer ist hier der Auftraggeber. Laut Impressum wird das “Internetangebot […] herausgegeben vom: Bundesministerium des Innern – Projektgruppe Netzpolitik”. Was hat der Nutzer unter Auftraggeber zu verstehen? Eine Anonymisierung der IP-Adressen findet offensichtlich nicht statt. Vielleicht sollte sich Herr Friedrich mal mit einer ehemaligen Justizministerin unterhalten.

Datenschutzregelungen sind zu kompliziert – selbst für die Netzgemeinde

Auf der Suche nach beispielhaften Datenschutzerklärungen könnte man auf die Idee kommen, bei Leuten nachzuschauen, die sich damit auskennen. Man schaut ja auch in den HTML-Code einer Seite, die einem gefällt (ich mache das zumindest so). Was liegt also näher, bei der digitalen gesellschaft, beim D64 oder der re:publica nach einer gesetzeskonformen Datenschutzerklärung zu suchen?

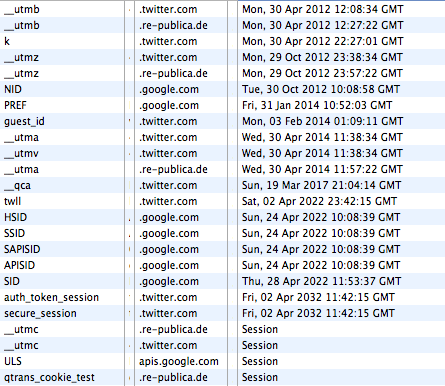

Die Site der re:publica geht recht freigiebig mit den Daten der Nutzer um. Twitter und Google setzen gleich mal 10-Jahres-Cookies. (Quelle: http://re-publica.de/12/impressum/)

Was eine “gesetzeskonforme Datenschutzerklärung” grundsätzlich bieten müsste, erklärt zum Beispiel e-recht24.de. Und tatsächlich scheint die Datenschutzerklärung von D64 eine sehr gute Einsicht zu geben, welche Daten, von welchem Anbieter zu welchem Zweck erhoben werden. Die PlugIns von twitter und facebook werden aufgezählt und selbst Askimet (eine WordPress-Plugin zur Spam-Erkennung) wird erwähnt. Vorbildlich. Wäre da nicht auf der Homepage ein Video von vimeo eingebunden. Dieses PlugIn wiederum verwendet offensichtlich Google Analytics wodurch interessanterweise die letzte Video-Suche auf Google via D64 zu vimeo gelangt und dort wieder mit Google verknüpft wird. Von solchen Datenflüssen und dem Zweck der Speicherung erfahre ich als User nicht und kann also weder still zustimmen noch Einspruch erheben.

Bei der Digitalen Gesellschaft gibt es zwar ein reisserisches Statement über das Engagement des Vereins für den Schutz der privaten Daten, selbst äussert man sich aber eher zurückhaltend. Oder anders: es gibt keine explizite Datenschutzerklärung. Selbst im Impressum findet sich eine solche nicht. Als Tracker kommt Piwik zum Einsatz. Von aussen ist nicht einsehbar, ob das System so konfiguriert ist, dass die IP-Nummern anonymisiert werden. Zusätzlich setzt der Server noch eine PHP-Session-ID und diverse Google-Analytics-Cookies über das twitter-PlugIn. Darunter auch die Information, dass dieser Browser irgendwann mal auf favstar.fm war. Ein Cookie nennt sich “__qca” und kommt von einer Firma namens Quantcast, eindeutig von der dunklen Seite der Macht. Volle fünf Jahre soll dieser Cookie Bestand haben.

Auch die Netzpolitiker der CDU hinken jedem popeligen Netzshop in Sachen Datenschutzerklärung hinterher. Sie haben einfach keine. Allerdings sind sie in Bezug auf Social-PlugIns wenigstens weiter als die Digitale Gesellschaft. Denn sie verwenden wenigstens die Opt-[Korrektur]In[/Korrektur]-Version. Allerdings ist bei einer oberflächlichen Recherche nicht zu ermitteln, warum ein Cookie gesetzt wird, dass zum Beispiel den ursprünglichen Referrer für mindestens ein halbes Jahr an den Server schickt.

Vielleicht hat ja die re:publica eine vernünftige Datenschutzerklärung? Immerhin steht sie dieses Jahr unter dem Motto ACT!ON und es geht unter anderem um die Gefahren für Aktivisten durch Überwachungssoftware. Im Impressum findet sich nichts und eine explizite Datenschutzerklärung findet sich gar nicht. Aber warum auch, immerhin setzen die Veranstalter auf “den gesunden Menschenverstand”. Meint bestimmt, dass man vor dem Aufruf der Seite erstmal nachschaut, welche Daten erhoben und wie diese verwendet werden. Man könnte sich ja vielleicht den Vortrag “Die Gesetze der Daten” anhören. Denn “Der Datenschutz wird uns nicht helfen können” ist doch eine einleuchtende Legitimation für die fehlende Sensibilität der Speerspitze der Netzgemeinde in Sachen Datenschutz für ihre eigenen User.

Alpha Beta #Charta – Großes Theater vom #D64

Fast wäre die Charta vom D64 an mir unbesehen vorbeimäandert. Doch ein tweet von @in_aha schützte das Dokument vor meinem ewigen Übersehen.

Bei soviel digitalen Lobby-Organisationen (A-, B-, CNetz) kann man schon mal den Überblick verlieren. Da ist es gut, wenn einer davon mehr von Kommunikation versteht als die anderen. Und tatsächlich sitzen beim D64 Leute, die sich mit Kommunikation auskennen. Die erste Regel lautet: GROß DENKEN! Das tun sie. Zum Beispiel dadurch, dass sie gleich mal eine Charta veröffentlichen. Man erinnere sich, dass Chartas formuliert wurden, um die Vereinten Nationen zu begründen (1945) und 1977 um den Ostblock in die Knie zu zwingen. Chartas sind “die für das Staats- und Völkerrecht grundlegenden Urkunden“.

Der jetzt veröffentlichte Entwurf, soll nun von den D64-Vereinsmitgliedern diskutiert werden. Die Plattform dafür nennt sich Zentrum. Auch hier zeigen sich wieder die Kommunikationsprofis. Wer sich selbst in die Mitte stellt kann nicht ausgegrenzt oder marginalisiert werden. Von ihm geht alle Bewegung aus. Andere können sich zwar andocken aber D64 ist das Zentralgestirn.

Im ersten Punkt wird dieses Vorgehen noch mal deutlich: “Als D64 fordern wir, das gesamte Spektrum der politischen, technologischen und gesellschaftlichen Veränderung in den Blick zu nehmen.” Dadurch dass der D64 im Zentrum steht hat er den vollkommenen Überblick. Andere stehen am Rand und werden dadurch immer nur Einzelaspekte des digitalen Lebens betrachten. Egal ob sie sich selbst digitale gesellschaft oder Piraten nennen.

Die weiteren Punkte sind gegliedert in 2. Teilhabe, 3. Datenschutz, 4. Netzpolitik, 5. Öffentlichkeit, 6. Gesetzeslage, 7. Primat der Bürgerinnen und Bürger, 8. Arbeit, 9. Wissenschaft und 10. Transnational. Da sich viele aktuellen Themen dieser Strukturierung entziehen, sollen hier die Antworten auf die wichtigsten Fragestellungen untersucht werden

Netzneutralität und Netzzugang

Basis für eine Gesellschaft in Zeiten des Internet ist auch für den D64 ein freier und überall verfügbarer Zugang zum Netz. Der Verein fordert daher auch den flächendeckenden Ausbau und den kostenlosen Netzzugang. Notfalls soll der Staat selbst investieren. Das Internet wird als ein Grundrecht postuliert.

Um welche Art Internet es sich handelt wird an dieser Stelle noch nicht dargelegt. Aber auch später taucht eine Forderung nach Netzneutralität nicht auf. Lediglich im Kontext des Urheberrechtschutzes wird vor unangemessenen Eingriffen gewarnt. Dabei bleibt unklar was angemessene Eingriffe wären. Sind Stoppschilder oder Domainsperren angemessen? Wer misst und was ist Maßstab?

Vorratsdatenspeicherung, Fluggastdaten

Interessanterweise behandelt der Verein die Vorratsdatenspeicherung unter dem Thema Datenschutz und nicht unter Netzpolitik oder Gesetzeslage. Die anlasslose Speicherung wird umfänglich abgelehnt. Man spricht sich für Quickfreeze mit Richtervorbehalt und Informationspflicht und -löschen aus.

Über die Weitergabe von Daten zum Beispiel im Rahmen eines Fluggastdatenabkommens der EU und den USA sagt der D64 nichts.

Privatsphäre, Datenschutz

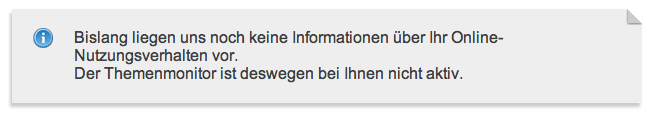

“Wir glauben nicht an das Ende der Privatsphäre als Wert.” Der D64 ist also kein Anhänger der Postprivatiers oder Spackeria. Das wäre allerdings auch seltsam. Denn der Verein wird inhaltlich stark von der Post-Tochter nugg.ad bestimmt. Diese Firma betreibt Targeting und Retargeting und lebt damit wesentlich vom Wert der privaten Daten der Nutzer. Ein Ende der Privatsphäre würde ihr Herrschaftswissen egalitären.

Datenschutzmaßnahmen hätten die Aufgabe “vor intransparenten, unkontrollierten und überzogenen Datensammlungen […] zu schützen”. Sie hätten aber “auch das Interesse der Nutzer und der Verkäufer im Netz im Blick behalten …”. “Maßstab muss das mutmaßliche Interesse eines durchschnittlichen informierten Nutzers sein.” Wichtig hierbei ist insbesondere die Mutmaßung. Denn nur sie ermöglicht eine Cookie-Richtlinie auf der Basis von Opt-Out-Verfahren. Ein Betreiber kann damit jederzeit glaubhaft mutmaßen, dass insbesondere ‘seine’ durchschnittlich informierten Nutzer ein Interesse an seiner Datensammelwut hätten.

Anonymität im Netz

Zu einer immer wieder geforderten Pflicht, sich als Nutzer im Netz zu identifizieren nimmt die Charta keine Stellung. Das ist insofern erstaunlich als dass diese Forderung die zentrale Schnittstelle aller Ideen zur Einschränkung der Rechte im Netz ist und mitschwingt, wenn vom rechtsfreien Raum gesprochen wird. Hier hätte sich der Verein wegweisend mit seiner “Charta” zeigen können.

[Korrektur] Hier bin ich Opfer der sehr eigenen Struktur des Dokumentes geworden. Stephan Noller (D64-Gründungsmitglied und nugg.ad-Gründer) wies mich im Kommentar darauf hin, dass unter Datenschutz Absatz H deutlich steht, dass “Die Möglichkeit, das Netz unter Pseudonym zu nutzen” erhalten bleiben muss. Aus meiner Sicht ist dies jedoch kein natives Datenschutz- sondern ein übergeordnetes Thema. Vor allem die Bindung an die BILD-Aufreger Verunglimpfung und Beleidigung spiegeln die Relevanz nicht. Letztlich ist in einer Demokratie die Anonymität der Meinungsäusserung ein Grundrecht. [/Korrektur]

Leistungsschutzrecht, ACTA

In der Charta spricht sich D64 unter dem Punkt 6.Gesetzeslage Absatz D explizit für einen Urheberschutz aus, der die Kreativen selbst begünstigt und nicht überkommene Verwertungsmodelle zementiert. An keiner Stelle wird der Begriff des geistigen Eigentum diskutiert. Dabei wäre eine klare Position zu diesem Terminus wegweisend. Denn es zeichnet sich ab, dass in der nächsten Dekade Patentkriege weitaus mehr Einfluss auf die Art und Weise, wie wir das Netz nutzen haben werden als beispielsweise die Medienkompetenz der User.

Fazit

Bei 15 Seiten fällt vor allem auf, dass etliche Themen nicht oder nur #reichlichschwammig™ behandelt werden. Relevante Forderungen sind das Grundrecht auf einen Internetzugang, die Ablehnung der Vorratsdatenspeicherung und eine Überarbeitung des Urheberrechts. Damit bewegt sich der D64 tatsächlich in der Mitte der Netzgemeinde.

Von einer Charta muss man allerdings viel mehr erwarten. Sie sollte in der Lage sein, die netzrelevanten Themen in einen Kontext zu den Rechten in der realen Welt zu stellen. Sie müsste für jeden Leser deutlich machen können, dass es keinen Unterschied zwischen der gesellschaftlichen Partizipation am Wahlkampfstand einer Partei und der Kommentierung des Parteiprogramms im SPD-Blog gibt.

In der aktuellen Version ist die D64-Charta ein hervorragendes Beispiel wie eine Netz-Charta nicht sein sollte. Vielleicht ist sie ja wenigstens für diesen Zweck gut.

Die Funktion von Cookies aus Nutzer- und aus Betreibersicht

tl;dr. Unterscheidet man den Nutzen von Cookies nach ihrer Funktion für User und der Funktion für Anbieter wird deutlich, dass Cookies der Lebenssaft der digitalen Branche sind. Für die User bieten sie aber nur marginale Vorteile. Die Branche wird nicht aufhören immer mehr Daten zu sammeln, bis eine lückenlose Vorratsdatenspeicherung über jeden Nutzer existiert.

Die Firma nugg.ad (Tochter der Deutschen Post DHL) ist einer der größten deutschen Trageting-Dienstleister und lebt davon, dass auf einer Seite Cookies von einer anderen Seite gesetzt und gelesen werden können. Ist diese Funktion ausgeschaltet kann nugg.ad kein Profil erstellen.

Http ist an sich zustandslos. Das meint, dass der Aufrufende (“gib mir folgende Datei”) vom Vorhaltenden (“hier hast du die Datei”) nicht erkannt werden kann. Ohne weiteres weiß er nicht, wer da grade dieses Bild will und in welchem Kontext er sich grade befindet. Und damit fängt das Dilemma an.

Prinzipiell gibt es unterschiedliche Interessen für die (Wieder)Erkennung von Nutzern. Im Folgenden werden zuerst die Interessen der Nutzer dargestellt und danach die der Anbieter. Aus der Gegenüberstellung wird deutlich, dass Cookies im Interesse, ja sogar die Basis vieler Business-Modelle der (meisten) Anbieter sind. Für die Nutzer sind sie jedoch in den meisten Fällen ein lässliches Ärgernis und oft auch die falsche Technik.

Die Nutzerinteressen

Aus Nutzersicht ist eine Request-übergreifende (“der User folgt einem internen Link”) oder eine Session-übergreifende (“der User kommt nochmals auf die Site”) Zuordnung zu unterscheiden. Die Wiedererkennung bietet erstens eine komfortable Anmeldung oder/und die Personalisierung von Inhalten oder Formaten.

Die automatische Anmeldung ist ohne Frage eine hilfreiche Funktion. Es gibt allerdings dafür http-Authentifizierung. Ein bestimmter Bereich verlangt eine Authentifizierung und ohne ein gültiges Login und Passwort sieht man nichts. Alle Browser verfügen über einen eingebauten Mechanismus, sich auf Wunsch diese Anmeldungen zu merken. Und über https gibt es auch die maximal derzeit verfügbare Sicherheit*. Cookies sind für diese Funktion absolut überflüssig.

Personalisierung bedeutet, dass der Nutzer bewusst oder unbewusst das Verhalten, respektive das Aussehen einer Seite oder einer Site verändert.

Beginnen wir mit dem bewussten Verhalten. Sitebetreiber finden es manchmal eine gute Idee: der Nutzer habe doch bestimmt seine eigenen Präferenzen und möchte sich die Seite einrichten nach seinem Gusto. Deutlich zu sehen bei der DRadio-Wissen-Seite oder bei der letzten Version von Xing. Man kann Inhaltsboxen hin und her schieben und sich damit die “Startseite” anpassen. Diese Einstellung wäre natürlich sinnlos, wenn man beim nächsten Aufruf alles wiederholen müsste. (Nun finden lustigerweise wenig ausgewiesene Experten Personalisierung toll. Prominentes Beispiel war hier Bertelsmann mit Bol. Die hatten in New York am Time Square mal 50 Datenbankenexperten sitzen, die sich mit dem Speichern von User-Preferenzen beschäftigen sollten. Bol hat es bekanntermaßen nicht weit geschafft.)

Aber auch das unbewusste Verhalten eines Nutzers kann Einfluss auf das Aussehen und den Inhalt einer Seite haben. Allein durch die aufeinanderfolgenden Klicks oder durch Aktionen in der Vergangenheit könnte ein Nutzer vermitteln, was er eigentlich sucht und was man ihm daher anbieten soll. Dieses Verfahren wird Behavioral Targeting genannt. Prominentestes Beispiel ist Amazon mit der Liste ähnlicher Produkte. Diese Liste wird in Abhängigkeit von meinem bisherigen Verhalten momentan oder meiner Kaufhistorie variiert. Ein großer Teil von Amazons Erfolg geht auf diese Funktion zurück, die man sich damals bei der Firma Net Perceptions gekauft hat.

Innerhalb einer Session würde sowohl die Anpassung an das bewusste als auch an das unbewusste Verhalten mit Hilfe von Session-IDs funktionieren. Diese werden als Parameter über die URL von einer Seite zur nächsten übergeben**. Session-übergreifend funktioniert dieses Verfahren nicht, da nicht gewährleistet werden kann, dass die URL nach wie vor von dem ursprünglichen Browser aufgerufen wurde.

Die Personalisierung – egal ob auf der Basis von bewusstem oder unbewusstem Verhalten – ist jedoch generell problematisch. Heute nutzen die User Sites in verschiedenen Situationen. Auf der Arbeit mit dem Firmen-PC, auf dem Weg nach Hause mit dem Handy, zu Hause mit dem Tablet u.s.w. Eine Personalisierung könnte dann also nur funktionieren, wenn die Cookies mitgenommen würden. Das werden sie momentan*** nicht. Ausserdem sind die Geräte jeweils so unterschiedlich, dass die Webseiten sowieso verschieden aussehen.

Die Anbieterinteressen

Vor der Erfindung der Cookies stand die Frage von Henry Ford, welche Hälfte der Marketingausgaben denn wohl umsonst ist. Denn dass nicht jede Kommunikation bei den Empfängern auf fruchtbaren Boden fällt ist klar. Der Tampon-Spot im StarTrek-Werbeblock könnte vergebene Liebesmüh sein. Das Banner für das iX-Abo auf gofeminin scheint deplatziert.

Henry Ford würde heute feststellen, dass es doch am besten wäre, die Kommunikation für jeden einzelnen Empfänger anzupassen. Denn sicher gibt es für jeden einen bestimmten Schlüsselreiz, der ihn dazu bringt, sofort den Scheck zu unterschreiben. Was wie ein Horroszenario klingt ist nur das fertige Bild, wenn man heutige Puzzlesteine zusammensetzt.

Mit Hilfe von Cookies kann erkannt werden:

- ob ein Nutzer bereits auf der aktuellen Seite war,

- und wenn ja, was er sich angesehen hat,

- dort bereits etwas gekauft hat und wenn ja,

- was er dort gekauft hat,

- ob er irgendeine Werbung dieser Seite gesehen hat und wenn ja,

- welche Werbung dieser Site er gesehen hat und

- ob er diese geklickt hat,

- ob er (auf der Seite auf der diese Werbung ist) bisher überhaupt mal war,

- und wenn ja, welche Werbung er dort schon mal gesehen und

- möglicherweise geklickt hat,

- welche Themen er sich auf verschiedenen Seiten ansieht.

Etliche Szenarien sind nur möglich, wenn verschiedene Teilnehmer Daten austauschen. Dies geschieht schon länger. Deutlich wird, dass immer öfter Konkurrenten über ein Intermediate zusammenarbeiten. Der Vorteil der verbesserten Daten ist tatsächlich höher zu bewerten als die Tatsache, dass ein Wettbewerber Informationen erhält.

Dabei spielt es übrigens keine Rolle, ob die Daten personalisierbar sind. Im Gegenteil: personenbezogene Daten neigen zu Korrosion wenn Nutzer ihre Wohn- oder Mailadressen ändern, heiraten oder das Konto wechseln.

Cookies bieten damit ganz abstrakt die Möglichkeit einer vollständigen Vorratsdatenspeicherung aller Interaktionen eines Nutzers im Web. Und mit dieser Historie lassen sich komplette Persönlichkeitsprofile bilden, Verhaltensmuster in Cluster zusammenfassen. Basierend darauf können Kommunikationsmaßnahmen und -inhalte so gesteuert werden, dass die Response-Rate optimal ist. Also die Wirkung des Marketings nicht weiter verbessert werden kann. Dabei umfassen Kommunikationsmaßnahmen nicht nur Banner und TV-Spots.

Inhalt und Stil eines Zeitungsartikels kann genauso customized werden wie Produktname und vermeintlicher Hersteller. Es könnte ja sein, dass eine kleine Gruppe von Usern durchaus Nivea kaufen würde, wenn man sie nur in eine Steampunk-Packung füllt und sie nach Prinzessin Leia benennt. Der Makerbot im Netto um die Ecke macht es möglich.

Sicher eine lustige Vorstellung. Wenn es jedoch um Krankenversicherung, Job-Angebote, politische Meinungsäusserung und Reisefreiheit geht und damit letztlich um eine durchlässige Gesellschaft, dürfte vielen das Lachen im Halse steckenbleiben.

Und es bleibt festzustellen, dass existierende Daten immer Begehrlichkeiten wecken.

—

Über mich: In der c’t 6/96 erschien mein letzter Artikel für die Zeitschrift mit dem Titel “Faules Backwerk – Auf dem Weg zum gläsernen Web-Surfer” http://www.heise.de/ct/artikel/Faules-Backwerk-284550.html . Seitdem arbeite ich mehr oder weniger permanent als Experte für Web-Analyse. Meistens mit Tools von Drittanbietern, oft aber auch mit selbst entwickelter oder mindestens selbst entworfener Software. Jenseits von Logfile-Analyse gibt es heute keine relevante Lösung, die ohne Cookies auskommt. Eine der wesentlichen Merkmale der Branche ist nach meiner Meinung ein Wettrüsten um die Datenqualität und -granularität. Die Interessen der Nutzer vertritt in diesem Wettkampf niemand.

—

*) Zumindest mehr als derzeit mit Cookies.

**) Session-IDs in der URL haben insbesondere wg. Suchmaschinen und Bookmarks oder URL-Weitergabe einen schlechten Ruf. Das sind aber Probleme die längt gelöst sind.

***) Alle Browserhersteller arbeiten daran, die Cookies über zentrale Services zu synchronisieren.