Bitlove-Proxy for the rest of us

[Update] Der Bitlove-Proxy läuft inzwischen und steht zur freien Verfügung unter: “Bitlove-Proxy läuft” [/Update]

tl;dr Der Bitlove-Proxy ist ein Aggregator für das automatische Laden neuer Podcast-Folgen über Torrent auf der Basis von Bitlove und Prittorrent. Momentan nicht mehr als ein proof of concept. Jeder fühle sich frei, die Idee zu klauen und eine bessere Implementierung zu machen.

Das Medienimperium metaebene schickt sich an, die Podcast-Distribution zu revolutionieren. Statt einfacher Downloads sollen in Zukunft die Nutzer selbst den Vertrieb übernehmen. Peer-to-Peer auf der Basis von Bittorrent soll das dringende Problem der tröpfelnden Bits der neuesten NSFW-Folge lösen. Dazu haben sich @timpritlove und @astro1138 zusammengetan, Prittorrent entwickelt und Bitlove.org gelauncht. Bei soviel Liebe konnte ich nicht anders, als mitzumachen.

Auf Bitlove haben Podcaster die Möglichkeit, ihre Inhalte als Torrent-Dateien anzubieten. Viele sind dem Vorbild der deutschen Podcast-Ikone Tim Pritlove gefolgt und haben ihre Feeds dort eingetragen. Die Akzeptanz der Podcaster ist offensichtlich kein Problem. Die Akzeptanz der Nutzerschaft lässt nach meiner Einschätzung allerdings noch zu wünschen übrig. Selbst solche Strassenfeger wie Not Safe For Work haben im Peek momentan nur selten über 100 Torrent-Downloads. Die Zahl der Torrent-Seeder überschreitet derzeit nur selten die zehn. Für ein neues Projekt sicher nicht schlecht. Da ist aber sicher mehr drin, denn unter der Hand sprechen Reichweitenmesser wie die agof und die IVW schon davon, dass Podcasts das Broadcastingradio längst hinter sich gelassen haben. (Nein, nicht wirklich ![]()

Um dem Projekt mehr Schub zu geben, entwickle ich grade einen Bitlove-Proxy. Zur Erklärung, was der tun soll, hilft sicher eine Beschreibung, wie ich und meine Partnerin Podcasts konsumieren: In unserem Haushalt gibt es eine recht hohe Dichte an Apple-Geräten. Ich selbst höre Podcasts auf den täglichen Radwegen von und zur Arbeit und wenn wir mit dem Auto auf Reisen sind. Meine Partnerin hat einen täglichen Arbeitsweg von zwei mal einer Stunde, entweder mit der Berliner S-Bahn oder wenn die wiedermal nicht fährt mit dem Auto. In der Woche hören wir manchmal bis zu 20 Stunden Podcast.

Ein ernstes logistisches Problem stellt sich dabei recht schnell ein. Auf welchem der neun Rechner/Telefone/Tablets muss eine Folge vorrätig sein? Immerhin reden wir über permanent mindestens zehn Podcast-Feeds mit teilweise über hundert Folgen (CRE aus der metaebene) und manchmal vier Stunden Dauer (mobilemacs ebenfalls aus der metaebene). Und wöchentlich kommt ein neuer Podcast hinzu, in den wir demnächst mal reinhören wollen (z.B. omega tau mit spannenden Wissenschaftsthemen).

Die einfache Lösung besteht in unserem Alltag darin, bei Bedarf auf die WebSite seiner Wahl zu gehen und das mp3 direkt im Browser abzuspielen. Ein ebenso unpraktisches, wie unsoziales Verfahren. Unpraktisch, weil die Browserexperience recht bescheiden ist. Unsozial, weil man damit die Hosting-Rechnung des Podcast-Anbieters belastet.

Hier kommt jetzt wieder Bitlove ins Spiel. Was, wenn nicht meine ganzen iDevices dutzende Kopien der MP3s vorrätig halten (und damit natürlich wiederum die Hosting-Rechnung …) sondern mein eigener Server – auf dem meine Blogs laufen – die Arbeit übernimmt und sich auch noch überaus sozial an der Distribution der Podcasts beteiligt? Ein Bitlove-Proxy also.

Diesem Server gebe ich einfach die Feed-Adressen meiner gewünschten Podcasts. Bei der Einrichtung eines neuen Feeds und in regelmässigen Abständen fragt der Server dann bei Bitlove nach, ob es die jeweiligen Folgen als Torrent-Datei gibt. Wenn ja, lädt er diese runter und startet automatisch den Torrent-Leech.

Bin ich nun unterwegs und möchte einen Podcast hören lade ich einfach eine simple Webseite meines Servers und kann die gewünschte Folge als MP3 von meinem eigenen Server hören.

Tatsächlich kann ich in Zukunft auch iTunes selbst auf meinen eigenen Server schicken, da dieser mir den Feed so umbauen kann, dass er Folgen nur dann einträgt, wenn diese bereits komplett runtergeladen sind. Da die Seeder bei Bitlove offensichtlich über gute Anbindungen verfügen, dauert dies im Allgemeinen nur wenige Minuten.

Technisch ist meine Implementierung eher ein Hasardeurstück: Ein Apache routet die Anfragen an einen internen node.js-Server durch. Dieser dient hauptsächlich dazu, per Komandozeile einen Saxon-Prozessor unter Java aufzurufen, der die Feeds mittels XSLT in eine Webseite umwandelt. Das XSLT ruft beim Transformieren wiederum den lokalen node-Server auf und führt dadurch dazu, dass bei Bitlove vorhandene Torrent-Dateien lokal gespeichert werden und an den XSLT-Prozessor meldet, welche MP3s tatsächlich verfügbar sind. Derzeit sind keinerlei Personalisierungsfeatures eingebaut. Da ich es selbst eigentlich nur als proof of concept begreife, bin ich mir auch nicht ganz sicher, ob ich den Code auf Github stellen sollte.

Vielen Dank bei der Gelegenheit an Astro von Bitlove, der so nett war, die Unterstützung des HEAD-Protokolls mal eben so zu implementieren und neben Bitlove noch so coole Sachen, wie node-expat macht. Ein Eventgesteuerter XML-Parser für node.js. Ich begrüße das!

Datenschutzregelungen sind zu kompliziert – selbst für den Innenminister

Nachdem ich ja neulich schon festgestellt hatte, dass die geltenden Datenschutzbestimmungen für die engagierte Netzgemeinde zu kompliziert sind zeigt sich grade, dass auch der Innenminister die einfachsten Regeln nicht versteht. Das Innenministerium hat heute den Preis im Ideenwettbewerb “Vergessen im Internet” verliehen. Auf der Seite wird lobenswerterweise Piwik verwendet. Entgegen den deutschen Datenschutzbestimmungen wird jedoch ein Cookie mit einer Gütigkeitsdauer von 2 Jahren gesetzt. Und dies entgegen den Ausführungen in der Datenschutzerklärung. Denn eine Personalisierung ohne Registrierung findet nicht statt und bräuchte daher keine Cookies. Wie eine korrekte Datenschutzerklärung bei der Verwendung von Piwik aussieht? Hier.

Gänzlich verwirrend wird es, wenn davon die Rede ist, dass

die gespeicherten IP-Adressen nicht weitergegeben (auch nicht an den Auftraggeber)

werden. Wer ist hier der Auftraggeber. Laut Impressum wird das “Internetangebot […] herausgegeben vom: Bundesministerium des Innern – Projektgruppe Netzpolitik”. Was hat der Nutzer unter Auftraggeber zu verstehen? Eine Anonymisierung der IP-Adressen findet offensichtlich nicht statt. Vielleicht sollte sich Herr Friedrich mal mit einer ehemaligen Justizministerin unterhalten.

WordPress mit Geotagging

WordPress unterstützt von Hause aus kein Geotagging für Artikel oder Fotos. Da hätte ja vor Jahren auch keiner dran denken können. Allerdings bietet z.B. die iOS-App die Möglichkeit, die aktuellen Koordinaten als Metainformationen mit in der Datenbank zu speichern. (In der App kann man jedoch keinen abweichenden Ort für den Artikel hinterlegen.)

Mit ein wenig Phantasie kann man sich jedoch etliche Anwendungsfälle für eine solche Information vorstellen. Von Restaurantkritiken, über lokalisierte Google-Suche und Reiseblogs könnten von Ortsgebundenen Posts profitieren. Man stelle sich nur eine Fahrt ins Grüne vor bei der man seinen RSS-Feedreader öffnet und die Posts verschiedener Blogs nach Entfernung sortiert werden. Aber auch die RSS-Formate haben von Hause aus keine Felder für Latitude und Longitude (Hier gibt es ein Beispiel, wie man mit .Net Feeds um Geoinformationen erweitert.) Nichts desto trotz gibt es aber auch (noch) keinen RSS-Reader, der die Koordinaten auch verarbeiten kann. Ein typisches Henne-Ei-Problem.

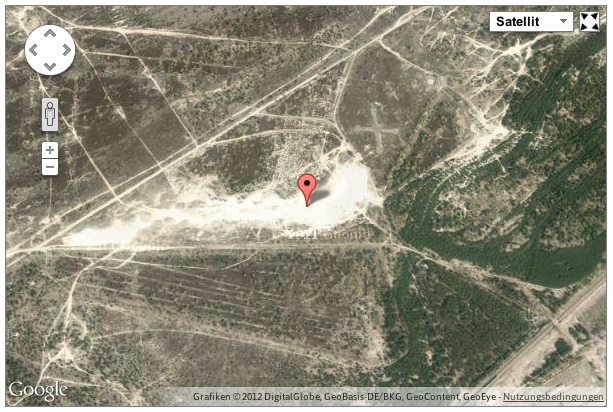

Für unser neues Blog-Projekt umberlinrum.de haben wir eine Lösung gesucht, die mit den Meta-Informationen umgehen kann. Erstens sollen zu den Artikeln Karten eingebettet werden, die den beschriebenen Ort oder die Route darstellen können, zweitens sollen die Posts nach Entfernung sortiert werden können, respektive Artikel aus der Nähe automatisch verlinkt werden und drittens soll WordPress später mal ein KML-File anbieten, das Orte und Routen verlinkt.

Für die Karten fand sich das sehr gute WortPress-PlugIn Google Maps GPX. Mit seiner Hilfe kann man mit kurzen Angaben wie

[

maplat=51.493 lon=7.45 z=15 maptype=satellite]

eine Karte in einem Post positionieren. Karten von Google Maps und OpenStreetMap sind möglich, Marker und Routen. Man kann sogar Fahrradwege und die aktuelle Verkehrslage einbinden. Mit Hilfe von GPX-Routen-Daten (z.B. aus Track für iOS) oder KML-Files lassen sich auch Routen incl. Höhenverlauf darstellen.

Allerdings braucht das PlugIn immer noch die manuelle Eingabe der Koordinaten und kann diese leider nicht aus eventuell vorhandenen Meta-Informationen oder gar aus den EXIF-Daten von eventuell vorhandenen Fotos extrahieren und als Basis für die Karten verwenden.

Für die Sortierung der Ergebnisse nach Entfernung bietet sich das WP-PlugIn “WP Smart Sort” an. Damit kann man beliebige Felder aus der WP-Datenbank (native ebenso wie Meta-Informationen) auswählen und als Widget für eine Sortierungsoption in die Seite einbauen. Es ist relativ rudimentär und liefert nur ein Pull-Down-Menue. Es verwendet jedoch echte URLs ohne dynamische Parameter, so dass es sich leicht überall als Link einbauen lässt.

Für die Sortierung nach Entfernungen tritt jedoch ein etwas komplexeres Problem zu Tage. Die Koordinaten sind natürlich als Latitude und Longitude angegeben und es macht keinen Sinn, Artikel erst nach Breite und dann nach Höhe sortieren zu lassen. Als einfache Lösung bietet sich Pythagoras an: WURZEL((ORIGIN-LAT – TARGET-LAT)^2 + (ORIGIN-LON – TARGET-LON)^2). (Wobei die Längen- und Breitengrade natürlich noch normalisiert werden müssten. )

Trägt man diesen Wert dann als zusätzliches Feld in die Meta-Informationen ein, kann man Smart Sort so konfigurieren, dass der Wert als Sortierungsparameter verwendet wird. Dabei kommt dann zum Beispiel eine solche Liste hier raus: Liste der Artikel sortiert nach Entfernung von Berlin aus. An dem KML-Export und den Daten im RSS-Feed muss nun noch gearbeitet werden.

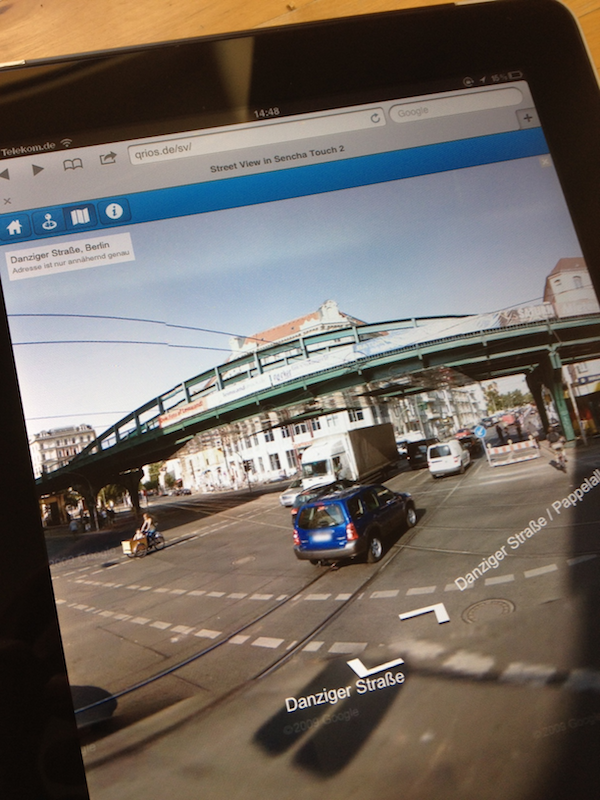

Street View mit Sencha Touch 2 auch unter WebKit Mobile

Street View funktioniert relativ gut auf dem iPad 1G und 2G und dem iPhone 4 und 4S. Probleme gibt es mit dem neuen iPad. Offensichtlich ist die Datenmenge der Bilder hier der limitierende Faktor. (Link: qrios.de/sv)

Unter qrios.de/sv habe ich einen Test mit Street View unter WebKit Mobile laufen. Erstaunlicherweise bietet Google Maps seit einiger Zeit Street View auch für mobile Browser an. Das erste große Framework, das das jetzt eingebaut hat ist Sencha Touch 2. Ich bin eigentlich kein großer Fan von Sencha respektive ExtJS. Allerdings lassen sich damit wirklich extrem schnell mobile Web-Applikationen erstellen. Diese sind inzwischen sogar relativ performant und z.B. schneller als vergleichbare Sachen mit jQuery Mobile.

Datenschutzregelungen sind zu kompliziert – selbst für die Netzgemeinde

Auf der Suche nach beispielhaften Datenschutzerklärungen könnte man auf die Idee kommen, bei Leuten nachzuschauen, die sich damit auskennen. Man schaut ja auch in den HTML-Code einer Seite, die einem gefällt (ich mache das zumindest so). Was liegt also näher, bei der digitalen gesellschaft, beim D64 oder der re:publica nach einer gesetzeskonformen Datenschutzerklärung zu suchen?

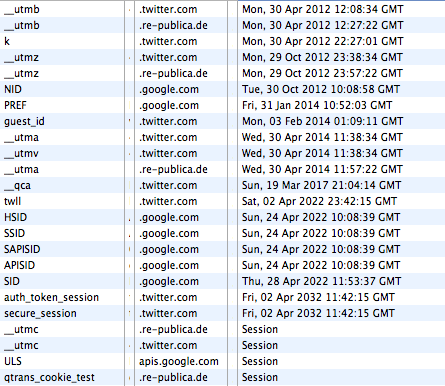

Die Site der re:publica geht recht freigiebig mit den Daten der Nutzer um. Twitter und Google setzen gleich mal 10-Jahres-Cookies. (Quelle: http://re-publica.de/12/impressum/)

Was eine “gesetzeskonforme Datenschutzerklärung” grundsätzlich bieten müsste, erklärt zum Beispiel e-recht24.de. Und tatsächlich scheint die Datenschutzerklärung von D64 eine sehr gute Einsicht zu geben, welche Daten, von welchem Anbieter zu welchem Zweck erhoben werden. Die PlugIns von twitter und facebook werden aufgezählt und selbst Askimet (eine WordPress-Plugin zur Spam-Erkennung) wird erwähnt. Vorbildlich. Wäre da nicht auf der Homepage ein Video von vimeo eingebunden. Dieses PlugIn wiederum verwendet offensichtlich Google Analytics wodurch interessanterweise die letzte Video-Suche auf Google via D64 zu vimeo gelangt und dort wieder mit Google verknüpft wird. Von solchen Datenflüssen und dem Zweck der Speicherung erfahre ich als User nicht und kann also weder still zustimmen noch Einspruch erheben.

Bei der Digitalen Gesellschaft gibt es zwar ein reisserisches Statement über das Engagement des Vereins für den Schutz der privaten Daten, selbst äussert man sich aber eher zurückhaltend. Oder anders: es gibt keine explizite Datenschutzerklärung. Selbst im Impressum findet sich eine solche nicht. Als Tracker kommt Piwik zum Einsatz. Von aussen ist nicht einsehbar, ob das System so konfiguriert ist, dass die IP-Nummern anonymisiert werden. Zusätzlich setzt der Server noch eine PHP-Session-ID und diverse Google-Analytics-Cookies über das twitter-PlugIn. Darunter auch die Information, dass dieser Browser irgendwann mal auf favstar.fm war. Ein Cookie nennt sich “__qca” und kommt von einer Firma namens Quantcast, eindeutig von der dunklen Seite der Macht. Volle fünf Jahre soll dieser Cookie Bestand haben.

Auch die Netzpolitiker der CDU hinken jedem popeligen Netzshop in Sachen Datenschutzerklärung hinterher. Sie haben einfach keine. Allerdings sind sie in Bezug auf Social-PlugIns wenigstens weiter als die Digitale Gesellschaft. Denn sie verwenden wenigstens die Opt-[Korrektur]In[/Korrektur]-Version. Allerdings ist bei einer oberflächlichen Recherche nicht zu ermitteln, warum ein Cookie gesetzt wird, dass zum Beispiel den ursprünglichen Referrer für mindestens ein halbes Jahr an den Server schickt.

Vielleicht hat ja die re:publica eine vernünftige Datenschutzerklärung? Immerhin steht sie dieses Jahr unter dem Motto ACT!ON und es geht unter anderem um die Gefahren für Aktivisten durch Überwachungssoftware. Im Impressum findet sich nichts und eine explizite Datenschutzerklärung findet sich gar nicht. Aber warum auch, immerhin setzen die Veranstalter auf “den gesunden Menschenverstand”. Meint bestimmt, dass man vor dem Aufruf der Seite erstmal nachschaut, welche Daten erhoben und wie diese verwendet werden. Man könnte sich ja vielleicht den Vortrag “Die Gesetze der Daten” anhören. Denn “Der Datenschutz wird uns nicht helfen können” ist doch eine einleuchtende Legitimation für die fehlende Sensibilität der Speerspitze der Netzgemeinde in Sachen Datenschutz für ihre eigenen User.

Windows 8 nicht für aktuelle Geräte?

Man könnte (wie ich) sprachlos sein über die Meldungen heute zu Windows 8 und der fehlenden Upgrademöglichkeit für bisherige Windows-Phone-Phones. @web_martin trieb es jedoch die Zornesröte ins Gesicht und er verfasste einen Rant, der sich gewaschen hat. Ich stimme ihm zwar nicht zu, dass es für Nokia zu spät ist noch auf den Android-Zug aufzuspringen (es soll zumindest in Berlin einen Raum geben in dem verschiedene Geräte damit getestet werden und die Telcos sind ja sowieso der Meinung, dass sich Nokia-Geräte mit Android besser verkaufen würden) aber insgesamt teile ich seine Meinung. Eine solche Entscheidung wäre der Sargnagel für Windows Phone. Und hoffentlich auch das Ende von Ballmer und Elop.

Spekulationen über Apples “revolutionäres Gerät”

Da nicht nur die vier von der Tankstelle regelmässig Mutmassungen über “ein revolutionäres Gerät” aus Apples Pipeline anstellen (und selbst Philippe Starck Teil des Hypes sein will und dann doch wieder nicht), sondern das Thema inzwischen ein wiederkehrender Agendapunkt beim Feierabendbier im Freundeskreis ist, gibt es hier einige Ideen. Denn es kann ja durchaus sein, dass Apple auch noch nicht weiss, worum es sich handelt.

Eine wirklich kontemplative Dockingstation für das iPad. Mehr nach dem Klick. (Quelle: http://www.scott-eaton.com/2011/ipad-docking-station)

1. Fernseher

Nein, das ist zu offensichtlich. Wahrscheinlicher ist “The new MacMini”. Allerdings ein MacMini, der nicht nur die Vorläufer dieser Geräteklasse ablöst, sondern gleich mal den Mac Pro aus dem Regal wirft. Der neue MacMini wird stapelbar sein (was sie heute schon sind) und sich durch Übereinanderstapeln zu einem einzigen Rechner verbinden. Über Thunderbold-Kontakte schliessen sich die Rechner zusammen und erscheinen als ein einziger Computer. Ein aktueller Mini (rechts unten) hat 2,5 GHz à Dual-CPU, 4GByte Speicher, eine vernünftige GPU und 500GB HD. Das alles gibts zum Preis von 800 €. Das Rechts-unten-Modell eines Mac Pro hat 6 Xeons (Dual-CPU) à 2,6 GHz, 6GByte Speicher, eine TeraByte-Platte und eine Highend-Graphic für den Preis von 4900 €.

Bereits mit 6 MacMinis hätte man gleich viele Cores, drei mal soviel Speicher, 6 GPU’s mit 1,5-fachem Speicher und 6 HDMI-Ausgänge. Man könnte über Thunderbold ein Display mit über 24 Millionen Pixel ansteuern. Was bei einem Verhältnis von 16:9 etwa 10K entspräche, nähme man die berühmten 4K zur Grundlage. Über die dann 6 FireWire 800, GigaBit-Ports, Audio In und Out, SD-Card-Slots und nicht zuletzt 24 (in Worten vierundzwanzig!) USB-Anschlüsse kann man bei einem Preis von 4800 € getrost hinwegggehen.

Für Apple hätte das den Vorteil, dass eine komplette Produktlinie wegfallen würde. Produktion, Werbung und Support würden erheblich einfacher und die Leute könnten sich wie Junkies einfach jeden Monat einen neuen Rechner kaufen. Irgendein Photoshop- oder Logic-Plugin wird die Anschaffung schon rechtfertigen.

2. Fernseher

Oder doch besser das Dual-Use-iPad: Das “iPad NG” sieht eigentlich aus, wie ein normales iPad. Erst wenn der User das Gerät mit dem Magic-Cover auf den Schreibtisch stellt, wird es zum MacBook Air. Statt iOS sieht man plötzlich OSX. Die Bedienung wechselt auf Tastatur und Trackpad. Die Nutzerdaten sind die gleichen, alles fügt sich dort wo man es abgelegt hat. Manche Apps kann man im App Store für OSX kaufen und sind dann direkt auch als iPad-App verfügbar. Bei Mail zum Beispiel kann man direkt zwischen der iPad-Version und der OSX-Version wechseln, wenn man feststellt, dass man ja noch ein Word-Dokument verschicken wollte. Andere Apps können direkt umschalten, falls man doch die erweiterten Möglichkeiten der Tastatur und der Maus braucht.

Selbst für die iOS-Entwicklung könnte man das Gerät verwenden. Denn derzeit gibt es kein tragbares Gerät, dass in der Lage ist, die Auflösung des neuen iPads in der Simulation darzustellen.

Das “iPad NG” würde gleich zwei Geräteklassen obsolet machen. Die MacBook Airs und das MacBook Pro unter 15″. Auch hier wieder Einsparungen in der Produktion, Werbung und dem Support.

3. Fernseher

Letztlich wird es aber wahrscheinlich doch ein schnöder Fernseher. Er wird sicher der flachste Fernseher (sic!) den die Welt bisher gesehen hat (wenn man ein Auge zudrückt und mit dem Zweiten sieht). Und er wird die ersten Jahre nur über Kabel-Provider (Telekom) und/oder Sender (HBO, Netflix) vertrieben. Er ist verdongelt oder besser gesagt gut geschützt gegen Datendiebstahl und -manipulation. Man wird natürlich auch seine Medienbibliothek (nach aufwendigem Torrent-Download und Umkodieren mit dem “The new MacMini”) abspielen können. Man wird sich allerdings – einige Jahre später – durch “iTunes Match HD” von jeder Schuld freikaufen können.

Die Gesteneingabe wird nicht nur der Steuerung des Fernsehens dienen sondern auch als Controller für Spiele dienen. Sicher nicht nur für Angry Birds sondern auch für Protal. Nicht umsonst geht Tim Cook grade bei Valve ein und aus.

In jedem Haushalt wird dann Siri sein. Siri wird Sendungen “aufnehmen” falls wir mal wieder länger brauchen. Siri wird sogar Out-Door-Sendungen aufnehmen, die wir uns nur ansehen sollten, weil wir übermorgen mit einem Free-Klimber zum Business-Lunch verabredet sind. Siri wird unserem Lebensabschnittsgefährten mitteilen, was noch einzukaufen ist, da sie doch grade am REWE vorbeifahren. Wenn wir unglücklich sind, wird Siri uns die richtige Musik raussuchen. Siri wird die Trennungsmail schicken. Siri wird uns Menschen aus Elitepartner vorstellen. Siri wird uns auf der Basis unserer bisherigen Kocherfahrung Rezepte für das erste Date vorschlagen. Die Slideshow und Hintergrundmusik für den Abend wird Siri auf der Basis des Gastgeschmacks zusammenstellen. Vielleicht wird Siri uns darauf hinweisen, dass der gesellschaftliche Status oder das Kreditrating des Gastes unpassend seien.

warum facebook so viel für instagram bezahlt

Ein Aspekt bei den vielen Analysen zu dem facebook-Instagram-Deal scheinen die Analysten vollkommen zu übersehen: der Preis der User. Viele spekulieren über eine vermeintliche Angst von Zuckerberg vor einer Konkurrenz seitens Instagram. Bei 30+ Mio Usern und einem Special-Interest-Thema im Vergleich zu 850+ Mio und einer breiten Basis von Services dürfte die Fotocommunity kaum problematisch sein. Selbst, wenn ein anderer Großer (Google) Instagram gekauft hätte, dürfte fb nichts zu befürchten haben.

Auf Bootstrapping gibt es eine interessante Aufstellung der Investitionsrunden von Instagram. Betrachtet man die zeitliche Abfolge ist alleine schon die Bewertung in der letzten Runde absolut erstaunlich. Nach nur 17 Monaten hat der Service einen Wert von einer halben Milliarde Dollar erreicht. Mit dem Kauf durch fb wurde jeder Instagram-Nutzer respektive dessen Daten mit rund 30$ bewertet.

Würde man diese Bewertung für die fb-Nutzer anlegen würden allerdings nur ein facebook-Firmenwert von etwas über 25 Milliarden zustande kommen. Das ist weit weg von den Investorenträumen, die fb bei über 100 Milliarden $ sehen.

Die Vermutung liegt daher nahe, dass die letzte Investitionsrunde von Instagram eigentlich nur dem Zweck diente, den relativ hohen Preis pro Nutzer zu rechtfertigen. Es klingt sehr unwahrscheinlich, dass Zuckerberg am Karfreitag bei den Instagram-Gründern angerufen hat um ein unmoralisches Angebot zu unterbreiten. Tatsächlich dürften auch die Investoren aus der Seed-Phase besonders behandelt werden, da sie ja noch eine Woche zuvor diluted wurden. Sie hätten durch den letzten Deal mehr als 100 Mio verloren.

[Update] Langsam kommen einige Hintergründe ans Tageslicht. Erstens soll der Deal tatsächlich innerhalb von wenigen Tagen über Ostern ausgearbeitet und durchgeführt worden sein und zweitens (und wichtiger) ist einer der twitter-Gründer auch Seed-Investor von Instagram gewesen. Dieser Jack Dorsey ist nun offensichtlich nicht sehr glücklich mit dem Verkauf an facebook und wendet sich beleidigt von Instagram ab. Mal sehen, wann weitere Details über den Deal bekannt werden und wann Dorsey mit seinen Anwälten auftritt. [/Update]

Alpha Beta #Charta – Großes Theater vom #D64

Fast wäre die Charta vom D64 an mir unbesehen vorbeimäandert. Doch ein tweet von @in_aha schützte das Dokument vor meinem ewigen Übersehen.

Bei soviel digitalen Lobby-Organisationen (A-, B-, CNetz) kann man schon mal den Überblick verlieren. Da ist es gut, wenn einer davon mehr von Kommunikation versteht als die anderen. Und tatsächlich sitzen beim D64 Leute, die sich mit Kommunikation auskennen. Die erste Regel lautet: GROß DENKEN! Das tun sie. Zum Beispiel dadurch, dass sie gleich mal eine Charta veröffentlichen. Man erinnere sich, dass Chartas formuliert wurden, um die Vereinten Nationen zu begründen (1945) und 1977 um den Ostblock in die Knie zu zwingen. Chartas sind “die für das Staats- und Völkerrecht grundlegenden Urkunden“.

Der jetzt veröffentlichte Entwurf, soll nun von den D64-Vereinsmitgliedern diskutiert werden. Die Plattform dafür nennt sich Zentrum. Auch hier zeigen sich wieder die Kommunikationsprofis. Wer sich selbst in die Mitte stellt kann nicht ausgegrenzt oder marginalisiert werden. Von ihm geht alle Bewegung aus. Andere können sich zwar andocken aber D64 ist das Zentralgestirn.

Im ersten Punkt wird dieses Vorgehen noch mal deutlich: “Als D64 fordern wir, das gesamte Spektrum der politischen, technologischen und gesellschaftlichen Veränderung in den Blick zu nehmen.” Dadurch dass der D64 im Zentrum steht hat er den vollkommenen Überblick. Andere stehen am Rand und werden dadurch immer nur Einzelaspekte des digitalen Lebens betrachten. Egal ob sie sich selbst digitale gesellschaft oder Piraten nennen.

Die weiteren Punkte sind gegliedert in 2. Teilhabe, 3. Datenschutz, 4. Netzpolitik, 5. Öffentlichkeit, 6. Gesetzeslage, 7. Primat der Bürgerinnen und Bürger, 8. Arbeit, 9. Wissenschaft und 10. Transnational. Da sich viele aktuellen Themen dieser Strukturierung entziehen, sollen hier die Antworten auf die wichtigsten Fragestellungen untersucht werden

Netzneutralität und Netzzugang

Basis für eine Gesellschaft in Zeiten des Internet ist auch für den D64 ein freier und überall verfügbarer Zugang zum Netz. Der Verein fordert daher auch den flächendeckenden Ausbau und den kostenlosen Netzzugang. Notfalls soll der Staat selbst investieren. Das Internet wird als ein Grundrecht postuliert.

Um welche Art Internet es sich handelt wird an dieser Stelle noch nicht dargelegt. Aber auch später taucht eine Forderung nach Netzneutralität nicht auf. Lediglich im Kontext des Urheberrechtschutzes wird vor unangemessenen Eingriffen gewarnt. Dabei bleibt unklar was angemessene Eingriffe wären. Sind Stoppschilder oder Domainsperren angemessen? Wer misst und was ist Maßstab?

Vorratsdatenspeicherung, Fluggastdaten

Interessanterweise behandelt der Verein die Vorratsdatenspeicherung unter dem Thema Datenschutz und nicht unter Netzpolitik oder Gesetzeslage. Die anlasslose Speicherung wird umfänglich abgelehnt. Man spricht sich für Quickfreeze mit Richtervorbehalt und Informationspflicht und -löschen aus.

Über die Weitergabe von Daten zum Beispiel im Rahmen eines Fluggastdatenabkommens der EU und den USA sagt der D64 nichts.

Privatsphäre, Datenschutz

“Wir glauben nicht an das Ende der Privatsphäre als Wert.” Der D64 ist also kein Anhänger der Postprivatiers oder Spackeria. Das wäre allerdings auch seltsam. Denn der Verein wird inhaltlich stark von der Post-Tochter nugg.ad bestimmt. Diese Firma betreibt Targeting und Retargeting und lebt damit wesentlich vom Wert der privaten Daten der Nutzer. Ein Ende der Privatsphäre würde ihr Herrschaftswissen egalitären.

Datenschutzmaßnahmen hätten die Aufgabe “vor intransparenten, unkontrollierten und überzogenen Datensammlungen […] zu schützen”. Sie hätten aber “auch das Interesse der Nutzer und der Verkäufer im Netz im Blick behalten …”. “Maßstab muss das mutmaßliche Interesse eines durchschnittlichen informierten Nutzers sein.” Wichtig hierbei ist insbesondere die Mutmaßung. Denn nur sie ermöglicht eine Cookie-Richtlinie auf der Basis von Opt-Out-Verfahren. Ein Betreiber kann damit jederzeit glaubhaft mutmaßen, dass insbesondere ‘seine’ durchschnittlich informierten Nutzer ein Interesse an seiner Datensammelwut hätten.

Anonymität im Netz

Zu einer immer wieder geforderten Pflicht, sich als Nutzer im Netz zu identifizieren nimmt die Charta keine Stellung. Das ist insofern erstaunlich als dass diese Forderung die zentrale Schnittstelle aller Ideen zur Einschränkung der Rechte im Netz ist und mitschwingt, wenn vom rechtsfreien Raum gesprochen wird. Hier hätte sich der Verein wegweisend mit seiner “Charta” zeigen können.

[Korrektur] Hier bin ich Opfer der sehr eigenen Struktur des Dokumentes geworden. Stephan Noller (D64-Gründungsmitglied und nugg.ad-Gründer) wies mich im Kommentar darauf hin, dass unter Datenschutz Absatz H deutlich steht, dass “Die Möglichkeit, das Netz unter Pseudonym zu nutzen” erhalten bleiben muss. Aus meiner Sicht ist dies jedoch kein natives Datenschutz- sondern ein übergeordnetes Thema. Vor allem die Bindung an die BILD-Aufreger Verunglimpfung und Beleidigung spiegeln die Relevanz nicht. Letztlich ist in einer Demokratie die Anonymität der Meinungsäusserung ein Grundrecht. [/Korrektur]

Leistungsschutzrecht, ACTA

In der Charta spricht sich D64 unter dem Punkt 6.Gesetzeslage Absatz D explizit für einen Urheberschutz aus, der die Kreativen selbst begünstigt und nicht überkommene Verwertungsmodelle zementiert. An keiner Stelle wird der Begriff des geistigen Eigentum diskutiert. Dabei wäre eine klare Position zu diesem Terminus wegweisend. Denn es zeichnet sich ab, dass in der nächsten Dekade Patentkriege weitaus mehr Einfluss auf die Art und Weise, wie wir das Netz nutzen haben werden als beispielsweise die Medienkompetenz der User.

Fazit

Bei 15 Seiten fällt vor allem auf, dass etliche Themen nicht oder nur #reichlichschwammig™ behandelt werden. Relevante Forderungen sind das Grundrecht auf einen Internetzugang, die Ablehnung der Vorratsdatenspeicherung und eine Überarbeitung des Urheberrechts. Damit bewegt sich der D64 tatsächlich in der Mitte der Netzgemeinde.

Von einer Charta muss man allerdings viel mehr erwarten. Sie sollte in der Lage sein, die netzrelevanten Themen in einen Kontext zu den Rechten in der realen Welt zu stellen. Sie müsste für jeden Leser deutlich machen können, dass es keinen Unterschied zwischen der gesellschaftlichen Partizipation am Wahlkampfstand einer Partei und der Kommentierung des Parteiprogramms im SPD-Blog gibt.

In der aktuellen Version ist die D64-Charta ein hervorragendes Beispiel wie eine Netz-Charta nicht sein sollte. Vielleicht ist sie ja wenigstens für diesen Zweck gut.

node.js + XSLT 2.0

Mein typisches Vorgehen bei der technischen Evaluation bei einem Projekt läuft in etwa immer gleich. Können wir XSLT einsetzen: Ja? Ok! | Nein? Glaub ich nicht! In den meisten Fällen bedeutet das jedoch, dass entweder nur libxslt und damit XSLT-Version 1 zum Einsatz kommt oder über einen System-Call Java mit Saxon gestartet werden muss. XSLT 1 ist allerdings sehr beschränkt da die Unterstützung für Gruppierungen und Sequenzen nicht gegeben ist. Und der Umweg über Java/Saxon scheidet wg. der dafür anfallenden Zeitkosten in den meisten Fällen aus.

XSLT 2.0 ist seit 2007 definiert und nach wie vor gibt es keinen Prozessor, der es vollständig unterstützt. Mit Ausnahme von Saxon gibt es eigentlich gar keinen Prozessor der es irgendwie unterstützt. Und Saxon gibt es nur für Java und .Net. Eine Implementierung durch libxslt scheint gescheitert und wird offensichtlich nicht weiter betrieben. Und damit steht es für alle hippen Techniken wie Ruby oder Node nicht zur Verfügung.

Robbert Broersma hat sich nun zum Ziel gesetzt XSLT 2 für node.js umzusetzen. Unter XSLT2.org kann man sich für einen Betatest anmelden. Denn derzeit hat er den Code noch nicht zur Verfügung gestellt. Laut eigener Aussage soll dies im Laufe des Jahres geschehen. Da die Implementierung nicht auf node.js beschränkt ist sondern auch in den Browsern arbeiten soll dürfte es sich um eines der spannendsten Projekte aktuell handeln.

Als ein spannendes Anwendungsgebiet kann man sich zum Beispiel die Chartgenerierung oder Sprites vorstellen. Während ein node-Prozess sich um die Transformation aus Templates zu HTML beschäftigt wird aus den XSLTs ein weiterer node-Service aufgerufen der zum Beispiel dynamische Images aus einer Datenbankabfrage generiert und diese für den direkt folgenden Aufruf durch den Browser cached. Da bei einem solchen Setup sowohl zum Beispiel canvas und Flot zum Einsatz kommen kann, könnte der Server in Abhängigkeit von den Fähigkeiten oder der Geschwindigkeit des Browsers die Arbeit an den Browser übergeben oder sie selbst durchführen.