Warum eigentlich IPv6?

tl;dr: IPv6 ist gut für Leute, die sich auskennen. Für den DAU ist es ein Albtraum. Und eigentlich kann man mit bestehender Technik beliebig viele Geräte ans Netz bekommen.

IPv4 ist dem Untergang geweiht und IPv6 steht vor der Tür, ach gewissermaßen schon im Flur. Denn die Adressen gehen zu Ende. Mit 4 Milliarden IP-Nummern ist bald das Ende der Fahnenstange erreicht. Wirklich?

Meine Versuche – Airport Express über FritzBox an Alice – IPv6 einzurichten waren bisher erfolglos und auch meine Server bei Strato zickten so rum, dass ich ihnen IPv6 wieder wegnehmen musste.

Aber die Probleme bei der Migration sind sicher nicht nur in der nichttrivialen Einrichtung zu suchen. Tatsächlich gibt es beispielsweise erhebliche Irritationen in Bezug auf den Datenschutz. Anfangs haben unter anderem Apple-Geräte ihre eindeutigen MAC-Adresse in die IP-Adresse eingebaut und waren damit immer wiedererkennbar. Aber selbst nach der Aktivierung der “Privacy Extensions” sind Rechner für eine bestimmte Zeit identifizierbar und ein Dritter mit Zugang auf Logfiles verschiedener Services (z.B. ein Targeter) kann Beziehungen zwischen der Nutzung mehrerer Dienste herstellen.

Auf der operativen Ebene gibt es momentan Bestrebungen, die Adressvergabe bei IPv6 grundlegend zu ändern. Statt, wie bisher, die Adressen frei (also ohne Ansehen der Person) zu vergeben sollen sie zukünftig zu einer Handelsware werden. Der Markt soll die Verteilung regeln. Es ist absehbar, dass Adresshändler große Blöcke horten und wie bei jedem limitierten Gut werden die Preise langsam aber sicher steigen.

Eine Frage stellt sich jedoch unabhängig von der offensichtlich problematischen Migration: Warum eigentlich IPv6?

Aus Sicht eines technophilen Menschen bietet v6 den tollen Vorteil der statischen IP-Adresse. Jedes Gerät zu Hause ist zukünftig erreichbar. Bisher machte einem die tägliche Neuvergabe der Adresse durch den Provider einen Strich durch die Rechnung. Man brauchte einen Service wie dyndns der einen Hostnamen auf die aktuelle IP-Adresse im DNS einträgt. Und dieses Setup hat noch den Nachteil, dass man hinter einem NAT-Router ist. Dieser erlaubt nur ein Gerät in der DMZ. Hat man mehrere Geräte, die über den gleichen Service laufen sollen wird die Konfiguration schon extrem aufwendig. Für viele anderen Dienste als httpd (Webserver) ist eine Konfiguration auf Basis von Hostnamen nicht möglich.

Mit der Aktivierung der Privacy Extensions für IPv6 entfällt jedoch der Vorteil der eindeutigen Adresse. Man benötigt wieder einen dynamischen DNS. Auf dem Gerät muss also ein Dienst laufen, der dem DNS-Server Bescheid sagt, dass sich seine Adresse geändert hat. Der einzige Vorteil, der dann noch bleibt ist die Tatsache, dass im heimischen Netzwerk alle Geräte auch alle Protokolle parallel anbieten können und von aussen erreichbar sind.

Mit der bestehenden Technik können im Prinzip 4 Milliarden Server und Heim-/Office-Netze bedient werden. Effektiv sind es vielleicht nur 1 Milliarde weil große Firmen große Blöcke haben, die sie nicht nutzen. Viele Server bieten mehrere Web-Seiten unter der gleichen IP-Adresse an und lösen nach Namen auf. Und viele Telcos betreiben Handys ebenfalls hinter NATs. Warum auch nicht? Fast alles läuft über http und selbst Skype bohrt sich durch Port 80 nach aussen.

Wer ausser technophilen Leuten möchte also alle Geräte zu Hause oder im Büro nach aussen sichtbar haben? Ist nicht NAT tatsächlich eine der besten Schutzeinrichtungen vor klassischen Viren und Trojanern, die sich über Lücken in Betriebssystemen verbreiten und nicht auf die Mithilfe der Nutzer angewiesen sind. Wollen die Nerds allen Ernstes wieder regelmäßig bei Freunden und Familie schlechte Router und OS konfigurieren und updaten?

[Update] Tim Pritlove hat in seinem aktuellen CRE-Podcast #197 das Thema IPv6 aufgegriffen und dort gibt es etliche Informationen insbesondere zu den technischen Grundlagen. [Update]

Gute Charts, schlechte Charts

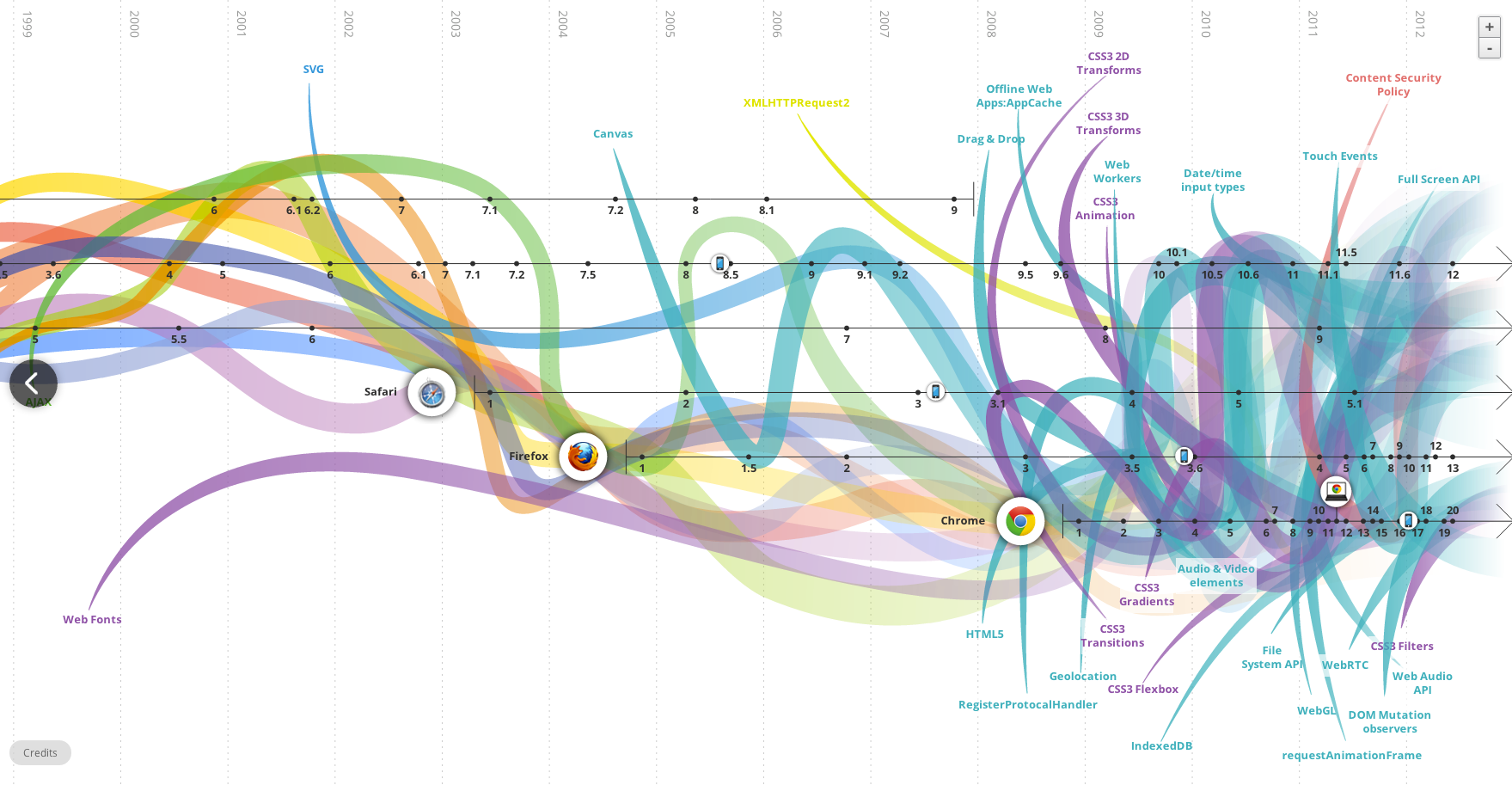

Was sollen diese Linien aussagen? Vielleicht: Früher war alles besser? (Quelle: evolutionoftheweb.com)

Infografikdesign ist total in. Jede Agentur, jedes hippe Magazin und jeder Analyst muss heute regelmäßig mit gut aufbereiteter dabei auch relevanter Information aufwarten. Dabei sollte man das “gut aufbereiteter” allerdings nicht übertreiben. Denn letztlich dient die visuelle Darstellung einzig dem Verständnis des Inhalts. Wenn man diesen Zweck aus den Augen verliert kommt sowas wie “The Evolution Of The Web” bei raus.

Die Darstellung ist nicht anders zu nennen als “mind blowing”. Ein farbiges Feuerwerk zieht sich durch die Epochen des Web und man kann definitiv sehen, dass früher alles einfacher war und heute alles total unübersichtlich. In Kürze dürfte das Web in einer Supernova verglühen.

Und immer wieder bekamen die Entwickler neuer Technologien offensichtlich Besuch aus der Zukunft. CSS3 Transitions sind offensichtlich im Frühjahr 2009 entstanden, um dann wunderbarerweise bereits ein Jahr zuvor in Safari 3.1 benutzbar zu sein. Auch Flash wurde erst nach der ersten Implementierung entwickelt. Möglicherweise ja der Grund, warum Flash so langsam stirbt.

Andere Techniken dagegen tauchen erst zu einem Zeitpunkt auf, als sie in der Realität schon fast wieder tot waren. So entwickelte Adobe sein SVG-PlugIn seit Ende 2001 schon nicht mehr weiter. Im Chart taucht SVG dagegen erst zu diesem Zeitpunkt auf. Dass das W3C fast vier Jahre brauchte, zu standardisieren, was schon längst verwendet wurde ist lustig aber leider öfter so.

Fazit: Man sollte niemals einen Grafiker an ein Chart lassen, ohne ihm vorher genau zu sagen, was seine Kurven und Verläufe ausdrücken sollen.

Sind wir nicht alle ein bisschen Blogger?

Was für eine tolle Podacst-Folge von Alternativlos! Fefe und Frank Rieger bei Herrn Döpfner. Wahrscheinlich mit Blick über Berlin in den höchsten Etagen des Springerhochhauses in der Rudi-Dutschke Strasse Ecke Axel-Springer-Strasse. Und: Herr Dr. Döpfner ist ein Verleger oder vielleicht ein Super-Blogger oder doch eigentlich auch nur ein Blogger.

Und Herr Döpfner ist ganz offen. So offen, dass sehr deutlich wird, dass das Leistungsschutzrecht eine deutliche Warnung an Google ist. Alle Blogger können sich entspannt zurücklehnen und müssen nichts befürchten. Springer liebt alle Blogger. Sicher würde kein Blogger fürchten, von Springer belangt zu werden. Wahrscheinlich auch von keinem anderen Verlag.

Leistungsschutzrecht ist also doch nur ein Papiertiger

Als Leuchtturmbeispiel wird Flipboard genannt, das sich als Aggregatoren mit den Verwertern über eine Abgeltung geeinigt hat. Und nachdem Döpfner lange Zeit in dem spannenden Gespräch den Namen Googles zu nennen vermied wird dann doch deutlich, was Springer antreibt und welchen Zweck der Gesetzentwurf zum Leistungsschutzrecht hat. Es soll Google an den Verhandlungstisch bringen. Denn ansonsten würde ja früher oder später der große Regulator kommen. Und das könne niemand wollen. Selbst Springer nicht.

Das Leistungsschutzrecht als Gestzesentwurf in seiner jetzigen Form ist ein schlecht formuliertes Gesetz, dessen einziger Zweck gar nicht die Verabschiedung ist, sondern eine Drohkulisse aufbauen soll. Unter dem Motto:

Hallo Herr Google, wenn Du nicht mit uns verhandelst, werden wir dieses Gesetz durchdrücken. Und dann verlierst Du einen deiner wichtigsten Märkte.

(Leider finde ich den Link zum Etherpad mit dem Transskript nicht mehr. Da es unter https (mit einem abgelaufenen Zertifikat) lief, gibts das nicht in meinem Browsercache und offensichtlich wurde wieder vandaliert und Rieger hat den Link wieder weggenommen. Mehh …)

Abgehakt: Adobe ✔

Vor über zwei Jahren hatte Adobe eine Warnung an seine Aktionäre ausgegeben, dass ihnen Apple das Leben schwer machen würde und sie damit mit Risiken für ihr Geschäft rechnen. Das hatten sie drei Jahre nach dem Erscheinen des iPhones und wenige Monate nach Launch des iPad getan. Dabei war von vornherein klar, dass es kein Flash auf mobilen Geräten geben würde. Nicht nur weil Apple als Zugpferd der Touchbranche, es nicht gestattete, sondern weil es schlicht und einfach nie funktionieren würde.

Dabei besteht das Problem von Flash auf Touchgeräten nicht mal nur in Fixierung des gesamten Systems auf Maus und Maus-Cursor, die es eben auf einem Touch-Screen nicht gibt, sondern in der absoluten Trotteligkeit von mindestens 95% aller “Flasher”. Spricht man mit solchen Leuten, stellt man fest, dass diese sich sehr oft gar nicht als Programmierer begreifen, sondern eher als Kreative für Animation. Die Entwicklungsumgebung für Flash zieht offensichtlich viele Leute an, die eigentlich gerne mit Maya oder ähnlichem gearbeitet hätten, denen aber das notwendige Vorstellungsvermögen für die z-Achse fehlt. Einzig Ebenen übereinanderlegen und gegeneinander verschieben können die meisten.

Diese Beobachtung ist sicher subjektiv. Sie spiegelt aber sogar die Adobe-eigene Wahrnehmung wieder: schon 2008 kotzte sich einer der Chefentwickler von Flash über die “Flasher” aus.

Mit der Ankündigung der Aufkündigung von Flash für Android verabschiedet sich Adobe nun aus dem (Web-)Mobilmarkt. Weder für iOS noch für Android noch für Windows Phone oder Blackberry wird es Flash geben. Zwar haben Entwickler nach wie vor die Möglichkeit, Flash für die App-Entwicklung zu benutzen. Bis auf einige wenige Games findet dieser Weg keine Anhänger. Denn die Nutzer mögen keine seltsam aussehenden Apps.

Damit geht der letzte Akt in einem elenden Kapitel des Web zu Ende. Es begann Mitte der neunziger als der Netscape Navigator 2.0 mit der PlugIn-Schnittstelle veröffentlicht wurde. Jede Wald-und-Wiesen-Softwarebude brachte damals PlugIns für irgendwelche proprietären Formate raus. Mit dabei war Macromedia mit einem sehr erfolgreichen PlugIn für Shockwave Director. Eine kleine Firma entwickelt FutureSplash. Es ist einfach zu bedienen und lässt die Herzen der Animateure und derer Kunden schneller schlagen. Microsoft launcht auf dieser Basis die MSN-Zentrale. Damals hatten Compuserve und AOL noch statische Portale.

Microsoft hatte es damals allerdings versäumt, die Firma FutureWave zu kaufen. Statt dessen hat Macromedia zugegriffen, die dann später von Adobe gekauft wurden. Schon 1996 war allerdings klar, dass die Idee der PlugIns eigentlich eine dumme war. Für die Darstellung von PDFs bot ein Browser keinen Zusatznutzen sondern restriktierte den User nur unnötigerweise. Nur Audio und Videos liessen sich wegen Lizenzen und Codecs nicht ohne unter das Volk bringen.

Mit dem Versuch aus dieser komfortablen Situation der Abhängigkeit der Nutzer von proprietären PlugIns, Kapital zu schlagen sind jedoch alle gescheitert. Real, Microsoft und nun auch Adobe. Sie hätten es wissen können.

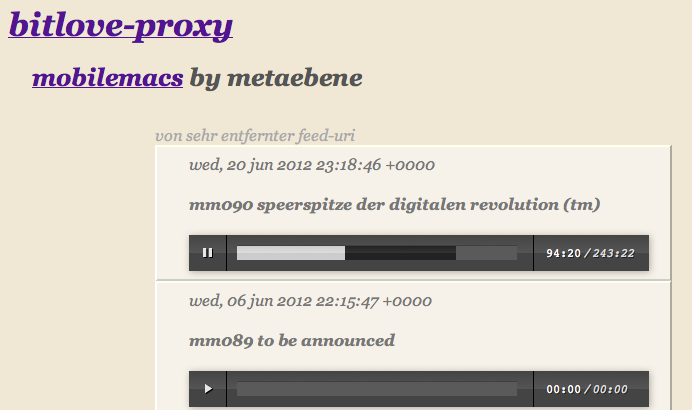

Bitlove-Proxy läuft

Mit etwas Verspätung wg. anderer Projekte ist nun doch der Bitlove-Proxy fertig. Unter “Bitlove-Proxy for the rest of us” ist ausführlich erklärt worum es geht und was der Proxy tun soll. Im Kern geht es darum, die ganze Arbeit mit den Podcast-Torrents und vor allem die Terabyte Mediendaten auf einen echten Server auszulagern und im Hintergrund laufen zu lassen.

Das minimale Interface für den Proxy bietet vor allem das Abspielen on demand. Bei mp4 auch das Springen zu einer Position, die noch nicht geladen ist.

Der Service besteht aus vier Teilen: Apache, node.js-Script, XSL-Template und einem Torrent-Daemon. Der Apache ist notwendig wg. der Auslieferung von Chunks aus MP4. Allerdings ist er nur für das Medienverzeichnis zuständig. Alle anderen Requests leitet er als Proxy an den node.js-Server durch. Das node.js-Script kümmert sich um die Requests des Browsers und verwaltet die torrent- und Medien-Files. Das XSLT verarbeitet die Feed-Daten und baut die HTML-Seite zusammen. Derzeit geschieht letzteres noch im Browser.

In einem XML stehen die Podcasts mit den jeweiligen Feeds drin. Wird die jeweilige Seite jetzt aufgerufen, wird der Feed geparsed und der lokale Server abgefragt, ob die Mediendatei vorliegt. Wenn nicht, wird geschaut, ob eine entsprechende Torrent-Datei gespeichert ist. Falls auch letzteres nicht der Fall ist, wird die Datei von Bitlove.org geholt und der lokale Torrent-Client angewiesen, den Torrent-Download zu starten.

Da der Server mit mehreren hundert MBit angebunden ist, läuft der Download schnell ab. Naja, schnell ist untertrieben: im Falle der letzten mobilemacs-Folge von Gestern waren es laut Logfile von transmission 32 Sekunden. Immerhin handelt es sich um knapp 100MB.

Jun 22 15:44:27 transmission-daemon[23676]: Saved ".config/transmission-daemon/torrents/mm090-speerspitze-der-digitalen-revolution-tm.m4a.898d7344f4a76b76.torrent" (bencode.c:1683)

Jun 22 15:44:37 transmission-daemon[23676]: mm090-speerspitze-der-digitalen-revolution-tm.m4a Starting DHT announce (firewalled, 120 nodes) (tr-dht.c:671)

Jun 22 15:44:59 transmission-daemon[23676]: mm090-speerspitze-der-digitalen-revolution-tm.m4a State changed from "Incomplete" to "Complete" (torrent.c:1869)

Die Quellen kann man hier runterladen. Allerdings empfehle ich das nur wirklich erfahrenen Leuten (Apache-Konfiguration, node.js-Module, etc.), da es keine Dokumentation gibt und ich kaum Zeit für Support habe.

Leistungsschutzrecht: eine Branche schafft sich ab

tl;dr Die Verlage – allen voran die axel springer ag – möchte das Web wieder zu einem Sender-Empfänger-Modell zurückführen. Mit Leistungsschutzrecht und Paywalls sollen ihre Inhalte vor dem unbezahlten diffundieren geschützt werden. Letztlich bauen sie damit nur das Fundament für eine Transformation der Medienbranche. Weg vom Verlag, hin zu EΠC 20151.

Das Thema Leistungsschutzrecht wurde grade in dem immer wieder hörenswerten Podcast aus der metaebene Logbuch: Netzpolitik von Philipp Otto (von iRights.info) dargestellt. Der Entwurf wirft derzeit mehr Fragen auf als einem einfallen können:

- Welchen Umfang dürfen Zitate in Zukunft haben? 10 Worte? 3 Worte?

- Fallen Links darunter?

- Fallen Link-Texte darunter? (sog. sprechende URLs)

- Was ist mit URL-Shortenern?

- Fällt eine Beschreibung der notwendigen Suchbegriffe darunter?

- Wie verträgt sich dieses Gesetz mit dem Zitatrecht?

- Was ist mit Übersetzungen?

- Was ist mit wissenschaftlichen Arbeiten?

- Aber vor allem: Was meint ‘gewerblich’?

Nimmt man beispielsweise qrios.de, dann ist die Frage sehr schwer zu beantworten. Die Autoren arbeiten in exakt dem Themenbereich, um den sich alle Artikel drehen. Die Artikel sind schon deswegen als gewerblich zu bezeichnen weil sie der Sammlung dienen. Jeder Artikel dient der eigenen Meinungsbildung, der Archivierung und sogar dem öffentlichen Diskurs.

Ginge man mit dieser Begründung zum Finanzamt und würde z.B. die Serverkosten, die Schreibgeräte, die Mobilfunkverträge und den heimischen Küchentisch als relevant für diese Tätigkeit abschreiben wollen müsste man mit höhnischem Gelächter rechnen. Selbst, wenn man einen flattr-Button auf der Seite hätte und dort monatlich 50€ einnehmen (und damit die Serverkosten begleichen können), stieße man auf Unverständnis.

Man kann sicher auf den ersten Fall gespannt sein in dem das Hamburger Landgericht einem Geflügelfürsten bestätigt, dass der Koch-Blog ichrühreeier.de einen Erwerbszweck verfolgt, da der Blogger einen Mehrwert aus zugesannten Rezeptbüchern hat, die er üblicherweise rezensiert. Was macht das Finanzamt dann?

Soll das Web wieder ein Walled Garden werden?

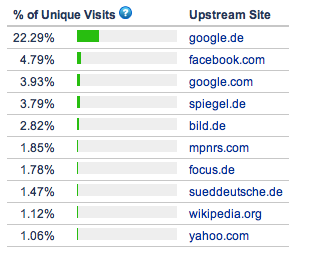

Vor allen praktischen Aspekten eines schlecht ausgearbeiteten Entwurfs muss man sich jedoch fragen, wie die Verlage auf diese bekloppte Idee kommen? Selbst wenn es nur auf Google abzielt (und nicht auch noch auf facebook und twitter) und Google sich breitschlagen lassen sollte, für die News-Schnipsel zu zahlen dürften die Einnahmen der Publisher erheblich sinken. Google dürfte zukünftig dafür sorgen, dass weniger Nutzer zu Axel Springer gehen.

Und nicht nur Google selbst dürfte durch Änderung seines Ranking-Mechanismus aktiv dafür sorgen. Die Nutzer selbst werden dafür sorgen, dass der Pagerank von zum Beispiel welt.de (PR: 8 ) oder bild.de (PR: 7) sinkt. Wer sollte dann noch auf Artikel dort verlinken, wenn er dafür abgemahnt werden kann?

Laut Alexa sind mehr als 30% der Welt.de-Nutzer zuvor auf einer Suchmaschine oder facebook. Selbst bei vorsichtiger Schätzung dürften von den 42.198.106 Besuchern im Mai 2012 mindestens 8 Mio über Suchanfragen oder soziale Links auf die Seite kommen. Die würden schon mittelfristig wegfallen. Der langfristige Effekt dürfte sich noch viel stärker auswirken.

Vor dem Hintergrund der aktuellen Meldungen, dass mehr und mehr Verlagshäuser eine Paywall einrichten wollen (Madsack, FAZ, NZZ) könnte man meinen, dass das Web auf den Stand von BTX und Compuserve zurück gebracht werden soll. Inhalte sollen nur von einem begrenzten Kreis kommen und die Nutzer sollen Konsumenten bleiben.

Konsequenterweise wird der sehr schöne Artikel von Constanze Kurz in der FAZ über eine Zukunftsversion mit Leistungsschutzrecht nicht verlinkt. Man möge einfach bei Google nach “constanze kurz faz” googeln.

1) Der Film EPIC 2015 ist eine Zukunftsversion aus dem letzten Jahrhundert. Unter anderem darin Verleger, die gegen Google wg. der Verwendung von Snippets klagen. Am Ende liefern die Nutzer selbst die Inhalte und werden direkt vergütet.

Do-Not-Track-Hick-Hack um IE10

Nach der Ankündigung von Microsoft seinen Internet Explorer 10 mit gesetztem Do-Not-Track-Schalter auszuliefern hatte Firefox ja schon erhebliche Erklärungsprobleme. Für die meisten Nutzer ist nicht einsehbar, warum der einzige freie Browser sich dem Diktat von Werbefirmen beugt. Bei den Summen, die von Google an die Mozilla-Foundation fliessen ist das allerdings nicht verwunderlich.

Inzwischen wird von den interessierten Kreisen massiver Druck auf Microsoft ausgeübt. Die zuletzt geladene und scharf gemachte Waffe sieht so aus:

Niemand muss sich an die DNT-Information eines IE10 halten, da sich dieser Browser nicht standardkonform verhält.

Derzeit gibt es zwar noch keinen verabschiedeten Standard sondern nur einen gemeinsam verabschiedeten Vorschlag. Dieser sieht jedoch vor, dass der Nutzer seinem expliziten Willen Ausdruck verliehen haben muss, wenn der Browser DNT=1 sendet also jedem Server mitteilt, dass er nicht getrackt werden will.

Es wird also implizit davon ausgegangen, dass User prinzipiell getrackt werden möchten und nur wenige (weniger als die Hälfte) sich dagegen entscheiden. Es handelt sich also um ein OptOut.

Dieses Vorgehen wurde gestern bei einer Telefonkonferenz nochmal abgestimmt. Das Ergebnis kann man sich hier ansehen. Offensichtlich wurde Browserherstellern, die von der Linie abweichen während des Termins sogar mit einer Untersuchung durch die FTC gedroht.

Nach meiner Meinung haben sich die an dem Gremium beteiligten Datenschutzorganisationen (darunter der eff) über den Tisch ziehen lassen (“extraordinarily painful cuts for privacy-leaning stakeholders”). Ich bin gespannt, wie sich z.B. die Electronic Frontier Foundation zu dem aktuellen Stand äussern (noch ist dazu nichts auf dem Blog). Denn es dürfte doch jedem klar sein, dass die Werbebranche von dem maximal dummen Nutzer ausgeht der zu blöd ist, die Einstellungen zu öffnen und das Häkchen zu setzen.

facebook, #Schufa, Scoring und Social Media Reputation

Die Schufa untersucht mit Unterstützung des Hasso-Plattner-Instituts, ob Informationen aus sozialen Netzwerken relevante Daten für die Kreditausfallbewertung zu finden sind. Nach Personalchefs und der Polizei kommen nun also auch träge deutsche Firmen auf die Idee, ihre Datenqualität zu verbessern. Das ist nicht verwunderlich und sehr lange prophezeit z.B. für Krankenversicherungen.

Der wirklich interessante Punkt daran ist die Tatsache, dass Kreditscoring vergleichbar ist mit Social Media Reputation.

Die meisten facebook-Nutzer, die man fragt geben unumwunden zu, dass sie bei neuen Freundschaftsanfragen, sich zunächst ein Bild über den facebook-Wert der Person machen (auf diesem Interesse basieren nicht umsonst etliche fb-Würmer). Wie viele Freunde, wie viele Likes haben die Posts, wer antwortet der Person? Diese Bewertung soll gewährleisten, dass sich investierte Social-Coins™ nicht als Fehlinvestition erweisen. Denn die Social-Media-Identität ist heute ein signifikanter Part der Identität. Durchaus vergleichbar mit den Schulhofpsychomechanismen bei der man durchaus gravierende Fehler machen konnte, wenn man sich mit den falschen Leuten rumgetrieben hat.

Tatsächlich könnte eine gesellschaftliche Reputation zukünftig das Scoring-System ersetzen. Sehr interessant beschrieben hat das Charles Stross in seinem Roman Accelerando.

[Update] Wie kritisch die automatische also maschinelle Bewertung von Social-Media-Inhalten in Bezug auf die Qualität der Daten zu sehen ist, schreibt goowell in seiner Diskussion mit @mspr0. Meine Erfahrungen mit Tools wie Vico Research bestätigen seine Einschätzung. Der Informationsgehalt von SM-Inhalten tendiert auf Grund des sehr oft fehlenden Kontextes gegen Null. [/Update]

Firefox, der Mielke unter den Browsern: Ich liebe Euch doch alle!

Man kann von Do-Not-Track halten was man mag. Aber das vorläufig letzte Argument von Mozilla dagegen, erinnert sehr stark an Erich Mielkes

Ich liebe Euch doch alle

Denn das Argument lautet: der User darf nicht mit Fragen belastet werden, die ihn überfordern und da es gängige Praxis ist, den Nutzer zu tracken ist die Default-Einstellung für Do-Not-Track=off.

Man kann nur hoffen, dass sich die entscheidenden Leute bei der Mozilla-Foundation damit endgültig disqualifiziert haben. Denn sie sagen nicht mehr und nicht weniger als dass ihre Nutzer dumm sind und lieber ungestört surfen möchten als von nervigen Abfragen gestört zu werden.

Dabei ist Firefox erstens genau der Browser, der permanent durch störende, vollkommen belanglose Dialoge auffällt, die man eben nicht verhindern kann und zweitens ist es genau der Browser, der dafür bekannt ist, dass er wichtige Einstellungen an vollkommen abstrusen Orten versteckt.

Welche Probleme die Mozilla Foundation mit dem Thema Privacy hat wird schnell deutlich, wenn man sich den Mozilla Privacy Blog ansieht. Von den letzten zehn Artikeln seit Ende letzten Jahres handeln acht direkt von DNT. Viele sogar davon, dass die ursprünglich von Mozilla selbst kommende Idee eine immer breitere Anhängerschaft finden. Und trotz unauffindlicher Einstellung haben 7% der Nutzer die Option eingeschaltet. Tatsächlich dürften ja gerade die verfügbaren Privacy-Erweiterungen für den Browser ein wesentliches Argument für dessen Beliebtheit sein.

Um so mehr verwundert es, dass der IE 10 den Firefox jetzt rechts überholen kann. Denn Microsoft hat heute bekannt gegeben, dass der Browser zukünftig die Option per default gesetzt hat.

Und Mozilla? Der Vorreiter für Privatsphäre redet sich mit Usability raus. Denn – man halte sich fest:

ultimately it’s not the browser being tracked, it’s the user

Dem hätte doch immerhin selbst Microsoft in der W3C Tracking Protection Group zugestimmt. Eine Vorwegnahme der Wünsche durch eine Default-Einstellung würde der Idee widersprechen, dass nicht dem “not the preference of some institutional or network-imposed mechanism” Ausdruck verliehen würde. Man müsste quasi von einem Eingriff in die Netzneutralität sprechen.

Damit wären wir genau wieder bei dem mutmaßlichen Interesse eines durchschnittlich informierten Nutzers, den der D64 in seiner Charta aus dem Hut zaubert. Was meinen die alle? Den DAU?

Ein für alle Mal:

DER DURCHSCHNITTLICH INFORMIERTE BENUTZER HAT KEINEN BLASSEN SCHIMMER, WELCHE DATEN ÜBER SEIN VERHALTEN VON WEM GESAMMELT WERDEN. UND WENN MAN ES IHM SAGT, FRAGT ER SOFORT, WO DER BUTTON IST, DAS ZU VERHINDERN!!11EINSELF

ps: Google (die Firma mit dem einzigen verbreiteten Browser gänzlich ohne Do-Not-Track-Option) steuert übrigens 85% der Einnahmen der Mozilla-Foundation bei.

20 Euro für die #klehranlage

Das als Pressekammer bezeichnete Landgericht 24 in Hamburg fungiert inzwischen als das genaue Gegenteil. Sie legt an Aussagen von Zeitungen, Journalisten und Bloggern teils höhere Ansprüche als ein Richter in Bezug auf prozessrelevante Materialien. Man könnte in einem Prozess andernorts durchaus einen Beitrag aus der ARD abspielen, um eine Masche eines Betrügers zu belegen (und würde damit Erfolg haben). Und zur gleichen Zeit, würde der ARD in Hamburg der Beitrag unter dem Hintern weggeklagt werden.

Viele Entscheidungen dieses Gerichtes wurden inzwischen von höheren Instanzen kassiert. Jetzt geht es um einen weiteren Fall und 20,00 € werden sofort von mir überwiesen.