Das Märchen vom Todesstoß für die Online-Werbebranche

tl;dr Die Behauptung der Online-Werbeindustrie, ein starker Schutz der Privatsphäre würde die Branche vernichten, ist offensichtlicher Unsinn. Die Werbeausgaben würden weiterhin in gleicher Höhe fliessen. Nur eben in andere Formen, Techniken und/oder Medien.

Die Diskussion um Do Not Track hat inzwischen bizarre Züge angenommen. Die Werbeindustrie bezeichnet ihre Tätigkeit als Teil der Zivilgesellschaft und DNT müsse diese respektieren. Für Ed Bott von ZDnet ist die Message klar: Eine konsequente Umsetzung von DNT wäre unamerikanisch.

Das Menetekel, das unter anderem von der Direct Marketing Association (DMA) prophezeit wird, sagt das Ende einer ganzen Branche voraus. Falls Do Not Track bei einem – oder sogar im Standard selbst – verbreiteten Browser per default eingeschaltet wäre, würde die Arbeitsgrundlage der Targeter und des verhaltensbasierten Werbens entzogen, Arbeitsplätze würden abgebaut und Amerika verlöre die Führungsposition in einer Zukunftsindustrie.

Aber: Würden tatsächlich weniger Mittel in Online-Werbung fliessen?

Im letzten Jahr wurde in Deutschland knapp 30 Mrd. Euro für Werbung ausgegeben. Den Löwenanteil (ca. 3/4) davon erhielten TV, Radio, Print und Aussenwerbung. Nur schätzungsweise ein Viertel flossen in Online- oder Direktmarketing. D.h. 75% der Werbekunden geben ihr Geld für Massnahmen aus, die keinerlei qualifiziertes Targeting gestatten. Von Retargeting ganz zu schweigen.

Die Mediaplanung für die genannten Werbeformen basiert auf vollkommen fantastischen Angaben zu einer vermeintlichen Reichweite. Die Zahlen zur Reichweite wird für alle Medien unterschiedlich erhoben. Die Einschaltquoten von Radios werden mit Telefonumfragen auf Festnetznummern erhoben, bei den Zeitungen und Zeitschriften wird die Abnahme des Großhandels zu Grunde gelegt, offensichtlich ohne dabei zum Beispiel bei Zeitungen die Remittenden einzubeziehen. Und für das Fernsehen werden “durchschnittliche” Haushalte mit identischen Geräten ausgestattet, die Probanden bekommen eine Schulung und sollen beim Gang auf die Toilette eine besondere Taste drücken. Diese Erhebungsmethode ist so dermaßen absurd, dass man sich immer wieder an die Stirn fassen muss, wenn man hört, dass irgendeine Sendung Einschaltrekorde erzielt hat. Weit verbreitete Festplattenrekorder, Timeshift oder parallele Online-/TV-Nutzung spiegeln sich in den erhobenen Zahlen nicht wieder.

Aber trotzdem geben Markenhersteller jedes Jahr Milliarden für eine Kommunikationsform aus, deren Wirkung sie nur sehr, sehr indirekt messen kann. Steuern kann sie auf der Basis der vorliegenden Zahlen überhaupt nicht. Im besten Fall kann beispielsweise Beiersdorf sehen, ob die Einführung eines neuen Nivea-Produkts erfolgreich war. Falls die Verkaufzahlen hinter den Erwartungen bleiben könnte man mal eine Umfrage machen, ob die Kommunikation auch bei der Zielgruppe angeschlagen hat.

Tatsächlich dürfte Targeting sogar Arbeitsplätze vernichten. Es verspricht eine höhere Responserate als klassische Werbung und dies sogar ohne die leidige und ungenaue Mediaplanung. Was bisher eine Agentur leistete, übernehmen nun Automaten und die Nutzer selbst. Sieht man sich den Verlauf der Werbeinvestitionen in den letzten Jahren an, wird deutlich, dass sich das Volumen nur unwesentlich verändert hat. In den Krisenjahren 2001 und 2009 sind sie signifikant eingebrochen, nun aber wieder auf dem selben Niveau.

Das ist umso erstaunlicher, da in den letzten zehn Jahren das Volumen für Online-Werbung von nahe null auf fast eine Milliarde gestiegen ist. D.h. die Werbetreibenden haben lediglich den Mediamix verändert. Inzwischen werden durchschnittlich 5% des verfügbaren Budgets für Online-Werbung ausgegeben. Davon ist nur ein Teil tatsächlich Privacy-relevant. Die meisten Banner auf den großen Portalen werden nicht zielgerichtet ausgespielt. Der Ad-Server überprüft in vielen Fällen nur, ob ein Nutzer das Werbemittel bereits gesehen hat. Dies liesse sich auch ohne Tracking bewerkstelligen.

Das Volumen der Werbeinvestitionen sind mit hoher Wahrscheinlichkeit vollkommen unabhängig von den verwendeten Techniken. Tatsächlich dürfte sich sogar die Effizienz auf längere Sicht angleichen, denn schon jetzt ist absehbar, dass sich auch beim Targeting eine Resistenz der Nutzer ausbildet. (Abgesehen davon kann die Targeting-Branche nicht einmal ihre Versprechen einlösen und wirklich relevante Angebote machen.)

Und letztlich würde ein Opt-In für Tracking sogar den klassischen Reichweitenmessungen entsprechen. Denn sowohl Telefonumfrage als auch GFK-TV-Messung basieren auf der freiwilligen Teilnahme weniger.

[Update] John Gruber (daringfireball.net) argumentiert grade bezüglich der Reichweitenmessung genauso. [/Update]

[Update] Einen extrem lesenswerten Artikel eines Insiders zu dem Thema mit viel Salz in die offene Wunde der Mediaplaner schrieb Thomas Koch (twitter: @ufomedia). [/Update]

Do Not Track: Chronik eines angekündigten Todes

Bei ZDNet ist ein schöner Rant über das Verhalten der Ad-Betreiber im Prozess der Standardentwicklung von Do Not Track erschienen. Ed Bott vergleicht darin den Ablauf als phantastischer als Alice im Wunderland. Er fragt sich, ob DNT aktuell eher mit 1984 oder mit Brazil vergleichbar ist. Auf der Mailingliste des W3C fand sich die Schlussfolgerung, dass Marketing eine Säule der US-Gesellschaft ist und jeder, der dort Sand ins Getriebe streut, müsse ja wohl Kommunist sein – folgert Ed Bott.

Aus meiner Sicht, war Do Not Track von Anfang an Schwachsinn. Allerdings war mir vor eineinhalb Jahren noch nicht klar, welchen Spin das ganze noch nehmen würde. Im Kern läuft es inzwischen darauf hinaus, dass die Werbebranche offen zugibt, dass sie mit der Dummheit/Faulheit der User rechnet. Und nur, wenn dieser Faktor auch im Standard festgeschrieben wird, ist sie bereit sich dem Diktum zu beugen.

Die Kernfrage lautet: Muss der Nutzer aktiv sagen, dass er nicht getrackt werden möchte (Opt-Out)? Oder sind prinzipiell auch Systeme standardkonform, die dem Nutzer diese Entscheidung abnehmen und das Tracking-Flag ohne Frage setzen (Opt-In).

An dieser Frage scheiden sich nicht nur die Geister – auf der einen Seite die Ad-Betreiber und von dieser abhängige Firmen und auf der anderen Seite z.B. Microsoft, das den Datenschutz als Verkaufsargument entdeckt hat. Bei dem Versuch einen Kompromiss zu finden, werden auch Institutionen wie das W3C und selbst die Apache-Foundation beschädigt.

Alles in allem gibt es allerdings schon heute Fakten. Wenn ein Nutzer heute bei seinem Explorer, Firefox oder Safari DNT einschaltet müsste ein Site-Betreiber dies mit hoher Wahrscheinlichkeit berücksichtigen. Denn kaum ein großer Anbieter könnte sich heute damit rausreden, dass es noch keinen Standard gibt. Allein die Kenntnis über die mögliche Einstellung und damit der Intention des Nutzers dürfte als Argument vor einem – zumindest US- – Gericht genügen, einen Schadensersatz einzuklagen. Das Muster der Prozesse gegen verschiedene Tabakkonzerne könnte für eine Sammelklage ausreichen.

Aus Sicht der Publisher steht und fällt ihr Geschäft mit dem Ad-Targeting. Das dürfte einer der Gründe sein, warum wenig und wenn sehr einseitig über DNT berichtet wird. Letztes Beispiel für eine sehr eingeschränkte Sichtweise präsentierte Golem am Tag der deutschen Einheit. Der Autor Jens Ihlenfeld ist Gründer und Herausgeber von Golem.de. Für ihn wird DNT nur dann funktionieren, wenn es mittels Opt-Out umgesetzt wird. Falls es üblicherweise eingeschaltet ist, droht er, würde sich die Werbeindustrie nicht daran halten.

Ob der Standard in der aktuell verfahrenen Situation überhaupt noch verabschiedet wird ist sehr fraglich. Viel wahrscheinlicher ist eine Gesetzesinitiative des US-Congresses oder der EU-Kommission. Dann hätte die Werbeindustrie hoch gepokert und alles verloren.

[Update] Kaum geschrieben, schon wird berichtet, dass Neelie Kroes als Europa-Chef-Onlinerin das W3C darauf hinweist, dass es nicht akzeptiert wird, wenn das Standardgremium die Privatsphäre der Nutzer verwässert. Eigentlich hatte die EU dem W3C und den beteiligten Firmen aufgetragen bis Juni einen vernünftigen Entwurf vorzulegen. Auch von der FTC kommt Kritik. Laut dem Chef Jon Leibowitz würde der aktuelle Vorschlag ein Schlupfloch bieten, durch das man einen virtuellen Truck fahren lassen könne. [/Update]

iOS 6 Maps: Kollateralschäden im Kampf zwischen Apple und Google

Mit dem weltweiten Rollout von iOS 6 für die meisten iPhones, iPods und iPads am 19.9. hat sich Apple wahrscheinlich den größten Fehler in der Unternehmensgeschichte bisher geleistet. Die Firma hat sich zum Gespött der Apple-Anhänger gemacht.

iOS 6 Maps: nicht mehr als eine Fun-App

Stein des Anstoßes ist die neue Map-App. Statt der bisher verwendeten Google-Maps-Daten verwendet Apple nun die Karten und Bilder von TomTom und die Point-Of-Interests (POIs) von Yelp. Für die Suche verwendet Apple offensichtlich eine eigene Engine. Dies gilt möglicherweise auch für das Routing und den Tile-Map-Server, welcher dafür zuständig ist, Karten, Bilder und PIOs zum User zu bekommen.

Und alle diese Daten und Backends erreichen nicht annähernd die Qualität von Google Maps. Die Differenzen sind so groß, dass es nach wenigen Stunden schon diverse Twitter-Accounts und Blogs gab, die sich mit den Fehlern beschäftigen. Prominentestes Beispiel ist der tumblr-Blog “The Amazing iOS 6 Maps“. Hier werden verschiedenste Beispiele für teilweise haarsträubende Fehler protokolliert.

Apple hatte sich nach früherer Eintracht von Google abgewendet, weil es Android als zu große Gefahr für seine Produkte ansieht. Allerdings hat es dann noch mal drei Jahre gedauert bis Apple sich traute, mit einer eigenen Map-Applikation auf den Markt zu kommen. Offensichtlich hätte man jedoch noch einige Jahre ins Land gehen lassen sollen. Der erste Wurf ist offensichtlich eine Katastrophe.

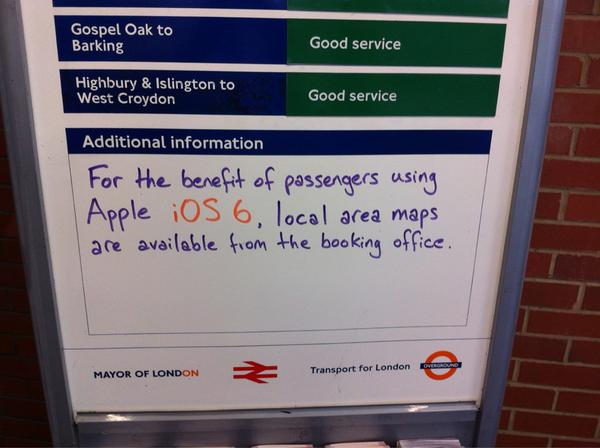

Wer den Schaden hat braucht für den Spott nicht zu sorgen. Hinweis für iOS6-Benutzer in der Londoner U-Bahn.

Vor 8 Jahren kaufte Google die Firma Keyhole. Diese war unter anderem ein Spin Off der CIA und Nvidia. Dieser Kauf war an sich schon ein politischer Akt im Spiel um die Märkte der Zukunft. Microsoft hatte kurz zuvor erste Vista-Anmutungen (alias Longhorn) gezeigt. Eines der Beispiele war eine Aero-Applikation für Makler auf der Basis von Keyhole.

Keyhole hatte zu diesem Zeitpunkt drei Jahre Erfahrungen mit Satellitenbildern und Routing. Auf der Basis dieses Know Hows hat Google inzwischen einen schier uneinholbaren Vorsprung im Segment der Map-Anwendungen. Gespeist wird dieser Vorsprung aus mehreren Quellen, die sich gegenseitig befruchten: Map-Daten (Karten, Sat-Images, POIs, …), Suchmaschinendaten (WebSite-Daten), Suchalgorithmen und Nutzerverhalten (Suchen, Live-Traffic, …).

Apple hat in jedem dieser Bereiche weder die gleiche Qualität der Daten und Algorithmen noch die entsprechenden Erfahrungen. Tatsächlich haben sie nun nicht mal mehr die Daten der Android-User. D.h. Google hat nicht nur eine bessere Startposition sondern auch eine wesentlich bessere Sprungposition.

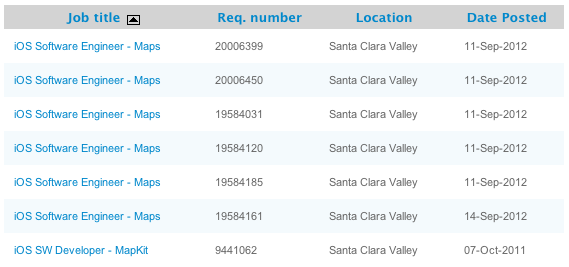

Apple sucht noch immer Map-Developer. Vielleicht lassen sich ja bei Google welche abwerben.

Vor diesem Hintergrund ist es sehr unwahrscheinlich, dass Apple zusammen mit TomTom in den nächsten Jahren auch nur in die Nähe der Qualität der Google Maps kommt. Vielleicht können Themen wie Performance noch gelöst werden. Die Erfahrung Apples mit großen Serversystemen lässt daran jedoch ernsthaft zweifeln. Die Qualität der POIs oder der Satelliten-Images wird sich nur sehr langsam verbessern lassen. Es würde nicht mal helfen, wenn die ganze Welt als “Fly Over” (interaktive 3D-Ansicht) abgebildet werden könnte, denn diese Funktion ist nicht mehr als ein nice-to-have. Im Alltag ist die korrekte Route, die nächste Tankstelle und die Stauvorhersage unverzichtbar.

Auf diese Funktionen müssen iOS-6-Nutzer jetzt verzichten. Unklar ist, ob Google eine separate Map-App für iOS rausbringen wird. Noch unklarer ist, ob Apple diese ohne weiteres in den Store lassen würde. Es wäre ein Schuldeingeständnis erster Klasse und für solche ist Apple nicht grade bekannt.

Bei Google ist der zweite Vorschlag bei der Suche nach “ios6 do” bereits “ios6 downgrade”. Bisher geht dies nur bei älteren Geräten und auch dann nur mit einem Jailbreak. Man darf also gespannt sein, wie groß der Druck der Nutzer auf Apple noch wird und wie die Firma darauf reagiert.

iOS6 mit Targeting-Schutz

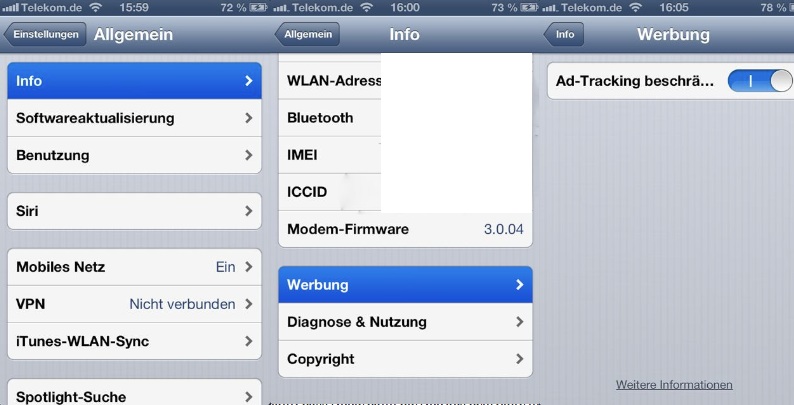

Mit der seit gestern verfügbaren Verion 6 von Apples Mobile-Betriebssystem iOS wurde eine neue Funktion zum Schutz der Privatsphäre eingeführt. An der sehr, sehr versteckten Stelle “Einstellungen > Allgemein > Info > Werbung > Ad-Tracking beschränken” kann der Nutzer zusätzlichen Schutz aktivieren. Dabei geht es um die Verwendung von eindeutigen IDs für das Targeting in In-App-Werbung.

Bis zum letzten Jahr konnten die Entwickler und damit auch die Werbenetzwerke (die von den Entwicklern benutzt wurden) uneingeschränkt auf die sogenannte UDID zugreifen. Dies ist eine einheitliche ID, die bei jedem Gerät unterschiedlich ist. Danach hat eine Systemfunktion für jede App eine separate ID generiert, die sich bis zum Löschen der App nicht geändert hat. Werbetreibende konnten mit dieser Lösung gut leben, obwohl ihnen die App-übergreifende Verknüpfung der Profile verwehrt war.

iOS 6 mit besserem aber sehr verstecktem Schutz der Privatsphäre.

Mit der aktivierten Einstellung wird nun bei jedem Aufruf der App eine neue ID generiert. Diesen Daten können die Werbenetzwerke nun sehr schwer ein qualifiziertes Profil zuordnen. Ausgeschlossen ist dies jedoch nicht, erfordert jedoch auch die aktive Unterstützung des Entwicklers. Der läuft damit aber auch Gefahr, dass Apple dann die App aus dem Store nimmt.

Mit Do-Not-Track oder einem Tracking-Opt-Out bei den großen Werbenetzwerken hat die Einstellung entgegen anderen Meldungen übrigens nichts zu tun. Weder das Verhalten des Safari selbst noch das des WebKit-View in Applikationen verändert sich durch das Setzen der Option.

Das vermeintliche Ende der Netzneutralität

Letztens saß ich nichts ahnend in meinem Wohnzimmer unweit des Epizentrums der Berliner Filterbubble und plötzlich kehrte der Elektrische Reporter ein. Nach kurzem Abgleich der gegenseitigen Filterkriterien landeten wir schnell bei dem nächsten großen Thema der Netzerregung: NETZNEUTRALITÄT!

Sixtus, die metaebene und viele andere (http://www.spiegel.de/thema/netzneutralitaet/archiv.html) hatten das Thema schon länger auf dem Radar. Vor einiger Zeit ging es noch darum, dass die Telekoms der Welt bestimmte Dienste in ihren Netzen mindestens behindern wenn nicht sogar komplett gesperrt haben. Zumindest jedoch die Benutzung per AGBs verbieten.

Inzwischen kommt das Ende des Netzes, wie wir es kennen mit großen Schritten näher. Auslöser war die Ankündigung der Telekom über eine Partnerschaft mit Spotify. Zukünftig wird (bei Buchung eines Zusatzpaketes) das “Flatrate”-Volumen nicht mehr belastet, wenn man den Musikdienst Spotify benutzt. Der Chor der Kritiker sieht damit die Tür zu einer Welt geöffnet in der nur eine limitierte Anzahl Diensteanbieter einen Vorzugsservice durch die Provider geniessen. Der Nutzer schliddere auf der Gleitcreme eines vermeintlichen USPs gradewegs in einen neuen Walled Garden.

Interessant daran ist, dass der Aufschrei eigentlich schon vor zwei Jahren hätte durch das Netz schallen müssen. Damals hatte facebook und E-Plus bekanntgegeben, dass der Aufruf über die Adresse 0.facebook.com aus dem E-Plus-Netz kostenlos ist. Noch früher gab es bereits sogenannte “Mobile Enabler”. Diese bieten sehr erfolgreich Mobilfunkverträge von allen Netzen als White-Label-Pakete an. Bild-Mobile und Hertha verkaufen diese dann gebrandet und auch dort können die Nutzer bestimmte Angebote kostenlos nutzen. Solche Angebote gibt es sogar komplett verkrüppelt. Online kann man nur ein einziges Angebot nutzen, für den Rest des Netzes gibt es keine Netzverbindung.

Es zeichnet sich ab, dass zukünftig Netz nicht mehr Netz ist. Mehr oder weniger jedes Online-Paket wird spezifische “Vorteile” haben, die man nur als Restriktion begreifen kann.

Alles schon mal dagewesen:

Es empfiehlt sich jedoch ein Blick in die Vergangenheit. Auf dem steinigen Weg von BTX zu einem allgemein verfügbaren IP-Netz waren bei Compuserve, der Deutschen Post und AOL schon immer bestimmte Dienste frei verfügbar, andere wurden nicht auf das Datenvolumen angerechnet und andere eben geblockt. Selbst bestimmte IP-Dienste wurden im Laufe der Zeit entweder beschnitten (z.B. nntp oder irc) oder bevorzugt (z.B. WSJ.com bei Compuserve) behandelt.

Die Entwicklung, die sich jetzt abzeichnet ist relativ klar. Die Provider begreifen, dass das Netz zukünftig ein Service ist, der Standard ist. In absehbarer Zeit werden die Kunden die Differenzierung zwischen Telefon- und Online-Funktion nicht mehr mittragen. Schon heute dürfte etliche Kunden nach zwei Stunden wieder im Laden stehen und fragen “Wie komme ich denn jetzt auf Bild.de?”. Die Antwort “Sie hätten ein Online-Paket dazubuchen müssen.” dürfte nur noch wenige Jahre hingenommen werden.

Die Provider sind bereits in einem Rückzugsgefecht. Sie mögen vielleicht heute noch nicht begreifen, dass sie lediglich Rohrleger und -vermieter sind. Die aktuelle Entwicklung deutet aber darauf hin, dass sie es spüren und noch abschöpfen möchten, was noch geht.

Apache Do-Not-Track-Bug fixen

Seit der Version 2.4.3 behandelt der Apache den Internet Explorer 10 gesondert: in der globalen Konfiguration ist nun festgelegt, dass bei diesem Browser der Header für Do Not Track gelöscht wird. Dies geschieht sogar unabhängig von der mit DNT bezeichneten Requestinformation belegten Wert. Für alle nachfolgenden Prozesse oder virtuellen Konfigurationen gibt es dadurch keine Möglichkeit mehr, zu ermitteln welche Einstellung der Nutzer des IE 10 gesetzt hatte.

Für jeden Systemadministrator ergibt sich daher nun nach einem Update die Frage “Wie gehe ich damit um?”.

Letztlich kann man als Betreiber einer Seite danach nicht mehr ausschliessen, dass mindestens ein Nutzer im vollen Besitz seiner geistigen Kräfte seinem Explorer gesagt hat: “Bitte informiere den/alle Server darüber, dass ich nicht getrackt werden möchte.”

Belässt man es als Administrator dann jedoch dabei, geht man ohne Frage ein rechtliches Risiko ein. Immerhin hat die Serverkonfiguration die Kommunikation modifiziert und damit die Intention des Nutzers mindestens fahrlässig ignoriert, wenn nicht sogar vorsätzlich sabotiert.

Falls man keinen Zugriff auf die globale Konfiguration des Web-Servers hat – wie beispielsweise bei den meisten Billighostern – muss man entweder in der Virtual-Host-Konfiguration oder in der .htaccess folgende Zeilen eintragen.

<IfModule headers_module>

RequestHeader set DNT 1 env=bad_DNT

</IfModule>

Damit wird der DNT-Header für alle Requests gesetzt bei denen durch die globale Konfiguration die Environment-Variabel “bad_DNT” gesetzt wurde. Dieses Vorgehen empfiehlt sich nicht nur, wenn man keinen Zugriff auf die globale Konfiguration hat sondern z.B. auch automatische Updates für den Apache einspielen lässt. Dann diese Überschreiben eigene Änderungen jedes mal.

Übrigens: Man sollte natürlich den Wunsch der User auch Rechnung tragen. Der Apache wird durch das Anfügen von “ env=!HTTP_DNT” an die CustomLog-Zeile dazu angehalten, alle Requests nicht in das Logfile zu schreiben. Das ist nicht nur eine nette Geste.

Können Algorithmen die Basis für autopoietische Systeme sein?

Jessas! Nicht Algorithmen “werten”, sondern ihre Programmierer. P[rogrammierer] ist mit A[lgorithmus] eine soziotechn Einheit (weil Werkzeug), P[rogrammierer] handelt und P[rogrammierer] wertet.

— Christoph Kappes (@ChristophKappes) September 9, 2012

@christophkappes @kathrinpassig Das ist mechanistische Sichtweise. Wenn P[rogrammierer] ein autopoietisches System entwickelt, kann P[rogrammierer] nicht mehr werten.

— Rene Meissner (@qrios) September 10, 2012

Darauf entspann sich zwischen mir und @kathrinpassig eine Diskussion über die Praxisrelevanz meiner Aussage. Mein Verweis auf neuronale Netze und genetische Algorithmen waren ihr wohl noch zu akademisch. Daher verwies ich auf MapReduce:

@kathrinpassig @christophkappes MapReduce erfüllt in der Praxis auch die Anforderung dass P nicht 100% der Ergebnisse kennen kann.

— Rene Meissner (@qrios) September 10, 2012

Tatsächlich habe ich nahezu täglich mit diesem Effekt zu tun. Bei der WebAnalyse und dem Social-Media-Monitoring für größere Auftraggeber werden unter anderem Google Analytics oder facebook Insights eingesetzt. Beide verwenden MapReduce und tun dies auf der Basis von Stichproben. Alltägliche Erfahrung ist, dass zu unterschiedlichen Zeiten die Ergebnisse für den gleichen Zeitraum unterschiedlich sind.

Grade bei zeitnahen Abfragen werden Stichproben verwendet. Da MapReduce in großen Systemen wie Google und fb asynchron läuft hängt das Ergebnis unter anderem davon ab, welcher Server grade Zeit hat und daher verwendet wird. Dadurch werden bei zwei aufeinanderfolgenden Abfragen möglicherweise vollkommen andere Datensätze verwendet. Wie solche Systeme trotz der Abweichungen valide Daten liefern können beschreibt zum Beispiel die Arbeit “Early Accurate Results for Advanced Analytics on MapReduce“.

Als Programmierer könnte ich daher trotz Kenntnis über alle eingehenden Daten nicht vorhersagen, welche Ergebnisse “mein” Algorithmus liefern wird. Ich könnte lediglich eine Aussage darüber treffen, welche Werte minimal und welche maximal berechnet würden und welche Werte am wahrscheinlichsten sind.

Eine solche Unbestimmtheit würde sich noch fortpflanzen, wenn das Ergebnis – zum Beispiel in einem Mashup-System – selbst wieder zum Input für ein selbstorganisierendes System würde.

Der Programmierer spielt in einem solchen Setup kaum noch eine Rolle. Schon gar nicht wertet er. Einen spürbaren Einfluss auf das Ergebnis hat sicher noch derjenige, der bestimmte Parameter wie die Stichprobengröße oder die Anzahl der verteilten Prozesse festlegt. Allerdings sind auch diese meistens variabel. Denn sie sollten sich möglichst optimal auf Geschwindigkeit, Genauigkeit und Stromverbrauch einpegeln.

Wenn der Programmierer nicht wertet, wertet denn dann der Algorithmus? Eigentlich nicht. Ebenso wenig, wie das einzelne Neuron in unserem Gehirn rechnet, aber das Gehirn selbst rechnen kann. Vielmehr ist es der Systemzustand selbst, der über das Ergebnis entscheidet. Der gleiche Algorithmus (vom gleichen Programmierer) kommt bei gleichen Daten und bei gleicher Systemarchitektur zu unterschiedlichen Zeiten zu einem unterschiedlichen Ergebnis.

Wobei bereits die Bezeichnung “gleiche Systemarchitektur” ungenau ist. Betrachtet man mehrere Server in einem Rechenzentrum, so kommunizieren die darauf laufenden Services über TCP/IP welches seinerseits meistens über Ethernet läuft. Dieses Protokoll verwendet aber eine auf Zufallszahlen basierende Kollisionsvermeidung. Würden zwei Server bei einer verteilten MapReduce-Anwendung die Ergebnisse gleichzeitig abliefern wollen, würden die Nachrichten kollidieren. Beide würden es nach zufällig langer Pause wieder probieren. Fehlt dem Server zum Zeitpunkt der Kollision nur noch ein Ergebnis für seine Stichprobe würde er nur noch eines nehmen, das andere Ergebnis würde verworfen. Das Ergebnis hängt also tatsächlich von den Zufallsalgorithmen zweier Netzwerkkarten ab. Und die Ergebnisse der Zufallsalgorithmen können wiederum von nahezu beliebig vielen anderen Faktoren abhängen.

Letztlich sind demnach schon heute Algorithmen die Basis für autopoietische Systeme. Nicht nur bei neuronalen Netzen oder genetischen Algorithmen sondern bei jeder Cloud um die Ecke.

Apache wird Spielball der Do-Not-Track-Gegner

Der freie Web-Server Apache ist eine der Erfolgsgeschichten der Open-Source-Bewegung. Fast die Hälfte aller Web-Sites werden mit dem Apache betrieben. Er ist mächtig, relativ leicht zu warten und wurde quasi auf jedes neue Betriebssystem portiert.

Nun allerdings wird die Freude an diesem Stück Software durch einen Vorfall getrübt, den man als Sündenfall bezeichnen muss. Zehn Zeilen Code eines Patches bringen die Software plötzlich ins Zentrum des Gefechtsfeldes zwischen Userinteressen und den Interessen der Onlinewerbeindustrie.

Vor einem Monat pflegte Roy T. Fielding, seines Zeichens Projektmanager von Apache, eine kleine Änderung der globalen Konfigurationsdatei ein. Diese Änderung wurde bereits kurze Zeit später tatsächlich ausgeliefert. Niemand hat sich daran gestossen. Bis jemandem mal auffiel, was dort drin steht:

Zuerst wird folgende Anweisung gegeben: BrowserMatch “MSIE 10.0;” bad_DNT. Diese besagt in etwa “wenn der aufrufende Browser ein Internet Explorer 10.0 ist, dann setze bitte die Variable “böses DNT”. DNT ist die Abkürzung für Do Not Track.

Das allein wäre noch akzeptabel. Programme im weiteren Verlauf könnten besondere Rücksicht darauf nehmen und würden sich so weitere Abfragen sparen. Aber danach folgt noch die Anweisung: RequestHeader unset DNT env=bad_DNT. Dadurch wird der Server angewiesen, einen eventuell vorhanden http-Header namens “DNT” zu löschen. Und dies sogar unabhängig davon, welchen Wert er hat.

Mit dem Header DNT=1 soll der Browser laut zukünftiger Spezifikation dem Server, mithin dem Betreiber der Web-Site mitteilen, dass der Nutzer nicht getrackt werden will. DNT=0 bedeutet “die Daten dürfen gespeichert und weiterverarbeitet werden”.

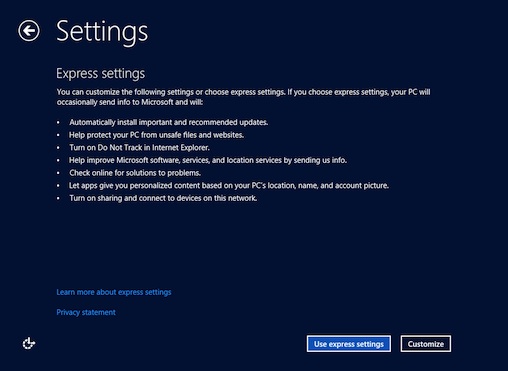

Unter Punkt 3 wird der Nutzer bei der Windows-8-Installation darüber informiert, dass das DNT-Flag gesetzt ist. Der User kann die Einstellungen jedoch anpassen.

Der Autor des Patches argumentiert, dass Microsoft sich nicht an die Spezifikation halten würde. Denn dann müsste das Einschalten von DNT eine aktive Aktion erfordern (eine Diskussion, die schon seit Monaten brodelt). Mindestens jedoch bei der Expressinstallation würde der Wert für DNT auf 1 gesetzt ohne den Nutzer zu fragen.

Dabei sind folgende Dinge interessant:

- Die Spezifikation ist noch nicht verabschiedet.

- Es ist sehr umstritten, ob Microsoft sich nicht an den Entwurf hält. Eine Formulierung nach der der Wert nicht per default gesetzt werden darf war zwar in früheren Versionen zu finden, in der aktuellen ist er nicht mehr drin.

- Apache hat sich bisher nicht als Werkzeug verstanden, Standards durchzusetzen. Vielmehr war Apache immer sehr gut darin, mit Browsern umzugehen, die sich nicht standardkonform verhielten. (Zu denen in der Vergangenheit häufig der Internet Explorer gehörte.)

- Das globale Löschen des Headers macht es nachfolgenden Programmen unmöglich, eine eigene Behandlungsroutine für einen vermeintlich nicht standardkonformen Wert zu implementieren. Man müsste wiederum eine Abfrage nach dem Browser gestalten und dann den Header DNT wieder setzen mit dem Wert “unknown”

Vor dem Hintergrund dieser Punkte ist es nicht verwunderlich, dass eine breitere Öffentlichkeit auf den Patch aufmerksam wurde. Seit vier Tagen ergiesst sich nun ein (gemäßigter) Shitstorm über Fielding. Insbesondere seine Beziehungen zu Adobe werden dabei als Indiz genommen, dass er nicht im Interesse der Apache-Comunity handelt sondern sich und damit auch Apache zum Büttel der Werbeindustrie gemacht hat.

Fielding äusserte sich bisher zwei mal in den inzwischen über hundert Kommentaren zu dem Patch. Er verweist dabei unter anderem auf die bestehende EU-Richtlinie. Laut seiner Aussage würden diese durch DNT im generellen und durch den Patch im besonderen nicht tangiert. Das ist jedoch sehr zweifelhaft. Denn, wenn ein Betreiber eines Systems Kenntnis von dem ausdrücklichen Willen des Users hat, nicht getrackt zu werden wäre die Cookie-Frage obsolet. Und kein Betreiber kann sich heute mehr hinstellen und sagen, er hätte noch nie etwas von Do Not Track gehört.

Darüber hinaus wäre die Frage, ob ein solches Verhalten eines Web-Servers nicht selbst schon Computersabotage ist. Denn laut StGB § 303b macht sich strafbar:

Wer eine Datenverarbeitung, die für einen anderen von wesentlicher Bedeutung ist, dadurch erheblich stört, dass er (3.) eine Datenverarbeitungsanlage oder einen Datenträger zerstört, beschädigt, unbrauchbar macht, beseitigt oder verändert, …

Es ist weitgehend unstrittig, dass die meisten Nutzer das Tracking in der heute verbreiteten Form ablehnen. Ausserdem gilt es als gesichert, dass die meisten Menschen – aus welchen Gründen auch immer – Standardeinstellungen eines Browsers nicht ändern. Da aktuell eine ganze Branche von sehr kostengünstig zu erhaltenden Daten lebt, gibt es daher auch ein starkes Interesse, dass zukünftig nicht lauter Nutzer mit einem Betriebssystem (Windows 8) und einem Browser (IE10+) unterwegs sind, der jedem Web-Server in der Welt mitteilt: Ich möchte nicht getrackt werden!

Ginge man von einem Windows-8-Marktteil von 50% in drei Jahren aus und einem Anteil von 50% Explorer-Nutzer, dann reden wir von 25% Browseranteil. Bei 10% Nutzern, die die Einstellungen ändern, würde eine Standardeinstellung je nach Wert bedeuten, dass entweder 2,25% oder 22,5% nicht erfasst werden dürfen. Ersteres fiele unter statistische Abweichung, letzteres würde knapp ein Viertel des Retargeting-Umsatzes ausmachen, der allein in Deutschland irgendwo zwischen 100 und 300 Mio € jährlich liegen dürfte.

Mehrere $100 Mio jährlich weltweit sind es offensichtlich schon wert, einen Dummen zu suchen, der seinen guten Ruf und den eines erfolgreichen Open-Source-Projekts aufs Spiel setzt.

Disclaimer: Ich selbst halte Do Not Track nicht für den richtigen Ansatz. Denn letztlich kann niemand wirklich kontrollieren ob sich Anbieter daran halten. Ich selbst würde eine Opt-In-Lösung für den einzig richtigen Weg halten. Dabei könnten User belohnt werden, wenn sie ihre Daten zur Verfügung stellen.

Klickbetrug durch Bots bei facebook? [Update]

Die – mir bis dato unbekannte – Firma Limited Run hat einen Artikel auf ihrem Blog veröffentlicht in dem sie facebook indirekt Click Fraud und Erpressung* vorwerfen. Offensichtlich sind 80% der User, die über facebook-Ads auf den Service limitedrun.com kommen keine realen Nutzer sondern eigentlich Bots respektive Spider oder Crawler.

Sie waren in der Analyse ihrer Nutzer darüber gestolpert, dass ihr Analytics-Tool signifikant weniger Nutzer zeigte als die Abrechnung der facebook-Ads. Nach ein wenig Research und Coding stellten sie fest, dass erstaunlicherweise ~80% der Aufrufe die als Referer die fb-Ads angaben kein JavaScript aktiviert hatten. Ihre Erfahrung lautete aber, dass der Anteil der Nutzer mit abgeschaltetem JavaScript im unteren einstelligen Prozentbereich liegt. Das deckt sich mit meinen Erfahrungen.

Limited Run hat also 4/5 ihres Budgets für Automaten ausgegeben. Nicht unbedingt die Kernzielgruppe einer Musikplattform.

Die Frage ist also: Wer veranlasst diese Aufrufe?

1. Limited Run wollte mit dem Artikel lediglich Aufmerksamkeit erzeugen. Und/Oder Limited Run hat keine Ahnung.

2. facebook selbst hätte vordergründig ein Intresse daran. Immerhin bekommen sie Geld für die Klicks. Allerdings bekommen die das Geld ja sowieso. Sie hätten allerdings ein sehr hohes Interesse die Klickrate ihrer Werbung hochzuschrauben. Denn die ist im Vergleich mit der von Google eine Katastrophe und lässt Kunden (siehe GM) und Analysten gleichermassen zweifeln, ob facebook überhaupt eine verwertbare Plattform ist.

3. Viren-Scanner sind bekannt für ihren fahrlässigen Umgang mit Daten in Browser, Mails und Messengern. Sie schreiben gerne ihren Code in HTML-Seiten und machen Preloads um mögliche Gefährdungen vom User fernzuhalten. Allerdings würde ein Preload mit einem Blacklist-Abgleich überhaupt nichts bringen wenn die kompromittierende Webseite das fehlende JavaScript feststellen könnte und so den Aufruf als Bot identifizieren könnte.

4. Ein Konkurrent oder jemand, der Limited Run irgendwie anders schaden will schädigt die Firma durch kostenpflichtige Klicks und verhindert dadurch gleichzeitig, dass relevante User auf die Seite geführt werden. Mit Hilfe eines Botnetzes sind solche Angriffe heutzutage kein Problem. Und für Limited Run, ein Startup mit begrenzten Ressourcen wäre der Schaden tatsächlich evident. Denn ein oberflächlicher Blick in die Auswertungen vermittelt einer solchen Firma ein vollkommen falsches Bild und kann zu strategischen Entscheidungen führen, die sich nach wenigen Monaten als fatal und lebensbedrohend rausstellen.

Basierend auf den bisher bekannten Fakten lassen sich keine Aussagen über die tatsächlichen Übeltäter treffen. Und tatsächlich wird Limited Run wohl nicht umhin kommen, konkrete Daten zu liefern. Techcrunch ist sich sicher, dass sie das tun werden. Aber das Thema fängt grade erst an, die große Runde zu machen.

Tatsächlich ist facebook selbst mit dutzenden verschiedenen Bots unterwegs (wie Google auch). Und es ist sehr wahrscheinlich, dass sie (ebenso wie Google bei AdSense) eine durch einen Nutzer aufgerufene Seite gleich nochmal mit einem Bot aufrufen. Das müssen sie schon alleine um sich vor dem Vorwurf “Auf fb wird für *böse* Angebote geworben!11″ zu schützen.

[Update] Ein weiteres mir bisher unbekanntes StartUp hat eine ähnliche Story. Die Firma Wahanegi möchte Usern helfen, sich in ihrem Leben zurechtzufinden und die richtigen Entscheidungen auf der Basis ihres bisherigen Lebens zu treffen. Man könnte es Crowded Mentoring nennen. Was immer das auch heissen mag scheint mir facebook-Werbung tatsächlich eine gute Idee zu sein. Diese hat die Firma inzwischen aber eingestellt.

Der Gründer schreibt in seinem Blog seit Mai darüber, dass seine fb-Werbung von “booklicants” geklickt wird. Dabei handelt es sich um Leute oder Bots, die eine neu geschaltete Werbung innerhalb der ersten Tage massiv klicken und die Seite liken. Das machen sie aber offensichtlich sehr gerne. Teilweise bringen es diese User innerhalb eines Tages auf über 100 Likes.

Und tatsächlich konnte er einen dieser Accounts kontaktieren und es stellte sich raus, dass es tatsächlich Leute gibt, die massenhaft Ad-Likes klicken. Offensichtlich handelt es sich dabei um einen Gamefication-Effekt. Die User versprechen sich Vorteile in Bezug auf ihre soziale Reputation oder das Ad-Targeting.

Es scheint sich bei den Booklicants nicht um die gleichen User zu handeln, die für die Clicks bei Limited Run verantwortlich sind. Denn mal wird der Like-Button einer Werbung geklickt und mal die Werbung selbst. [/Update]

*) Erpressung wirft die Firma facebook vor, weil eine Namensänderung laut facebook-Ansprechnpartner nur dann möglich sei, wenn sie gleichzeitig Werbung in Höhe von $2000 schalten. Limited Run betrachtet sich selbst oder wenigstens ihren Namen als Geisel und facebook als Geiselnehmer. Sollten sich die Vorwürfe erhärten wäre das ein Fall für die Staatsanwaltschaft und die Wettbewerbshüter. (Inzwischen hat facebook sich zu diesem Vorwurf geäussert und von schlechter Kommunikation gesprochen.)

Frustration mit dem @Raspberry_Pi

Nach mehreren Nächten mit dem Raspberry Pi stellt sich bei mir erhebliche Frustration ein. Einem schönen Stück Hardware fehlt ein konsistentes und konsequentes Software-Packaging. Das Ausmaß der Ziellosigkeit wird seit gestern für jeden deutlich. Auf der Downloadseite liest man seit neuestem unter “Raspbian ‘wheezy’“:

If you’re just starting out, this is the image we recommend you use.

Folgt man jedoch dem Link zu der Projektseite von Raspbian liest man dort als Antwort auf die erste Frage in den FAQ’s:

First of all, you need to know that Raspbian is under active development and is not suitable at this point for someone new to Linux or small ARM based systems such as the Raspberry Pi.

Das favorisierte System eines Lerncomputers für Menschen/Kinder, die an die Programmierung herangeführt werden sollen, ist nicht geeignet für Leute, die noch keine Erfahrungen mit Linux oder ARM-Systemen haben? WTF!

Das neue System ersetzt dabei eine Debian-Distribution, die nur marginal an das Board angepasst war. Von vielen Nutzern wurde kritisiert, dass die Distribution das Board einfach überfordert. Die Standardpakete installieren vollkommen unsinnige Abhängigkeiten. Möchte man beispielsweise Bluetooth installieren wird gleich mal das riesige Druckersystem CUPS mitinstalliert. Bei dem GPS-Deamon bekommt man dann auch noch die Lüfterkontrolle mit dazu. Buy one get 493 for free.

Dabei sollte eigentlich schon längst eine spezielle Fedora-Version verfügbar sein. Noch im März verkündete man, die Fedora-Distribution wäre fertig und könne verwendet werden. Aus der angekündigten Version Fedora 17 wurde bis jetzt nichts. Kein Wunder, dass Raspberry nun nervös geworden ist und eine angepasste Debian-Version zwischengeschoben hat.

Zusammen mit dem Arch Linux ARM und QtonPi gibt es damit derzeit fünf verschiedene OS-Alternativen (plus dutzende Branches). Davon sind oder waren drei von Rapsberry Pi selbst empfohlen. Hinzu kommt noch ein Firmware-Update. Dieses braucht man zum Beispiel, um Webcams oder TV-Tuner anzuschliessen.

Aus diesem OS-Zoo erwächst schon jetzt ein grundlegendes Problem: wo bekomme ich als Neuling Hilfe her? Eine große kenntnisreiche Community hat bereits alle möglichen Artikel über die Einrichtung das Systems veröffentlicht. Da sich aber das empfohlene System permanent ändert, haben selbst erfahrene Anwender erhebliche Probleme zu unterscheiden, welche die richtige Vorgehensweise ist.

Bei mir hat das Firmware-Update zwar dazu geführt, dass die Kamera inzwischen funktioniert, aber jetzt hängt das System beim Start wenn ein Bluetooth-Dongle angeschlossen ist. Sicher ein lösbares Problem – für mich. Aber für einen Anfänger? (Ja, ich glaube, dass viele mit einer Bluetooth-Maus und einer WebCam spielen wollen.)

Der Hype um das Projekt hat offensichtlich so viel Druck erzeugt, dass eine viellecht mal vorhandene Softwarestrategie über den Haufen geworfen wurde. Und dieser Fehlstart wird dem System wahrscheinlich lange anhängen. Viele Neulinge werden frustriert die Hände davon lassen. Schade.

Zum Verständnis: Ich würde dem Projekt für Idee und Initiative 100 Punkte für guten Stil geben. Und auch die Hardware kann nach meinem bescheidenen Verständnis in diesem Bereich 95 von 100 Punkten erhalten (Abzug für HDMI).