Archive for the ‘netzpolitik’ Category

Was ist Deep Packet Inspection (DPI)?

Die ITU tagt grade in Dubai und möchte jetzt endlich die Verwaltung des Internets übernehmen. Um ihren Anspruch zu unterstreichen, möchten sie als erstes mal einen Standard für Deep Packet Inspection einführen. Zu einer ordentlichen Verwaltung gehört doch auch immer eine lückenlose Kontrolle. Aber was versteht man eigentlich unter DPI?

Prinzipiell ist das Internet ein paketorientiertes Netz. Sehr einfach dargestellt, werden alle Daten in Pakete gepackt, mit einer Adresse und einem Absender versehen. Diese Pakete werden dann von Router zu Router über sogenannte Gateways gereicht, bis sie es zum Empfänger geschafft haben. Dabei ist es diesen Routern eigentlich vollkommen egal, was in diesen Paketen ist. Nur eine Beschränkung gibt es: die Paketgröße oder Maximum Transmission Unit (MTU). Sie ist in einem typischen Ethernet 1500 Bytes. Das bedeutet, dass fast alles, was im Netz stattfindet auf mehrere Pakete aufgeteilt werden muss.

Die verschiedenen Arten der Kommunikation zwischen zwei Rechnern im Netz kann man einem Paket von aussen nicht ansehen. Und bei jeder Art von Kommunikation handelt es sich um einen Dienst respektive Service. Dabei ist es relativ egal, wer jetzt grade der Diensteanbieter (also Server) ist und wer der Empfänger (Client). Für das WWW der http-Service oder -Protokoll eingesetzt. Bei Mail kommen verschiedene Dienste in Frage: IMAP, POP und SMTP. Bei Chats gibt es dutzende verschiedene Protokolle und letztlich kann sich jeder seinen eigenen Dienst ausdenken und ihn auch benutzen.

Für DPI wird bei den Gateways zusätzliche Hardware installiert, die in der Lage ist, Inhalte der Pakete zu analysieren. Dazu müssen die Pakete nach ihrer fortlaufenden Nummer untersucht werden, da die erste wichtige Information bei allen Diensten in den ersten Paketen zu finden ist. Bei dieser wichtigen Information geht es um die Art des verwendeten Dienstes, also z.B. ob es sich um http, imap oder smtp handelt. Diese Erkennung ist notwendig, weil alle Dienste verschiedene Sprachen sprechen. Und diese Sprache muss bekannt sein, damit man analysieren kann, wer die beiden Teilnehmer und was der Inhalt der Kommunikation ist.

Nachdem der Dienst und damit das Datenformat der Kommunikation bekannt ist, wird der Inhalt des Paketes an einen anderen Prozessor weitergereicht, der nur dieses entsprechende Protokoll versteht. Dieser kann nun die Weiterreichung unterbinden, weil zum Beispiel der entsprechende Server auf einer schwarzen Liste steht. Zu dieser Sperrung genügt die bloße IP-Adresse meistens nicht, weil z.B. ein Web-Server unter verschiedenen Domains auf der gleichen IP-Adresse verschiedene Inhalte ausliefern kann.

Wenn es jedoch darum geht ganz bestimmte Inhalte zu sperren – etwa ein urheberrechtsgeschütztes Bild – muss das Paket mit dem Request noch genauer untersucht werden. Erst die GET-Anforderung gibt Aufschluss über die tatsächlich angeforderte Adresse. Problematisch bei http ist aber beispielsweise, dass vor dem GET beliebig viele Zeilenumbrüche erlaubt sind. Unter Umständen muss also nicht nur das erste Paket mit den 1500 Bytes ausgepackt werden, sondern noch weitere Pakete.

Noch komplizierter wird es, wenn die Inhalte selbst Gegenstand der Untersuchung werden. Es können verschiedene Zeichensätze zum Einsatz kommen, oder die Übertragung kann beispielsweise mit Zip gepackt sein. Diese müssten also vorher umgewandelt oder ihrerseits wieder ausgepackt werden.

Bei Milliarden von Paketen, die stündlich über ein typisches Gateway laufen bräuchte man dafür eigentlich schon einen Supercomputer. Wenn es da nicht diese kleinen FPGAs gäbe. Dabei handelt es sich Computer, die keine CPUs im herkömmlichen Sinne haben, sondern viele sehr einfache Recheneinheiten, die für bestimmte Aufgaben hardverdrahtet (allerdings mittels Software) werden. Sie verhalten sich eher wie Signalprozessoren, die bei einem bestimmten Signal eine Ausgabe generieren, während sie ansonsten nichts tun.

Für eine Paketanalyse werden viele dieser FPGAs mit allen möglichen Regeln programmiert. Letztlich agieren sie dann wie ein Weichensystem, dass in dem Paketstrom alle Pakete an eine Adresse rausfiltert, dann die Pakete mit http-Daten an andere weiterleiten, diese wiederum, die Pakete mit bestimmten Hostnamen rausfiltern u.s.w.

Einer der Hersteller von solcher Hardware ist übrigens die Berliner Firma Rohde&Schwarz. Die haben auf der letzten CeBIT bekanntgegeben, dass sie eine Partnerschaft mit Adyton Systems aus Leipzig eingehen. Es geht dabei um eine “revolutionäre” Technik der Leipziger für Deep Packet Inspection. Und von Rohde&Schwarz ist auch ein Vertreter der Deutschlands auf der ITU in Dubai. So schliesst sich der Kreis.

Gilt die EU Privacy Richtlinie auch in Deutschland?

Im Rahmen eines Expertentreffens beim Bundesverband der Verbraucherzentrale wurde gestern über den Stand der EU Privacy Richtlinie gesprochen. Es zeigte sich, dass nach wie vor differierende Auffassungen über die Gültigkeit in Deutschland existieren. In allen europäischen Ländern gibt es verschiedene rechtliche Umsetzungen der Richtlinie. Während zum Beispiel in UK der Text weitgehend unverändert übernommen und in geltendes Recht übernommen wurde, hat sich die Bundesregierung bisher nicht zu einer Gesetzesinitiative hinreissen lassen. Dort vertreten einige die Meinung, dass das Telemediengesetz (TMG) die Richtlinie eigentlich ausreichend umsetzt.

Spätestens jedoch die im TMG festgelegte Ausnahme der Marktforschungszwecke kollidiert mit der Privacy Richtlinie. Sie verlangt eine explizite Einverständniserklärung eines Nutzers selbst bei der Erfassung von pseudonymen Daten. Dieser Schutz selbst pseudonymer Daten führt zum Beispiel zu den Hinweisbannnern auf vielen britischen Sites. Andreas Sachsv om Bayerischen Landesamt für Datenschutzaufsicht konnte jedoch zeigen, dass selbst dabei manchmal die Vorgaben nicht korrekt umgesetzt werden. Auf bbc.co.uk wird zwar ein entsprechender Hinweis gezeigt, aber bereits zu diesem Zeitpunkt sind verschiedene Cookies gesetzt.

Der Hinweis auf der BBC-Seite ist mit Sicherheit rechtlich nicht korrekt. Zwar gibt es einen Hinweis auf die Erfassung von Daten aber bereits vor der Zustimmung werden mehrere Cookies gespeichert.

Der bekannte Online-Anwalt Thomas Schwenke machte deutlich, welche Auswirkungen die bestehende Rechtsunsicherheit im Alltag von KMUs und StartUps hat. Im Kern wurde aber deutlich, dass eine Annäherung an eine starke Interpretation der rechtlichen Situation nicht unbedingt mit schrumpfenden wirtschaftlichen Möglichkeiten einher gehen muss. Einen Überblick über die rechtliche Situation aus Sicht der Verbraucherzentrale gab die Gastgeberin Michaela Zinke, die unter anderem das Projekt “Verbraucherrechte in der digitalen Welt” betreut.

Großen Raum nahm das Thema Do Not Track (DNT) ein. Kristina Bock vom ULD in Schleswig Holstein gab einen interessanten Abriss dieser tragischen Geschichte mit einigen interessanten Einblicken in die Diskussion in der die Europäer auf eine sehr wirtschaftlich geprägte Working Group des W3C in den Staaten. Sie bestärkte meine Meinung, dass Microsoft mit seinem Vorgehen, den IE 10 per default mit eingeschaltetem DNT auszuliefern, sehr genau die Interessen der Nutzer wahrnimmt. Dessen ungeachtet bestand Einigkeit darin, dass DNT ein ungeeignetes Instrument zur Durchsetzung eines Schutzes der Privatsphäre ist. Darüber hinaus hätten die politischen Beteiligten bei dem Standardisierungsprozess durchaus aus der Geschichte von P3P lernen können.

Interessante Ausblicke ergaben sich aus der Frage, wie insbesondere Drittanbieter mit der wachsenden Unsicherheit umgehen werden. Sowohl der in der Richtlinie geforderte Hinweis auf die Verwendung von Cookies als auch DNT dürfte nach meiner Meinung zu einem vermehrten Einsatz von Fingerprint-Erkennung führen. Eine Technik, die leider in der Öffentlichkeit kaum Beachtung findet. Die Zeit hat jedoch grade ein Projekt von Henning Tillmann beschrieben in dem er mit Hilfe der Crowd das Thema stärker in die Öffentlichkeit bringen möchte.

Obwohl die Teilnehmer keiner neoliberalen Weltanschauung verdächtig sind war man sich am Ende doch weitgehend einig, dass der Markt die Umsetzung der Richtlinie befördern könnte. Denn würde man der Auffassung folgen, dass die EU Privacy Richtlinie auch ein Instrument zur Regulierung eines freien Wettbewerbs ist könnte ein Anbieter aus dem europäischen Ausland ohne weiteres eine Wettbewerbsklage gegen einen deutschen Konkurrenten anzetteln. Denn ohne Frage verschafft sich ein deutscher Anbieter einen Wettbewerbsvorteil, wenn er sich lediglich an das laschere deutsche Recht hält.

[Update] Thomas Schwenke hat seinen Vortrag auf dem Expertentreffen und seine Erkenntnisse zu einem ausführlichen Artikel zusammengefasst. [/Update]

Extension für Chrome: Leistungsschützer ausblenden

Die sehr lange Liste der Unterstützer des Leistungsschutzrechts umfasst inzwischen fast jeden großen und kleinen Verlag in Deutschland. Nun ist es jedoch sehr mühselig vor jedem Klick bei Google immer erst nachzusehen, ob Google die Snippets eines dieser Verlage raubmordkopiert hat. Daher habe ich eine kleine Chrome-Extension namens “Leistungsschutz” geschrieben gemacht, die die entsprechenden Fundstellen ausblendet.

Bei der Suche nach ‘hannover’ würde ich normalerweise mehrere Einträge der HAZ und der Neuen Presse bekommen. Die erscheinen nun nicht mehr. <ironie>Der Verlag kann sich also entspannt zurück lehnen denn Google wird bei mir zukünftig daran gehindert sich an der Arbeit anderer zu bereichern.</ironie>

Die Extension liegt nur als Source-Code vor und muss lokal vom eigenen Rechner geladen werden.

1. Zip Downloaden & uspacken,

2. Chrome -> Einstellungen -> Erweiterungen -> Entwicklermodus/Developer Häkchen setzen.

3. Entpackte Erweiterung laden.

Alles zur freien Verfügung und Veränderung und Weitergabe. Natürlich ohne jede Gewähr.

(Zu Hilfe kam ein kleines Tutorial, jQuery und diese Anleitung.)

[Update] @seiz hat sich etwas mehr Mühe gemacht und es als fertig installierbare Extension für Safari bereitgestellt. Vielen Dank! [/Update]

Schirrmacher verlässt der Mut

Wenn Frank Schirrmacher in der FAS mit einer Rundumbeleidigung auf den Plan tritt, kommt die Reaktion der Betroffenen prompt. Schirrmachers Vorwurf an die Netzbegeisterten lautet im Kern, sie würden Neoliberalismus als Heilslehre propagieren. Das “heilige Versprechen” sei, dass das Netz (und/oder die darunter liegende Technik) jedem die Erfüllung des amerikanischen Traums verspräche.

Im Zusammenhang mit dem Zeitungssterben könnte man den Titel “Das heilige Versprechen” fälschlich als ein solches an die Leserschaft und die Gesellschaft insgesamt verstehen. In etwa so: “Wir Journalisten versprechen den Lesern heilig, ihr Recht auf freie, unabhängige Information und Meinung zu garantieren.” Ein solches Versprechen wäre mal was. Eine Art Pressecodex vielleicht. Denn hört man sich um, stellt man fest, dass sehr viele Menschen (und nicht nur im Netz) die Redaktionen und deren Verlage für bloße Büttel der ‘Mächtigen’ halten. Es ist inzwischen eine offensichtlich weit verbreitete Meinung, dass kritische Berichterstattung systematisch unterdrückt wird. Das Zeitungssterben wird von solchen Verschwörungstheoretikern mit einer gewissen Hähme zur Kenntnis genommen.

Schirrmacher bezieht das “heilige Versprechen” jedoch auf diejenigen, die die neue Technik als Chance sehen. Sie würden allen eine Welt versprechen in der jeder vom Konsumenten zum Produzenten werden könne, wenn er sich nur selbstaufopfernd genug reinkniet. Und dieses Versprechen habe sich bisher als hohl und sogar giftig herausgestellt. Lediglich einige wenige im Silicon Valley wären erfolgreich, damit aber auch gleichzeitig zu bösen, kulturvernichtenden Monopolisten geworden. Die Frage nach Graustufen, Alternativen oder Forderungen, die sich aus dieser Feststellung zwangsläufig ergäben, beantwortet der Autor nicht.

Dabei wäre es mal sehr interessant die Heilsversprechen der Netzapologheten in einen größeren historischen Kontext zu stellen.

Das Internet ist zunächst mal yet another Technik. Es besteht kein qualitativer Unterschied zu anderen Techniken. Telefon, Buchdruck und Eisenbahn wurden alle in einer Welt entwickelt, in der es die gleiche Funktion schon zuvor gab. Jede neue Technik führt eine frühere Funktion immer effektiver aus. Ansonsten würde sie sich nicht etablieren. Dieser Marktmechanismus funktionierte sogar schon im frühen Agypten. Von Neoliberal kann dabei also nicht die Rede sein.

Da (erfolgreiche) neue Techniken immer effektiver sind, bescheren sie ihren Nutzern einen größeren Freiheitsgrad. “Ich kann mit dieser Technik in der gleichen Zeit mehr [von etwas] machen und somit die gleiche Menge [von etwas] in kürzerer Zeit machen.” Daher liegt jeder neuen Technik ein Heilsversprechen inne.

Die Vergrößerung der Freiheitsgrade durch neue Techniken lässt sich noch differenzieren. Eigentlich geht es nämlich immer um zwei Parameter, die auf die eine oder andere Art verändert werden.

1. Der Winkel, die Auflösung

Die Erfindung des Teleskops und kurz darauf, des Mikroskops hat unserem Sichtfeld eine höhere Auflösung durch kleinere Winkel gebracht. Durch simple Optik, die bereits zweitausend Jahre früher möglich gewesen wäre, wurden die Freiheitsgrade der Erkenntnis erheblich erweitert. Nicht nur für unser Weltverständnis sondern auch für die Art, wie man Krieg führt. Eine Ausdehnung des Wahrnehmungswinkels über den Bereich des sichtbaren Lichts hinaus, hat einige Jahrhunderte später wiederum zu mehr Erkenntnis in Wissenschaft und Krieg geführt. Und jede dieser neuen Techniken war immer auch verknüpft mit Heilsversprechen. Es empfiehlt sich, nach “Mesmerismus” zu googeln.

In diesen Bereich der technischen Neuerungen fallen aber selbst solche Erfindungen, die das Leben “nur” schöner machen. Die Erfindung/Entdeckung des Glasschmelzens oder der Porzellanherstellung ermöglichte keine neue bisher, nicht dagewesene Funktion, sondern hat nur bestehende vielfältiger werden lassen.

2. Geschwindigkeit

Alle Techniken, die nicht in einer beliebigen Form Winkel oder Auflösung erweitern sind direkt oder indirekt mit Geschwindigkeit verknüpft. Das gilt natürlich sehr offensichtlich für den Transport von Gütern oder Daten. Aber auch für die Produktion von Gütern und Daten. Dampfmaschine, Buchdruck und Rechenmaschine führten immer dazu, dass irgendwas schneller ging als vorher.

Interessant ist die Verknüpfung beider Paramter. Die höhere Geschwindigkeit hat in Zusammenarbeit mit einer Diversifikation der Transportmittel selbst, zu einer vollkommen veränderten Produktions- und Handelsform von/mit Gütern geführt. Während gerade große Containerschiffe durch den Suezkanal riesige Mengen von immer dem Gleichen nach Europa schiffen, fliegen gleichzeitig hunderte Berater in die andere Richtung um die Produktion in China zu optimieren und neue Produkte zu ordern.

Wenn alle technische Entwicklung die Freiheitsgrade erhöht, dann kommt dieser Effekt in jedem Fall allen zu gute. Wenn nicht direkt, so doch immer – früher oder später – indirekt. Ganz ohne jedes Heilsversprechen ist es also die Folge von jeder technischen Entwicklung, dass die Menschen insgesamt nachher mehr Freiheit haben.

Diese Freiheit weiss nicht jeder zu nutzen. Denn mit mehr Freiheit geht auch mehr Verantwortung einher. So hat der beschleunigte Handel von Waren des täglichen Bedarfs zum Sterben der Tante-Emma-Läden geführt. Als Konsument im Supermarkt bin ich heute selbst für die Wahl meiner Nahrungsmittel verantwortlich, denn der Vollsortimenter verspricht den Kunden, ihn in seiner Wahl nicht einzuschränken. Diese Freiheit führt aber offensichtlich auch dazu, dass sich immer mehr Menschen schlechter ernähren als sie es eigentlich könnten oder sollten.

In Schirrmachers Artikel kann man daher auch einen Subtext hineininterpretieren: “Freiheit überfordert die Menschen, gebt ihnen nicht zuviel davon!”

–––

Übrigens schreiben auch andere viel Antwort auf den Artikel, was @kay_siegert zu einem treffenden Tweet veranlasste: ”So eine schöne Debatte wie @fr_schirrmacher mit seinem Artikel losgetreten hat, ist halt im Print nicht machbar.”

Patrick Breitenbach fragt den Autor unter dem Titel “Neoliberalismus im Journalismus? Wer hat’s erfunden?” nach Alternativen. Christian Jakubetz sieht Schirrmacher auf einer Mondfahrt und zählt vier Punkte auf, warum die Medienlandschaft heute anders aussieht als früher. Thomas Knüwer verweist auf seinen drei Jahre alten Artikel über die Frage, “Wie Verlage im Internet Geld verdienen?” in der er die Antwort auch gleich gibt: “So wie bisher.“. Dabei belässt er es dann aber doch nicht. In seinem nachgereichten Post “Das heilige Gebrechen von Frank Schirrmacher” filetiert er den Autoren und dessen Elaborat. Knüwer hält offensichtlich die Qualität der journalistischen Tätigkeit für einen wichtigen Schlüssel für den Fortbestand der Branche.

Und schliesslich möchte man fast annehmen, dass Schirrmachers Gemoser zu einem singulären Moment der (Internet-)Geschichte werden könnte. Denn liest man den Post von Marcel Weiss bei neunetz reibt man sich die Augen, wie viel Reflektion der FAZ-Herausgeber frei zu setzen vermochte. Der Titel “Die Dauer von Strukturwandel und die Ungeduld des Frank Schirrmacher” hätte es verdient, in der nächsten Lettre veröffentlicht zu werden.

Mh120480 sieht in dem Artikel seine Theorie bestätigt, “dass es den Kampf der Netzwerke (Führungseliten, Unternehmen, Politik) gegen die Crowd geben wird“. Und natürlich darf der Verweis auf “Der Sturm” nicht fehlen, den Gunnar Sohn süffisant in seinem Artikel liefert: “Über Schirrmacher: In der Vergangenheit hat er so viele Theorien in die Welt gesetzt“.

In den Blogs kommen allerdings allerdings keine Lobpreisungen, die findet man dann um so häufiger bei twitter: ”Gäbe es doch mehr Artikel dieser Klasse.“, “FANTASTISCHER Artikel“, “Pflichtlektüre“, “Das Beste, was seit langem über Journalismus und Technik geschrieben wurde” …

Datenschutzdebatte: der Ton wird rauher

Der sich selbst als “Pirat in der SPD” titulierende Jan Moenikes bezeichnete gestern die Institutsleiterin an der Wiener Wirtschaftsuniversität Sarah Spiekermann als “intellektuell überfordert”. Vorangegangen war ein Artikel von ihr in der Zeit und eine Replik von dem bekannten Anwalt Nico Härting auf cr-online, dem “Portal zum IT-Recht”.

In dem Zeitartikel hatte Spiekermann die massiven Bemühungen der Lobbyisten, die deutschen und europäischen Datenschutzgesetzte und -verordnungen zu verwässern beschrieben und angeprangert. Der Kragen ist ihr offensichtlich auf der Tagung “Datenschutz im 21. Jahrhundert” geplatzt. Nach ihrem Empfinden sind Hundertschaften von Lobbyisten im Einsatz, die die bestehenden Richtlinien zu Fall zu bringen möchten und ein mehr wirtschaftsfreundliches Datenerfassungs- und verarbeitungsklima schaffen wollen.

An der Zahl der Lobbyisten entfachte sich dann auch die Diskussion der eigentlichen Lobbyisten. Die “Wiener Forscherin” würde maßlos übertreiben. Aber auch Ralf Bendrath bestätitgte die Hundertschaften, zumindest für Brüssel, wo momentan tatsächlich die eigentliche Diskussion stattfindet.

Der Argumentationsdruck auf Politik und Medien wird erhöht

Die Kritiker von Spiekermann muss man sich genauer ansehen. Denn der übelmeinende Beobachter könnte denken, sie agierten unter falscher Flagge. Und offensichtlich scheinen sie dabei recht erfolgreich. Nico Härting ist von der Kanzlei “Härting Rechtsanwälte” laut Homepage bekannt “vor allem aus dem Medien- und Internetrecht”. Die Seite bietet beispielsweise den netten Service von Vertragsvorlagen rund um das digitale Business.

Der ebenfalls als Anwalt tätige “Pirat in der SPD” Jan Mönickes ist häufig in Funk und Fernsehen zu Gast. Kürzlich hat er beispielsweise auf dem Ostdeutschen Journalistentag einen Vortrag mit dem Titel “Vorratsdatenspeicherung – ein notwendiges Übel” gehalten. Ein echtes rhetorisches Meisterstück. Denn er hangelt sich in wenigen Sätzen von der verständlichen Hoffnung der Ermittler auf Überwachungstechniken, über die Sorgen vor totaler Überwachung, zu nicht näher benannten versteckten Absichten der Kritiker dieser Techniken. Dass Mönickes ein etwas anderes Verständnis von Datenschutz hat als die bekannten Datenschützer sieht man schon an der Verwendung von Begriffen und Interpunktion. So spricht er von der “sog. Vorratsdatenspeicherung” und von “absolutem ‘Recht auf Anonymität’”.

Einem themenfremden Journalisten dürfte es nach einem solchen Briefing schwerer fallen, jemanden wie Peter Schaar ernst zu nehmen.

Spannender jedoch ist Härting und seine Kanzlei. In Zusammenarbeit mit SSW (Schneider Schiffer Weihermüller) beschäftigen sie sich hier mit den aktuellen und zukünftigen Datenschutzgesetzen. Dort findet sich zum Beispiel seit August 2012 ein “Alternativentwurf” der Datenschutz-Grundverordnung (zu finden unter schneider-haerting,de).

Kern dieses Alternativentwurfs ist letztlich die Abschaffung des “Verbot mit Erlaubnisvorbehalt”, der Basis des deutschen und europäischen Datenschutzes. Den “Alternativentwurf” sollte sich jeder mal durchlesen. Er zeigt nicht nur wohin die Reise gehen soll, sondern macht auch deutlich, woher die ganzen schlecht ausgearbeiteten Gesetze kommen. Es ist unlogisch, fehlerhaft strukturiert und wichtige Punkte werden vollkommen aussen vor gelassen.

Ein neuer Spin der Targeter in der Privacy-Diskussion

tl;dr In einem FAZ-Artikel fordert der nugg.ad-Gründer das Recht auf Pseudonymität und Offenlegung der Targeting-Algorithmen. Beide Forderungen sollen möglicherweise nur Verwirrung stiften, statt konstruktiv zu wirken.

Symbolbild: Anonym oder Pseudonym?

Stephan Noller (twitter:@StephanNoller) ist Gründer der Firma nugg.ad die vor einiger Zeit von der Deutschen Post gekauft wurde. Und er engagiert sich, die Interessen der Firma und der ganzen Branche in Berlin und Brüssel bekannt zu machen. Das gelingt ihm ausgezeichnet zum Beispiel mit einem selbst veranstalteten Kongress in Berlin, den Data Days 2012 über den alle großen Medien bis hin zu heise berichteten. Aber auch mit Artikeln zum Beispiel in der FAZ. Heute erschien dort im Feuileton folgendes ‘Plädoyer für eine Algorithmen-Ethik’

Der Artikel ist es wert, genauer betrachtet zu werden, denn er zeigt eine neue Argumentationslinie in der immer undurchsichtiger werdenden Diskussion um die Privatsphäre der Nutzer.

Nugg.ad betreibt sehr erfolgreich Targeting und Retargeting. D.h. sie erstellen Profile von Onlinenutzern und geben auf der Basis dieser Profile Empfehlungen für die diesem Nutzer anzuzeigende Werbung. Wenn man auf einem größeren deutschen Onlineangebot surft, ist es recht wahrscheinlich, dass man eine gezielte Werbung über nugg.ad zu sehen bekommt.

Die Firma hat sich schon sehr früh offen mit dem Datenschutz der User auseinandergesetzt. Auf dieser Seite bietet sie beispielsweise ein Opt-Out für Nutzer an und man kann sich ansehen, welche Themen wie stark mit dem eigenen Profil verknüpft sind. (Wer die Seite mit Safari aufruft wird wg. des Umgangs des Browsers mit Third-Party-Cookies dort nichts vorfinden.) Nach meinen Kenntnissen ist die Datenschutzfahne auch nicht nur ein Feigenblatt sondern wird bis hinunter in die Coding-Katakomben ernst genommen. Nugg.ad ist also ein eher helleres Wesen in einem wirtschaftlichen und rechtlichen Dunkelgraubereich.

Wie immer, wenn es in Massenmedien um Algorithmen geht werden auch hier wieder Algorithmen mit unheilschwangeren Untertönen behandelt. Obwohl der Autor von Software lebt reiht er sich hier ein in die Reihe der Voodoo-Gemeinde, die Algorithmen schon fast eine eigene Persönlichkeit zusprechen. Miriam Meckel lässt grüßen.

Darüber hinaus kommt an mehreren Stellen im Artikel eine sehr regulierungsfeindliche Einstellung zum Vorschein. So wird die Arbeit des Kartellamtes als Eingriff in die Mechanik des Marktes bezeichnet, der “schwer zu vertreten” sei. An dieser Stelle reiht sich Noller in die Reihe der Porstprivacy-Vertreter ein, die gerne auch mal neoliberal argumentieren.

Nollers Forderungen

Der schwer zu lesende Artikel fordert nach einem Exkurs über Regulierung in der Medienbranche eine Algorithmen-Ethik. Diese würde unter anderem Transparenz der verwendeten Algorithmen bedeuten. Der Autor argumentiert, dass die Nutzer von Medien darüber informiert werden müssten, wie die Auswahl der Inhalte und Aufbereitung zustande kommt. Denn wie kann ich eine Meldung einschätzen, wenn ich deren Kontext nicht kenne. (Wie es übrigens für die Leser des Artikels nicht sichtbar ist, dass Noller selbst mit Targeting sein Geld verdient.)

Die Forderung nach Offenlegung der Algorithmen beschreibt Noller selbst als “wahrhaft schwer in den Griff zu bekommen”. Vor dem Hintergrund immer wilder um sich schiessenden Patenttrollen ist die Forderung nach dem Öffnen der Firmenschatzkammer vollkommen absurd. Das weiss Noller auch, was ihn aber nicht davon abhält diese Forderung aufzustellen.

Pseudonymität als Pseudonym für Anonymität

Ebenfalls aus der Algorithmen-Ethik ergäbe sich ein Recht auf Pseudonymität. Der Nutzer müsse die Möglichkeit haben, die Algorithmen abzuschalten. Es fällt sofort auf, dass er hier bewusst nicht von Anonymität spricht. Warum nicht? Was ist der Unterschied?

Im Gegensatz zur Anonymität ist ein Nutzer mit einem Pseudonym identifizierbar. Und tatsächlich ist es Targeting-Firmen weitestgehend egal ob qrios “qrios” ist oder ‘#95f2a’. Für beide Identitätsbezeichner haben sie die Surfhistorie und ein schönes Profil. Mit der Forderung nach dem Recht auf Pseudonymität bringt der Autor einen interessanten Spin in die Abwehr der zukünftig geplanten Datenschutzgesetze. Pseudonymität müsste doch eigentlich den Privacy-Apologeten genügen. Seit an Seit mit den Targetern würden sie dann gegen die Forderung nach identifizierbaren Bürgern beispielsweise von Innenministern kämpfen.

Interessanterweise gibt es das Recht auf Pseudonymität im Netz schon immer. Faktisch gibt es sogar ein Recht auf Anonymität. D.h. der Autor fordert ein Recht, das es längst schon viel weitergehend gibt. Zusammen mit der Forderung nach Offenlegung der Algorithmen wird deutlich, dass wir es hier mit einer simplen Verwirrungsstrategie zu tun haben. Die politischen Entscheider, die die diesen Artikel im Vorfeld von Gesetzesbeschlüssen lesen werden, sollen ganz offensichtlich verunsichert werden.

PS: Mir schlägt sein Szenario von einer algorithmisch generierten Medienwelt tatsächlich auf den Magen. Und ich glaube auch nicht, dass das so kommen wird. Noller selbst beschreibt ja mit den twitter-Lesern in der U-Bahn den kompletten Gegenentwurf. Die eigene Bubble als Kuratoren meines Medienkonsums.

Das Märchen vom Todesstoß für die Online-Werbebranche

tl;dr Die Behauptung der Online-Werbeindustrie, ein starker Schutz der Privatsphäre würde die Branche vernichten, ist offensichtlicher Unsinn. Die Werbeausgaben würden weiterhin in gleicher Höhe fliessen. Nur eben in andere Formen, Techniken und/oder Medien.

Die Diskussion um Do Not Track hat inzwischen bizarre Züge angenommen. Die Werbeindustrie bezeichnet ihre Tätigkeit als Teil der Zivilgesellschaft und DNT müsse diese respektieren. Für Ed Bott von ZDnet ist die Message klar: Eine konsequente Umsetzung von DNT wäre unamerikanisch.

Das Menetekel, das unter anderem von der Direct Marketing Association (DMA) prophezeit wird, sagt das Ende einer ganzen Branche voraus. Falls Do Not Track bei einem – oder sogar im Standard selbst – verbreiteten Browser per default eingeschaltet wäre, würde die Arbeitsgrundlage der Targeter und des verhaltensbasierten Werbens entzogen, Arbeitsplätze würden abgebaut und Amerika verlöre die Führungsposition in einer Zukunftsindustrie.

Aber: Würden tatsächlich weniger Mittel in Online-Werbung fliessen?

Im letzten Jahr wurde in Deutschland knapp 30 Mrd. Euro für Werbung ausgegeben. Den Löwenanteil (ca. 3/4) davon erhielten TV, Radio, Print und Aussenwerbung. Nur schätzungsweise ein Viertel flossen in Online- oder Direktmarketing. D.h. 75% der Werbekunden geben ihr Geld für Massnahmen aus, die keinerlei qualifiziertes Targeting gestatten. Von Retargeting ganz zu schweigen.

Die Mediaplanung für die genannten Werbeformen basiert auf vollkommen fantastischen Angaben zu einer vermeintlichen Reichweite. Die Zahlen zur Reichweite wird für alle Medien unterschiedlich erhoben. Die Einschaltquoten von Radios werden mit Telefonumfragen auf Festnetznummern erhoben, bei den Zeitungen und Zeitschriften wird die Abnahme des Großhandels zu Grunde gelegt, offensichtlich ohne dabei zum Beispiel bei Zeitungen die Remittenden einzubeziehen. Und für das Fernsehen werden “durchschnittliche” Haushalte mit identischen Geräten ausgestattet, die Probanden bekommen eine Schulung und sollen beim Gang auf die Toilette eine besondere Taste drücken. Diese Erhebungsmethode ist so dermaßen absurd, dass man sich immer wieder an die Stirn fassen muss, wenn man hört, dass irgendeine Sendung Einschaltrekorde erzielt hat. Weit verbreitete Festplattenrekorder, Timeshift oder parallele Online-/TV-Nutzung spiegeln sich in den erhobenen Zahlen nicht wieder.

Aber trotzdem geben Markenhersteller jedes Jahr Milliarden für eine Kommunikationsform aus, deren Wirkung sie nur sehr, sehr indirekt messen kann. Steuern kann sie auf der Basis der vorliegenden Zahlen überhaupt nicht. Im besten Fall kann beispielsweise Beiersdorf sehen, ob die Einführung eines neuen Nivea-Produkts erfolgreich war. Falls die Verkaufzahlen hinter den Erwartungen bleiben könnte man mal eine Umfrage machen, ob die Kommunikation auch bei der Zielgruppe angeschlagen hat.

Tatsächlich dürfte Targeting sogar Arbeitsplätze vernichten. Es verspricht eine höhere Responserate als klassische Werbung und dies sogar ohne die leidige und ungenaue Mediaplanung. Was bisher eine Agentur leistete, übernehmen nun Automaten und die Nutzer selbst. Sieht man sich den Verlauf der Werbeinvestitionen in den letzten Jahren an, wird deutlich, dass sich das Volumen nur unwesentlich verändert hat. In den Krisenjahren 2001 und 2009 sind sie signifikant eingebrochen, nun aber wieder auf dem selben Niveau.

Das ist umso erstaunlicher, da in den letzten zehn Jahren das Volumen für Online-Werbung von nahe null auf fast eine Milliarde gestiegen ist. D.h. die Werbetreibenden haben lediglich den Mediamix verändert. Inzwischen werden durchschnittlich 5% des verfügbaren Budgets für Online-Werbung ausgegeben. Davon ist nur ein Teil tatsächlich Privacy-relevant. Die meisten Banner auf den großen Portalen werden nicht zielgerichtet ausgespielt. Der Ad-Server überprüft in vielen Fällen nur, ob ein Nutzer das Werbemittel bereits gesehen hat. Dies liesse sich auch ohne Tracking bewerkstelligen.

Das Volumen der Werbeinvestitionen sind mit hoher Wahrscheinlichkeit vollkommen unabhängig von den verwendeten Techniken. Tatsächlich dürfte sich sogar die Effizienz auf längere Sicht angleichen, denn schon jetzt ist absehbar, dass sich auch beim Targeting eine Resistenz der Nutzer ausbildet. (Abgesehen davon kann die Targeting-Branche nicht einmal ihre Versprechen einlösen und wirklich relevante Angebote machen.)

Und letztlich würde ein Opt-In für Tracking sogar den klassischen Reichweitenmessungen entsprechen. Denn sowohl Telefonumfrage als auch GFK-TV-Messung basieren auf der freiwilligen Teilnahme weniger.

[Update] John Gruber (daringfireball.net) argumentiert grade bezüglich der Reichweitenmessung genauso. [/Update]

[Update] Einen extrem lesenswerten Artikel eines Insiders zu dem Thema mit viel Salz in die offene Wunde der Mediaplaner schrieb Thomas Koch (twitter: @ufomedia). [/Update]

Do Not Track: Chronik eines angekündigten Todes

Bei ZDNet ist ein schöner Rant über das Verhalten der Ad-Betreiber im Prozess der Standardentwicklung von Do Not Track erschienen. Ed Bott vergleicht darin den Ablauf als phantastischer als Alice im Wunderland. Er fragt sich, ob DNT aktuell eher mit 1984 oder mit Brazil vergleichbar ist. Auf der Mailingliste des W3C fand sich die Schlussfolgerung, dass Marketing eine Säule der US-Gesellschaft ist und jeder, der dort Sand ins Getriebe streut, müsse ja wohl Kommunist sein – folgert Ed Bott.

Aus meiner Sicht, war Do Not Track von Anfang an Schwachsinn. Allerdings war mir vor eineinhalb Jahren noch nicht klar, welchen Spin das ganze noch nehmen würde. Im Kern läuft es inzwischen darauf hinaus, dass die Werbebranche offen zugibt, dass sie mit der Dummheit/Faulheit der User rechnet. Und nur, wenn dieser Faktor auch im Standard festgeschrieben wird, ist sie bereit sich dem Diktum zu beugen.

Die Kernfrage lautet: Muss der Nutzer aktiv sagen, dass er nicht getrackt werden möchte (Opt-Out)? Oder sind prinzipiell auch Systeme standardkonform, die dem Nutzer diese Entscheidung abnehmen und das Tracking-Flag ohne Frage setzen (Opt-In).

An dieser Frage scheiden sich nicht nur die Geister – auf der einen Seite die Ad-Betreiber und von dieser abhängige Firmen und auf der anderen Seite z.B. Microsoft, das den Datenschutz als Verkaufsargument entdeckt hat. Bei dem Versuch einen Kompromiss zu finden, werden auch Institutionen wie das W3C und selbst die Apache-Foundation beschädigt.

Alles in allem gibt es allerdings schon heute Fakten. Wenn ein Nutzer heute bei seinem Explorer, Firefox oder Safari DNT einschaltet müsste ein Site-Betreiber dies mit hoher Wahrscheinlichkeit berücksichtigen. Denn kaum ein großer Anbieter könnte sich heute damit rausreden, dass es noch keinen Standard gibt. Allein die Kenntnis über die mögliche Einstellung und damit der Intention des Nutzers dürfte als Argument vor einem – zumindest US- – Gericht genügen, einen Schadensersatz einzuklagen. Das Muster der Prozesse gegen verschiedene Tabakkonzerne könnte für eine Sammelklage ausreichen.

Aus Sicht der Publisher steht und fällt ihr Geschäft mit dem Ad-Targeting. Das dürfte einer der Gründe sein, warum wenig und wenn sehr einseitig über DNT berichtet wird. Letztes Beispiel für eine sehr eingeschränkte Sichtweise präsentierte Golem am Tag der deutschen Einheit. Der Autor Jens Ihlenfeld ist Gründer und Herausgeber von Golem.de. Für ihn wird DNT nur dann funktionieren, wenn es mittels Opt-Out umgesetzt wird. Falls es üblicherweise eingeschaltet ist, droht er, würde sich die Werbeindustrie nicht daran halten.

Ob der Standard in der aktuell verfahrenen Situation überhaupt noch verabschiedet wird ist sehr fraglich. Viel wahrscheinlicher ist eine Gesetzesinitiative des US-Congresses oder der EU-Kommission. Dann hätte die Werbeindustrie hoch gepokert und alles verloren.

[Update] Kaum geschrieben, schon wird berichtet, dass Neelie Kroes als Europa-Chef-Onlinerin das W3C darauf hinweist, dass es nicht akzeptiert wird, wenn das Standardgremium die Privatsphäre der Nutzer verwässert. Eigentlich hatte die EU dem W3C und den beteiligten Firmen aufgetragen bis Juni einen vernünftigen Entwurf vorzulegen. Auch von der FTC kommt Kritik. Laut dem Chef Jon Leibowitz würde der aktuelle Vorschlag ein Schlupfloch bieten, durch das man einen virtuellen Truck fahren lassen könne. [/Update]

Das vermeintliche Ende der Netzneutralität

Letztens saß ich nichts ahnend in meinem Wohnzimmer unweit des Epizentrums der Berliner Filterbubble und plötzlich kehrte der Elektrische Reporter ein. Nach kurzem Abgleich der gegenseitigen Filterkriterien landeten wir schnell bei dem nächsten großen Thema der Netzerregung: NETZNEUTRALITÄT!

Sixtus, die metaebene und viele andere (http://www.spiegel.de/thema/netzneutralitaet/archiv.html) hatten das Thema schon länger auf dem Radar. Vor einiger Zeit ging es noch darum, dass die Telekoms der Welt bestimmte Dienste in ihren Netzen mindestens behindern wenn nicht sogar komplett gesperrt haben. Zumindest jedoch die Benutzung per AGBs verbieten.

Inzwischen kommt das Ende des Netzes, wie wir es kennen mit großen Schritten näher. Auslöser war die Ankündigung der Telekom über eine Partnerschaft mit Spotify. Zukünftig wird (bei Buchung eines Zusatzpaketes) das “Flatrate”-Volumen nicht mehr belastet, wenn man den Musikdienst Spotify benutzt. Der Chor der Kritiker sieht damit die Tür zu einer Welt geöffnet in der nur eine limitierte Anzahl Diensteanbieter einen Vorzugsservice durch die Provider geniessen. Der Nutzer schliddere auf der Gleitcreme eines vermeintlichen USPs gradewegs in einen neuen Walled Garden.

Interessant daran ist, dass der Aufschrei eigentlich schon vor zwei Jahren hätte durch das Netz schallen müssen. Damals hatte facebook und E-Plus bekanntgegeben, dass der Aufruf über die Adresse 0.facebook.com aus dem E-Plus-Netz kostenlos ist. Noch früher gab es bereits sogenannte “Mobile Enabler”. Diese bieten sehr erfolgreich Mobilfunkverträge von allen Netzen als White-Label-Pakete an. Bild-Mobile und Hertha verkaufen diese dann gebrandet und auch dort können die Nutzer bestimmte Angebote kostenlos nutzen. Solche Angebote gibt es sogar komplett verkrüppelt. Online kann man nur ein einziges Angebot nutzen, für den Rest des Netzes gibt es keine Netzverbindung.

Es zeichnet sich ab, dass zukünftig Netz nicht mehr Netz ist. Mehr oder weniger jedes Online-Paket wird spezifische “Vorteile” haben, die man nur als Restriktion begreifen kann.

Alles schon mal dagewesen:

Es empfiehlt sich jedoch ein Blick in die Vergangenheit. Auf dem steinigen Weg von BTX zu einem allgemein verfügbaren IP-Netz waren bei Compuserve, der Deutschen Post und AOL schon immer bestimmte Dienste frei verfügbar, andere wurden nicht auf das Datenvolumen angerechnet und andere eben geblockt. Selbst bestimmte IP-Dienste wurden im Laufe der Zeit entweder beschnitten (z.B. nntp oder irc) oder bevorzugt (z.B. WSJ.com bei Compuserve) behandelt.

Die Entwicklung, die sich jetzt abzeichnet ist relativ klar. Die Provider begreifen, dass das Netz zukünftig ein Service ist, der Standard ist. In absehbarer Zeit werden die Kunden die Differenzierung zwischen Telefon- und Online-Funktion nicht mehr mittragen. Schon heute dürfte etliche Kunden nach zwei Stunden wieder im Laden stehen und fragen “Wie komme ich denn jetzt auf Bild.de?”. Die Antwort “Sie hätten ein Online-Paket dazubuchen müssen.” dürfte nur noch wenige Jahre hingenommen werden.

Die Provider sind bereits in einem Rückzugsgefecht. Sie mögen vielleicht heute noch nicht begreifen, dass sie lediglich Rohrleger und -vermieter sind. Die aktuelle Entwicklung deutet aber darauf hin, dass sie es spüren und noch abschöpfen möchten, was noch geht.

Apache wird Spielball der Do-Not-Track-Gegner

Der freie Web-Server Apache ist eine der Erfolgsgeschichten der Open-Source-Bewegung. Fast die Hälfte aller Web-Sites werden mit dem Apache betrieben. Er ist mächtig, relativ leicht zu warten und wurde quasi auf jedes neue Betriebssystem portiert.

Nun allerdings wird die Freude an diesem Stück Software durch einen Vorfall getrübt, den man als Sündenfall bezeichnen muss. Zehn Zeilen Code eines Patches bringen die Software plötzlich ins Zentrum des Gefechtsfeldes zwischen Userinteressen und den Interessen der Onlinewerbeindustrie.

Vor einem Monat pflegte Roy T. Fielding, seines Zeichens Projektmanager von Apache, eine kleine Änderung der globalen Konfigurationsdatei ein. Diese Änderung wurde bereits kurze Zeit später tatsächlich ausgeliefert. Niemand hat sich daran gestossen. Bis jemandem mal auffiel, was dort drin steht:

Zuerst wird folgende Anweisung gegeben: BrowserMatch “MSIE 10.0;” bad_DNT. Diese besagt in etwa “wenn der aufrufende Browser ein Internet Explorer 10.0 ist, dann setze bitte die Variable “böses DNT”. DNT ist die Abkürzung für Do Not Track.

Das allein wäre noch akzeptabel. Programme im weiteren Verlauf könnten besondere Rücksicht darauf nehmen und würden sich so weitere Abfragen sparen. Aber danach folgt noch die Anweisung: RequestHeader unset DNT env=bad_DNT. Dadurch wird der Server angewiesen, einen eventuell vorhanden http-Header namens “DNT” zu löschen. Und dies sogar unabhängig davon, welchen Wert er hat.

Mit dem Header DNT=1 soll der Browser laut zukünftiger Spezifikation dem Server, mithin dem Betreiber der Web-Site mitteilen, dass der Nutzer nicht getrackt werden will. DNT=0 bedeutet “die Daten dürfen gespeichert und weiterverarbeitet werden”.

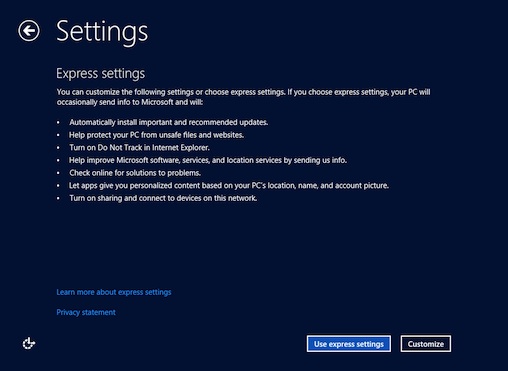

Unter Punkt 3 wird der Nutzer bei der Windows-8-Installation darüber informiert, dass das DNT-Flag gesetzt ist. Der User kann die Einstellungen jedoch anpassen.

Der Autor des Patches argumentiert, dass Microsoft sich nicht an die Spezifikation halten würde. Denn dann müsste das Einschalten von DNT eine aktive Aktion erfordern (eine Diskussion, die schon seit Monaten brodelt). Mindestens jedoch bei der Expressinstallation würde der Wert für DNT auf 1 gesetzt ohne den Nutzer zu fragen.

Dabei sind folgende Dinge interessant:

- Die Spezifikation ist noch nicht verabschiedet.

- Es ist sehr umstritten, ob Microsoft sich nicht an den Entwurf hält. Eine Formulierung nach der der Wert nicht per default gesetzt werden darf war zwar in früheren Versionen zu finden, in der aktuellen ist er nicht mehr drin.

- Apache hat sich bisher nicht als Werkzeug verstanden, Standards durchzusetzen. Vielmehr war Apache immer sehr gut darin, mit Browsern umzugehen, die sich nicht standardkonform verhielten. (Zu denen in der Vergangenheit häufig der Internet Explorer gehörte.)

- Das globale Löschen des Headers macht es nachfolgenden Programmen unmöglich, eine eigene Behandlungsroutine für einen vermeintlich nicht standardkonformen Wert zu implementieren. Man müsste wiederum eine Abfrage nach dem Browser gestalten und dann den Header DNT wieder setzen mit dem Wert “unknown”

Vor dem Hintergrund dieser Punkte ist es nicht verwunderlich, dass eine breitere Öffentlichkeit auf den Patch aufmerksam wurde. Seit vier Tagen ergiesst sich nun ein (gemäßigter) Shitstorm über Fielding. Insbesondere seine Beziehungen zu Adobe werden dabei als Indiz genommen, dass er nicht im Interesse der Apache-Comunity handelt sondern sich und damit auch Apache zum Büttel der Werbeindustrie gemacht hat.

Fielding äusserte sich bisher zwei mal in den inzwischen über hundert Kommentaren zu dem Patch. Er verweist dabei unter anderem auf die bestehende EU-Richtlinie. Laut seiner Aussage würden diese durch DNT im generellen und durch den Patch im besonderen nicht tangiert. Das ist jedoch sehr zweifelhaft. Denn, wenn ein Betreiber eines Systems Kenntnis von dem ausdrücklichen Willen des Users hat, nicht getrackt zu werden wäre die Cookie-Frage obsolet. Und kein Betreiber kann sich heute mehr hinstellen und sagen, er hätte noch nie etwas von Do Not Track gehört.

Darüber hinaus wäre die Frage, ob ein solches Verhalten eines Web-Servers nicht selbst schon Computersabotage ist. Denn laut StGB § 303b macht sich strafbar:

Wer eine Datenverarbeitung, die für einen anderen von wesentlicher Bedeutung ist, dadurch erheblich stört, dass er (3.) eine Datenverarbeitungsanlage oder einen Datenträger zerstört, beschädigt, unbrauchbar macht, beseitigt oder verändert, …

Es ist weitgehend unstrittig, dass die meisten Nutzer das Tracking in der heute verbreiteten Form ablehnen. Ausserdem gilt es als gesichert, dass die meisten Menschen – aus welchen Gründen auch immer – Standardeinstellungen eines Browsers nicht ändern. Da aktuell eine ganze Branche von sehr kostengünstig zu erhaltenden Daten lebt, gibt es daher auch ein starkes Interesse, dass zukünftig nicht lauter Nutzer mit einem Betriebssystem (Windows 8) und einem Browser (IE10+) unterwegs sind, der jedem Web-Server in der Welt mitteilt: Ich möchte nicht getrackt werden!

Ginge man von einem Windows-8-Marktteil von 50% in drei Jahren aus und einem Anteil von 50% Explorer-Nutzer, dann reden wir von 25% Browseranteil. Bei 10% Nutzern, die die Einstellungen ändern, würde eine Standardeinstellung je nach Wert bedeuten, dass entweder 2,25% oder 22,5% nicht erfasst werden dürfen. Ersteres fiele unter statistische Abweichung, letzteres würde knapp ein Viertel des Retargeting-Umsatzes ausmachen, der allein in Deutschland irgendwo zwischen 100 und 300 Mio € jährlich liegen dürfte.

Mehrere $100 Mio jährlich weltweit sind es offensichtlich schon wert, einen Dummen zu suchen, der seinen guten Ruf und den eines erfolgreichen Open-Source-Projekts aufs Spiel setzt.

Disclaimer: Ich selbst halte Do Not Track nicht für den richtigen Ansatz. Denn letztlich kann niemand wirklich kontrollieren ob sich Anbieter daran halten. Ich selbst würde eine Opt-In-Lösung für den einzig richtigen Weg halten. Dabei könnten User belohnt werden, wenn sie ihre Daten zur Verfügung stellen.