Archive for the ‘privacy’ tag

Heute im Angebot: 35 Millionen qualifizierte GMail-Adressen

Matthijs R. Koot von der Universität Amsterdam hat gestern einen Artikel gepostet der mich ungläubig mein Terminal aufmachen liess um zu überprüfen, was er da geschrieben hat. Die Liste aller GMail-Nutzer ist abrufbar und zwar ohne mit irgendeiner fiesen Brute-Force-Attacke zu arbeiten. Laut Koot hat er innerhalb eines Monats 35Mio Profile geladen.

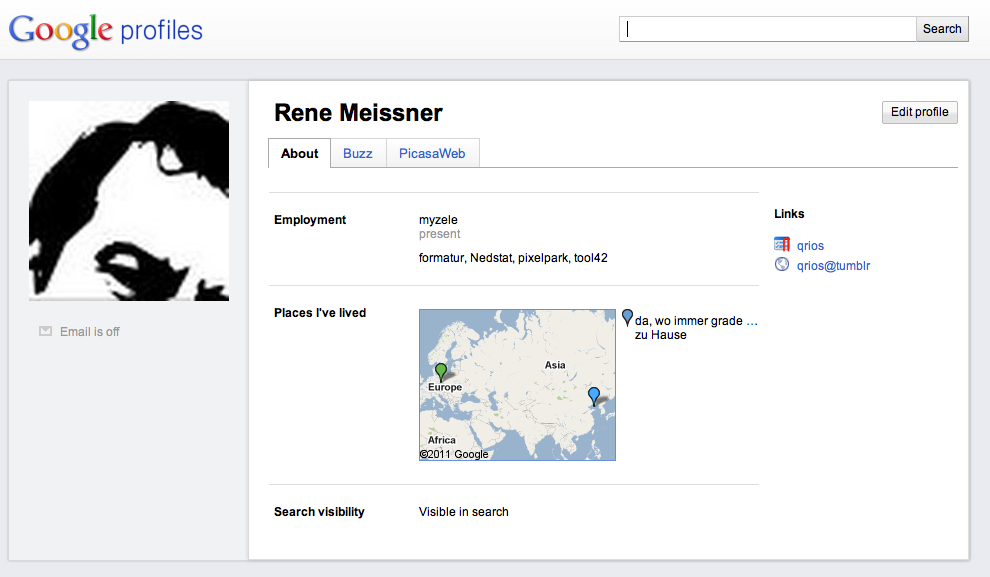

Mein Google-Profil mit Location, Links zu Blog und tumblr und Buzz/twitter

Und tatsächlich erlaubt nach wie vor die robots.txt das automatische Durchforsten. Dank Sitemap-XML bekommt man sogar die komplette Liste frei Haus geliefert.

Die Sitemap enthält ca. 7000 URLs zu weiteren Listen von jeweils 5000 Profilen. Das macht tatsächlich 35.000.000 Profile. Eine Profil-URL enthält im Normalfall den Namen des Nutzers und die Nutzer-ID. Letztere ist offensichtlich identisch mit der GMail-Adresse. Hat der Nutzer – wie ich – weitere Angaben zu seiner Person gemacht sind diese auf dieser Seite verfügbar und können ausgelesen werden.

Bei mir ist zum Beispiel die Verknüpfung von twitter zu Buzz eingestellt, was meine Tweets verfügbar macht. Da ich manchmal auch Google Latitude verwende kann man mit minimalem Aufwand meinen Hauptaufenthaltsort aus der URL zu einer statischen Karte auslesen.

Ich bin mir doch ziemlich sicher, dass die meisten Nutzer von GMail kein gesteigertes Interesse daran haben, dass ihre Adressen mit Nutzernamen, Foto und möglicherweise weiteren Infos wie Picasa-Account in irgendwelchen Datenbanken von meist dubiosen Firmen oder Personen landen. Und ganz ehrlich: von den VZ-Netzwerken habe ich das Bewusstsein für den Schutz der Privatsphäre nicht erwartet. Von Google allerdings schon.

Google Chrome mit Instant Bounce Rate

Googles Chrome-Browser springt von einer Version zur nächsten und ist inzwischen bei Nummer 9 angelangt. Die Neuerungen halten sich meistens in Grenzen und es ist unklar ob in Googles Entwicklungsabteilung nur einige emacs-Gegner arbeiten, die möglichst schnell an dem Editor vorbeiziehen wollen.

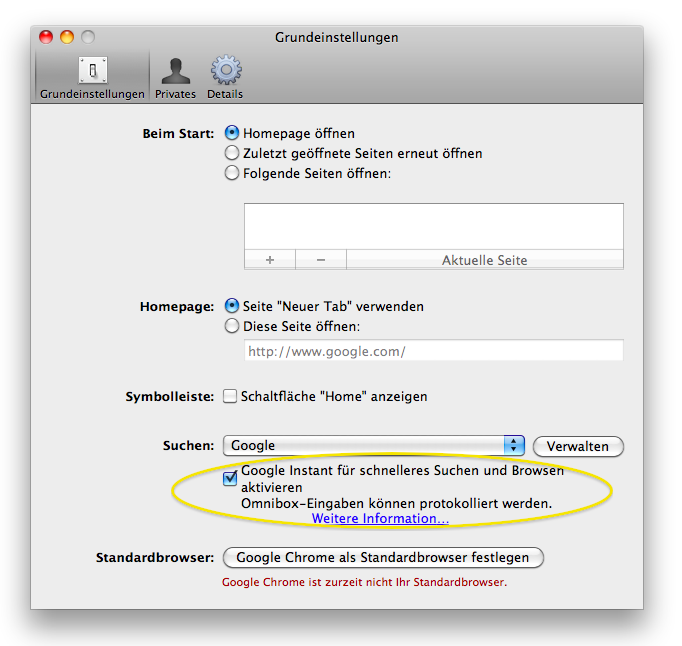

Per Default ausgeschaltet: Google Instant

Mit Google Chrome 9 wurde jetzt eine Funktion eingeführt, die erheblichen Einfluss auf das Verhalten der Nutzer haben könnte. Schaltet man in den Einstellungen “Google Instant” ein wird bereits während der URL-Eingabe die jeweils wahrscheinlichste Seite geladen. Je nach Historie des Surfens wird also bei ‘sp’ entweder spiegel.de oder spreeblick.com geladen.

Mir ist momentan nicht klar, ob eine solche Funktion aus User-Sicht wirklich sinnvoll ist, da ich insgesamt den Eindruck habe, dass viele neue Funktionen zu einer immer kürzer werdenden Aufmerksamkeitsspanne führen.

Auswirkungen hat diese Funktion jedoch auf die Webanalyse und damit auch auf den Betrieb einer Site. Denn in Zukunft werden mehr Seiten aufgerufen und direkt danach wieder verlassen. Die bisher schon sehr schwierig zu beurteilende Bounce Rate wird also steigen. Solange diese Funktion nicht von den anderen Browsern übernommen wird, kann man deren Bounce Rate benutzen, um den Chrome-Faktor zu berechnen. Leichter wird Webanalyse dadurch sicher nicht. Aber es fließen bestimmt noch mehr interessante Daten zu Google.

Über die Dummheit heutigen Retargetings schreibt steingrau

Markus Breuer regt sich in seinem Blog steingrau ausführlich über die heutigen Formen des Retargeting auf. Aber er rantet nicht nur sondern macht auch fünf Verbesserungsvorschläge. Diese halte ich allerdings nicht für erfolgversprechend, da die Regeln der Einblendung mittels statistischer Verfahren bestimmt werden und er somit nicht unter Willkür eines Regulators sondern unter dem Verhalten der anderen Nutzer leidet. Er geht bei seinen Vorschlägen offensichtlich von sich aus und vergisst, dass da draussen inzwischen viele User sind, deren Aufmerksamkeitsspanne im einstelligen Sekundenbereich zu liegen scheint.

Wege aus der Privatsphärenfalle

Es gilt heute bei vielen als gegeben, dass private Datensätze in verschiedenen Datenbanken mittels geeigneter Techniken gematcht werden können und damit ein Bezug zwischen zugeordneten und losen Daten hergestellt werden kann. Oder konkret: wenn ich auf der einen Site mein Geburtsjahr, -ort und Geschlecht angebe und auf der anderen Site den Geburtsort, Geschlecht und Ausbildung, kann ein Dritter mit Zugriff auf beide Datensätze, eine Beziehung zwischen beiden Datensätzen herstellen. Für viele (nicht alle) ist die Vorstellung, dass ihre sauber getrennten Identitäten in verschiedenen sozialen Aspekten verknüpft werden können ein Graus.

Die Frage ist daher, ob es ein Verfahren gibt, die Vorteile von digitalen Identitäten zu geniessen ohne die Kröte der erodierenden Privatsphäre in Kauf nehmen zu müssen. Eine erste Lösung stellte Latany Sweeney 2002 in dem Aufsatz k-Anonymity: A Model for Protecting Privacy dar. Die Idee ist recht einfach. Es werden einfach Daten ‘dequalifiziert’ oder unscharf gemacht. Aus dem Geburtsort könnte so zum Beispiel der Landkreis werden. Eine deutsche Darstellung, wie das Verfahren funktioniert hat Dietmar Hauf von der Uni Karlsruhe veröffentlicht.

In einem neuen Papier auf arXiv beweisen drei Autoren der Purdue University jedoch, dass dieses Verfahren ohne Erweiterung keinen ausreichenden Schutz bietet. Sie verknüpfen in der Arbeit “Provably Private Data Anonymization: Or, k-Anonymity Meets Differential Privacy” das Modell der k-Anonymity mit der als Differential Privacy bezeichneten Methode, die zum Beispiel für den facebook-Gegenentwurf diaspora diskutiert wird.

Do Not Track: formerly known as Schwachsinn

In Deutschland ist es per Gesetz untersagt, IP-Nummern zu speichern. Daran hält sich jedoch kaum jemand. In meiner Praxis habe ich bisher kaum eine Apache-Konfiguration gesehen, die als Log-File-Format nicht ‘combined‘ oder ‘common‘ verwendet hat. Beide Einstellungen speichern die IP-Adressen der User dauerhaft. Es hat mich jedesmal Überzeugungsarbeit (mit Hinweis auf die Probleme, die mal eine Justizministerin hatte) gekostet, dies zu ändern.

Wenn ein Gesetz und Strafandrohung bei Anbietern nicht dazu führen, dass IP-Nummern nicht gespeichert werden, wie bitte sollte ein http-Header mit der Aussage ‘do not track me’ dazu führen, dass Werbetreibende kein Targeting durchführen.

“Do not Track” soll in Zukunft im http-Header übermitteln, dass der User vor diesem Browser nicht wünscht, analysiert zu werden. Sozusagen eine Tarnkappe mit dem Hinweis “Falls Sie mich doch sehen, ignorieren Sie mich doch bitte!“.

Nun könnte man natürlich vermuten, dass Firmen wie Doubleclick sich in Zukunft hüten werden, Cookies an den Browser zu schicken. Natürlich werden sie das tun. Aber das hindert sie nicht daran, trotzdem profilierte Werbung auszuliefern. In Zukunft wird ein Retailer von seinen Werbenetzwerken einfach verpflichtet (respektive Preisnachlässe erhalten), Cookies verschiedener Partner durchzureichen. Dieses Durchreichen geschieht schon heute. Denn die Anbieter sind schon heute nicht unabhängig. Netzwerk X arbeitet bezüglich Branche Y mit Netzwerk Z zusammen.

Wenn ein User dann bei Shop A (wg. der Funktionen des Shops, zwinker, zwinker …) gezwungen wird, Cookies zu akzeptieren, werden diese an das Netzwerk durchgereicht. Wenn es nicht anders geht mit Hilfe von Mengenabfragen à la History-Hijacking.

Aber selbst dieses recht komplizierte Szenario muss eigentlich nicht bemüht werden. Denn mit dem Browser-Fingerprint gibt es eine funktionierende Methode der Wiedererkennung eines Systems an Hand von Browser- und Systemumgebung, ohne eine ID auf dem/vom Rechner des Users zu speichern/abzufragen.

Schlussendlich gibt es aber niemanden (am wenigsten einen Richter), der in der Lage wäre, zu unterscheiden, ob die technischen Umgebungsvariablen so sind wie sie sind, weil jemand wollte, dass sie so sind wie sie sind oder weil eine Standardkonfiguration meinte, dass es eine gute Idee wäre, dass sie so seien, wie sie sind.

Und – ganz ehrlich – glaubt irgendwer im Raum, dass facebook seine Like-It-Funktion disabled, wenn ein User die DNT-Funktion eingeschaltet hat? Mit jedem Recht kann facebook behaupten, dass diese Funktion nicht dem Tracking dient sondern der Kommunikation. Wenn diese Argumentation funktioniert, werden in Zukunft auch lauter Googles, Zanoxes und andere eine Community aufbauen. Haben sie schon versucht? In Zukunft werden sie wissen, warum es sich lohnt, selbst wenn sie NULL User haben …

Wissen Sie “Ich hab’s Ihnen ja gesagt” trifft es nicht so ganz.

In der WebAnalytics-Branche wird man langsam nervös. Die Federal Trade Commission in den USA hat einen Vorschlag vorgelegt, der den Usern von Webseiten in Zukunft ermöglichen soll, “Do Not Track”-Button zu drücken. Ein Site-Betreiber soll dann jegliches Tracking dauerhaft abschalten. Der Button geht mir eigentlich noch nicht weit genug. Ich folge da eher der EU, die denkt offensichtlich nicht nur an Opt-Out sondern sogar an Opt-In.

“Ich hab’s Ihnen ja gesagt” (1996, vor kurzem) trifft es nicht so ganz (2004) …

Un-heimliche Entwicklungen

In den USA taucht in letzter Zeit das Thema Ad-Targeting verstärkt auf. Unter anderem schreibt das WSJ einen ausführlichen Artikel über die Funktionsweise von Targeting und die Federal Trade Commission sieht sich genötigt, sich mit dem Thema zu beschäftigen.

Wer schon länger in der Online-Branche arbeitet kennt Firmennamen wie Net Percetpions, Wunderloop (the company formerly known as 7d) und nugg.ad (grade von der Deutschen Post gekauft). Alle beschäftigen sich – oder taten dies – mit “Behavioral Targeting”. Neu hinzugekommen ist das sogenannte Retargeting (hier regt sich Wiederstand dagegen). Im Kern geht es darum aus dem bekannten Verhalten des speziellen Nutzers und aus dem Verhalten aller anderen Nutzer Echtzeitempfehlungen an Serverapplikationen zu geben.

Die einfachste Empfehlung könnte zum Beispiel sein: zeige diesem User jetzt die Werbung von Nike, weil er diese noch nicht gesehen hat. Eine komplexere Empfehlung wäre beispielsweise: zeige dem User die Online-Pokeranzeige von Firma XY mit der leichtbekleideten Frau, da er Nachmittags in seinem Büro immer erotische Seiten aufruft und neulich schon einmal auf eine Werbung für ein kostenloses Pokerspiel geklickt hat.

Das Problem an dieser Form der Werbung ist, dass sie bisher für das breite Publikum vollkommen intransparent ist. Die normalen User finden es – so es ihnen denn überhaupt auffällt – einen lustigen Zufall, dass sie jetzt schon zum dritten mal die Zalando-Werbung mit den immer gleichen Schuhen sehen. Wenn man ihn dann mit der Funktionsweise konfrontiert, fällt er meistens aus allen Wolken.

Für mich ist die Tatsache, dass es so viel Unwissenheit auf der Nutzerseite gibt, eigentlich ein deutliches Indiz dafür, dass es ein berechtigtes Interesse der Branche gibt, die Verfahren zu verstecken. Und deswegen unterscheiden sich die Anbieter aus meiner Sicht auch nicht von Spammern. Die logische Forderung ist daher Opt-In für alle Datensammler und -verwerter. Alles andere ist bewusster Betrug.

@caveman (2.0)

@holadiho wollte eigentlich nicht mehr nach 18:00 bloggen. Was für mich irgendwie nach “da bin ich immer viel zu schludrig” klang. Am späten Abend sah er sich aber dann doch noch mal genötigt, das Thema Privatsphäre und Datenschutz aufzugreifen.

In dem Post “Post Privacy und Väterchen Datenschutz” legt er dar (und nach), warum er kein Problem mit dem Verstreuen von Daten hat und warum wir das in Zukunft immer öfter bewusst tun werden. Quasi als alltägliches Handwerkszeug beim Jonglieren mit multiplen Identitäten.

[Update]

Ab hier beginnt die 2. Version meines Posts. Die erste Version war leider – wie @holadiho richtig bemerkte – sehr undeutlich.

Die Kernthese von @holadiho besteht in folgender Aussage:

Freunde – will ernsthaft noch einer mit den Konzepten des klassischen Datenschutzes operieren in diesem Umfeld? Also mit Datensparsamkeit, Datenvermeidung usw.?

und weiter:

Wir wollen unsere Daten zur Verfügung stellen, speichern lassen, öffentlich zugänglich machen, zu Werbezwecken auswerten lassen usw. – w i r w o l l e n e s!

Diese These wird flankiert von einem fadenscheinigen Szenario in dem ein Geheimdienstmitarbeiter auf der Basis von @holadihos Verkehrsdaten ein Profil erstellen möchte. Er führt aus, dass es doch viel sinnvoller wäre gleich seine Twitter-Timeline als Quelle zu nutzen immerhin würde er ja in jedem Tweet die GPS-Daten mitloggen.

O.k. dann schauen wir uns doch mal seine Timeline und die dazugehörigen GPS-Informationen an. Eine Abfrage der Twitter-API zeigt als erstes, dass @holadiho verschiedene Clients zum twittern nutzt. Bei den letzten 200 Tweets hat allerdings keiner davon die dafür vorgesehene Methode der Geo-Locations verwendet. Bei dem untersuchten Zeitraum setzt offensichtlich nur ÜberTwitter die Koordinaten. Das tut es aber offensichtlich nur sehr sporadisch oder kann @holadiho über einen Hubschrauber-Shuttle-Service verfügen? Denn am 18.2. schrieb er um 23:00:28 von der Prenzlauer Allee Ecke Danziger und 74 Sekunden später aber von der Warschauer Brücke. Laut Google benötigt man mit dem Auto 11 Minuten. Er scheint sich auch nur kurz in der Nacht an seiner Arbeitsstelle eingefunden zu haben, denn ca. 13 Minuten später war er bereits wieder an der Prenzlauer Allee.

Wie verlässlich die Daten sind, die er der ganzen Welt mitteilen möchte sieht man sehr schön an diesem Tweet:

I’m at Bonsoir Clara (Rue Antoine Dansaert 22-26, Brussels). http://4sq.com/9Pb0EX

Auch hier findet sich in den Daten der Twitter-API keine Geo-Location. Wieder gibt es nur die Location-Information in der User-Section, die eigentlich dafür gedacht ist, die Homebase eines Nutzers zu beschreiben. Insbesondere für Vielflieger eine sinnvolle Einrichtung. @holadiho befindet sich laut Tweet also grade in Brüssel – dort geht es nebenbei um Datenschutz in der EU – laut Twitter ist er aber hier: 52.50537,13.450062 in seiner Firma an der Warschauer Brücke in Berlin.

Warum mache ich mir die Mühe? Ich möchte darauf hinweisen, dass schon heute die deutsche Exhibitionistenelite keinerlei Kontrolle über die Daten hat, die sie preisgeben. Er behauptet und ist bisher sicher davon überzeugt, dass er mit jedem Tweet seine GPS-Position veröffentlichen würde. In meiner Timeline tut dies allerdings nur @343max.

Von einer bewussten Steuerung der Datenfreigabe kann also keine Rede sein. Wenn @saschalobo erst in einem Buzz fragen muss, wer der Verursacher von irgendwelchen Weiterleitungen eines Dienstes in einen anderen sein kann, dann bedarf es keiner großen Phantasie sich vorzustellen, welche Probleme Otto Normalverbraucher damit heute und erst recht in Zukunft haben wird.

Die Exhibitionistenelite kennt den Wert ihrer Daten. Es geht in jedem Fall um Selbstvermarktung. Und jeder gelesene Tweet ist ein potentiell wertvoller Kontakt, der in der Zukunft zu einer Conversion führen könnte. @holadiho subsumiert diese Gruppe mit einem ‘wir’. Ich stimme @tristessedeluxe zu, wenn er dies moniert. Für den weitaus größten Teil der Netzuser dürften die Ängste vor dem Kontrollverlust wesentlich evidenter sein als der spielerische Umgang mit der Selbstvermarktung.

@holadiho glaubt an eine Entwicklung, die er post-privacy nennt und die im Kern in einem bewussten und spielerischen Umgang der Nutzer mit ihren Daten besteht. Aber woher soll diese Fähigkeit kommen, wenn nicht dadurch, dass wir permanenten Zugriff auf alle persönlichen Daten haben und zum Beispiel mit einem Klick ein whipe out durchführen können. Eine solche Tabula Rasa müsste nämlich nicht nur meinen facebook-Account löschen können sondern auch Zugriff auf alle Datenbanken haben in denen Kopien (und Kopien der Kopien …) dieser Account-Informationen stecken.

Der spielerische und kreative Umgang mit den eigenen Identitäten wird erst möglich sein, wenn wir die wirkliche Hoheit über unsere Daten haben.

[/Update]

privacy – habt euch nicht so, oder wie?

Mitten im Netz tun sich tiefe Gräben auf. Auf der einen Seite steht der CCC mit Frank Rieger und Constanze Kurz und auf der anderen Seite Blogger wie mspro und holadiho. Ihr Schlachtfeld ist die FAZ. Gekämpft wird um die Hoheit über den Datenluftraum.

Es sah nach dem letzten Buch (Payback) vom Mitherausgeber der FAZ Frank Schirrmacher noch so aus, als ob die Fronten deutlich zwischen Offline und Online verlaufen müssten. Nun wird deutlich, dass dieser Diskurs auch die Netzgemeinde spaltet. Die grundsätzliche Frage steht im Raum: Sind unsere Daten ein schützenswertes Gut?

Die Position des CCC ist in dieser Frage eindeutig: die Hoheit über die Daten muss in jedem Fall der Verursacher haben. Staat und Wirtschaft sollten darauf nur mit expliziter Genehmigung und nur für eindeutige Zwecke Zugriff haben. Der CCC-Standpunkt hat sich über die Jahrzehnte seines Bestehens nicht verändert.

mspro: Die Daten sind nicht schützbar, wir sollten das akzeptieren.

Die Position von mspro ist (wie immer) radikal: ein umfassender Schutz ist nicht möglich und das ist auch gut so. Jedes Datum wird früher oder später mit anderen Daten verknüpft werden. Und wir haben keine Ahnung welche Methoden in Zukunft verwendet werden können jede vorhandene Information aus einem Datum zu extrahieren. Wir sollten uns damit abfinden und die dadurch stattfindende Änderung der Gesellschaft aktiv betreiben. (Er sagt das etwas verschwurbelter, aber das ist glaube ich der Kern. Und prompt watscht ihn Donald von Soundso mit dem Hinweis ab, dass es einen Unterschied zwischen Tonscherben in einem verschütteten Herd und Tonscherben in einer verschütteten Müllgrube gäbe – oder so.)

holadiho: So viel findet man in den Daten gar nicht.

Eine etwas andere Richtung schlägt Stefan Noller in seinem Blog beimnoller ein. Und es entbehrt nicht einer gewissen Komik, wenn er die Algorithmen entmystifizieren will, die für die ‘Anreicherung’ von Daten verwendet werden. Denn sein job ist es, Kunden davon zu überzeugen, dass mittels dieser Algorithmen eine höhere Wertschöpfung (‘Conversion’) mit Online-Werbung erzielt werden kann. Er ist immerhin Chef einer Firma, die als eine der erfolgreichsten im Bereich Behavioral Targeting gilt. Dafür fängt er sich postwendend eine Watsche von Hal Faber ein.

Ihre Standpunkte unterscheiden sich wesentlich bei der Frage, welch Zauberwerk Algorithmen verbringen können.

Um es ganz klar zu sagen, mspro hat recht. Denn jede Information, die in einem Datensatz vorhanden ist, kann extrahiert werden. Letztlich ist es nur eine Frage, der eingesetzten Energie. Da die Energiekosten pro Transaktion permanent sinken, werden in Zukunft Transformationen wirtschaftlich sinnvoll sein, die es momentan nicht sind (siehe).

Ich muss holadiho zustimmen, dass viele Nerds bei ihrer Argumentation ein eher mechanistisches Weltbild an den Tag legen. Allerdings gehe ich davon aus, dass wir bald Software für die Analyse von Daten verwenden werden, die sich nicht oder nicht nur auf statistische Algorithmen stützen sondern die auf selbstorganisierenden Systemen basiert. Ob ein Gesichtserkennungssystem mit einem Bild von mir trainiert wird, oder mit meinen Bewegungsmustern im Netz ist vollkommen egal. Es wird mich mit hoher Wahrscheinlichkeit erkennen, wenn ich wieder auf der Site bin.

Die Situation ist vergleichbar mit den Ölsanden. Es gibt sie schon lange, aber erst seit kurzem lohnt es sich, sie auch zu fördern und in den Rohstoff umzuwandeln, den die chemische Industrie für Tupper-Dosen benötigt.

Zwei kleine Einschränkungen bezüglich der Möglichkeiten der Informationsgewinnung aus Daten gibt es allerdings. Erstens altern Daten. D.h. Daten die das Verhalten einer Person vor einem Jahr beschreiben sind hochwertiger als entsprechende Daten von vor zehn Jahren. Diese Tatsache lässt sich in Modellen berücksichtigen.

Zweitens bewirkt jede Transformation mit gleichzeitigem Transport von Daten einen Datenverlust. Konkret: wenn ich die Daten aus einem System mit Daten in einem anderen System verknüpfen will, werde ich dies nur tun können, wenn ich eine gewisse Unschärfe hinnehme. Dieser kann darin bestehen, dass die Schemata der beiden Datensätze nicht vollkommen transformierbar sind oder dass es für manche Datensätze keine Referenz gibt. Die Anreicherung von Daten durch Verknüpfung verschiedener Datenquellen führt also nicht nur zu einer höhern Qualität der Daten sondern gleichzeitg zu einem Verwischungseffekt.

Letztendlich bleibt aber die Tatsache, dass sich Daten durch immer leistungsfähigere Maschinen und größere Datenspeicher in Zukunft reproduzieren und die enthaltenen Informationen immer leichter extrahieren lassen. In der Gesellschaft in der wir heute leben hat das Bewustsein darüber einen einfachen Effekt: eine Person, die sich dieser Tatsache bewusst ist, wird sich anders verhalten als eine Person, der dies nicht bewusst ist. Der offene Diskurs im Netz kann unter diesen Umständen schon heute nicht mehr so offen sein. Und wenn in Zukunft immer öfter im realen Leben Aufzeichnungen selbst von privaten Zusammenkünften gemacht werden (z.B. mittels Videobrillen) muss sich auch dort das Verhalten ändern.

Natürlich wird es Menschen geben, die sich – wie mspro es fordert – dem Kontrollverlust hingeben. Es würde mich jedoch wundern, wenn dies eine größere Gruppe wäre. Und ich vermute sogar, dass mir die Handlungen der Mehrheit dieser Gruppe ganz und gar nicht gefallen wird (Stichwort Rape-Videos).

abofallen in app-werbung

Iphone-Ticker berichtet über gehäuft auftretende Abofallen durch Werbung in iPhone-Apps und Bannern. Dabei wird offensichtlich durch einen Klick auf eine solche Werbung die Telefonnummer an den Anbieter übertragen, damit dieser dem Provider gegenüber von einem gültigen Vertrag sprechen kann und die Abo-Gebühren durch diesen einziehen kann.

Die Frage, die sich alle stellen: Wie kommen die Abzocker an die Telefonnummer?

Die Sache ist mitnichten so, dass das Banner diese Information durch das iPhone, die App oder gar durch den Mobile Safari erfährt. Die Schwachstelle ist der Mobilfunkbetreiber. Dieser hat z.B. mit dem Werbetreibenden einen Vertrag. Teil dieses Vertrages ist in etlichen Fällen die Übermittlung der Mobilfunknummer.

Solche Verträge finden sich zum Beispiel sehr häufig bei MBOs. Wenn also eine Firma (Verlag, Mode) selbst als Wiederverkäufer für ein Mobilfunknetz auftritt und für die eigenen Seiten ein kostenlosen Aufruf garantiert, wird dies über die Übermittlung der Mobilfunknummer kontrolliert.

Der hohe Anteil der iPhone-User beim Aufruf von mobilen Bannern und die ebenfalls relativ hohe Klickrate führt offensichtlich dazu, dass dieses Thema in der Öffentlichkeit oft im Zusammenhang mit dem iPhone auftaucht.